目 录CONTENT

以下是

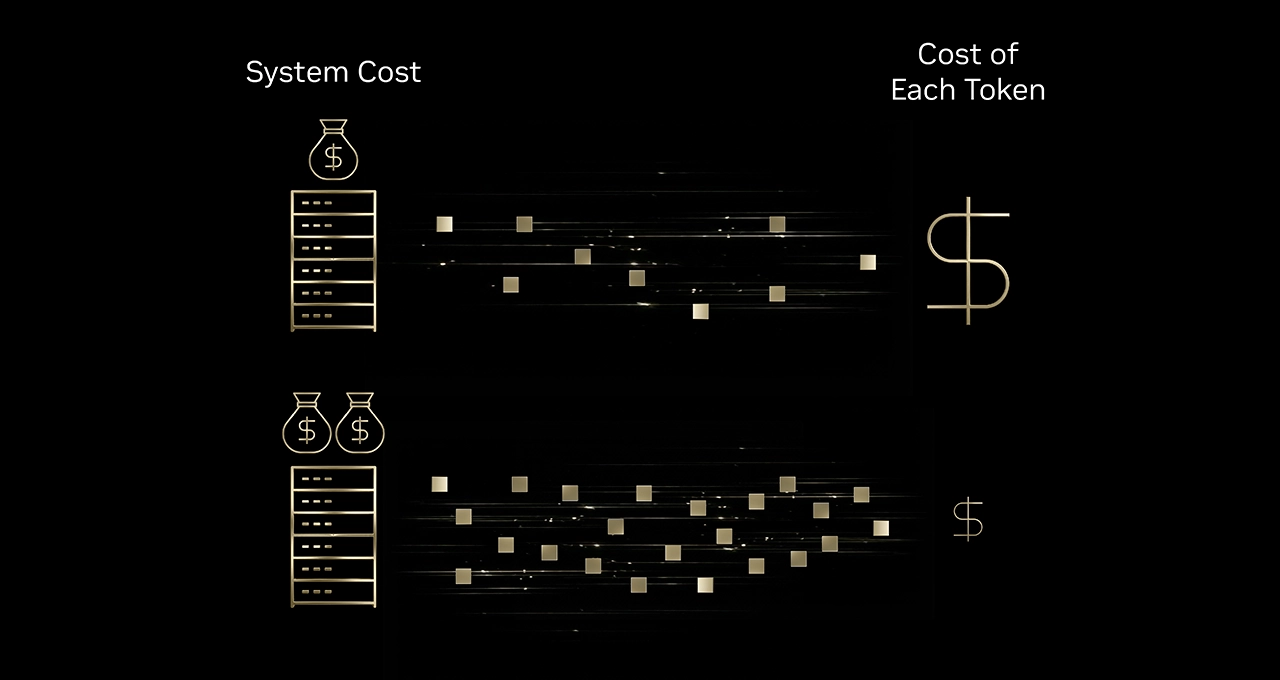

Mixture-of-Experts

相关的文章

-

-

-

-

谷歌 Gemini 1.5 Pro 预览版发布:原生支持 100 万上下文窗口,可处理 1500 页文档或 1 小时视频 谷歌正式推出了下一代 AI 模型 Gemini 1.5 Pro 预览版,该模型最引人注目的升级是其原生支持高达 100 万个上下文 token,在特定情况下甚至可扩展至 200 万 token。这一能力使其能够一次性处理海量信息,例如完整的书籍、11 小时的音频或 1 小时的视频内容,从而极大地提升了 AI 的理解和推理深度。Gemini 1.5 Pro 采用了新的 Mixture-of-Experts (MoE) 架构,在保持高性能的同时,显著提高了推理效率和速度,为开发者和企业带来了更...

谷歌 Gemini 1.5 Pro 预览版发布:原生支持 100 万上下文窗口,可处理 1500 页文档或 1 小时视频 谷歌正式推出了下一代 AI 模型 Gemini 1.5 Pro 预览版,该模型最引人注目的升级是其原生支持高达 100 万个上下文 token,在特定情况下甚至可扩展至 200 万 token。这一能力使其能够一次性处理海量信息,例如完整的书籍、11 小时的音频或 1 小时的视频内容,从而极大地提升了 AI 的理解和推理深度。Gemini 1.5 Pro 采用了新的 Mixture-of-Experts (MoE) 架构,在保持高性能的同时,显著提高了推理效率和速度,为开发者和企业带来了更...