📢 转载信息

原文链接:http://bair.berkeley.edu/blog/2025/03/25/rl-av-smoothing/

原文作者:Nathan Lichtlé, Kathy Jang, Eugene Vinitsky, Adit Shah, Jonathan W. Lee, and Alexandre M. Bayen

我们在高峰时段的高速公路上部署了 100 辆由强化学习(RL)控制的汽车,以平顺交通拥堵并为所有人降低燃料消耗。 我们的目标是解决“走走停停”的波动现象——那些通常没有明确原因,但会导致拥堵和大量能源浪费的令人沮丧的加减速。

为了训练高效的交通平顺控制器,我们构建了快速、数据驱动的仿真环境,让强化学习智能体与之互动,学习如何在保持吞吐量和在人类驾驶员周围安全运行的同时,最大化能源效率。

总的来说,少量控制良好的自动驾驶汽车(AVs)就足以显著改善道路上所有驾驶员的交通流量和燃油效率。此外,训练好的控制器设计为可部署在大多数现代车辆上,以去中心化的方式运行,并依赖于标准的雷达传感器。在我们最新的论文中,我们探索了将 RL 控制器从仿真部署到实际部署的大规模挑战,这是在这次 100 辆汽车实验中进行的。

“幽灵堵车”的挑战

一个“走走停停”的波浪在高速公路上向后传播。

如果你开车,你肯定体验过“走走停停”波浪的烦恼:那些看似莫名其妙的交通减速,突然出现又突然消失。这些波浪通常是由于我们驾驶行为中的微小波动,在车流中被不断放大造成的。我们会根据前车的速度自然地调整自己的速度。如果车距拉开,我们会加速跟上;如果他们刹车,我们也会减速。但由于我们的反应时间不为零,我们可能刹车比前车稍微重一点。后面的驾驶员也会这样做,这种放大效应持续下去。随着时间的推移,最初微不足道的减速在交通后部变成完全停止。这些波浪在车流中向后移动,由于频繁的加速,导致能源效率大幅下降,同时增加了 $\text{CO}_2$ 排放和事故风险。

这并非孤立现象!当交通密度超过某个临界阈值时,这些波浪在繁忙的道路上无处不在。那么我们如何解决这个问题呢?传统的匝道控制(ramp metering)和可变限速等方法试图管理交通流量,但它们通常需要昂贵的基础设施和集中协调。一个更具可扩展性的方法是使用自动驾驶汽车(AVs),它们可以实时动态调整驾驶行为。然而,仅仅将自动驾驶汽车插入到人类驾驶员中间是不够的:它们还必须以更智能的方式驾驶,从而让所有人的交通状况都变得更好,这就是强化学习(RL)发挥作用的地方。

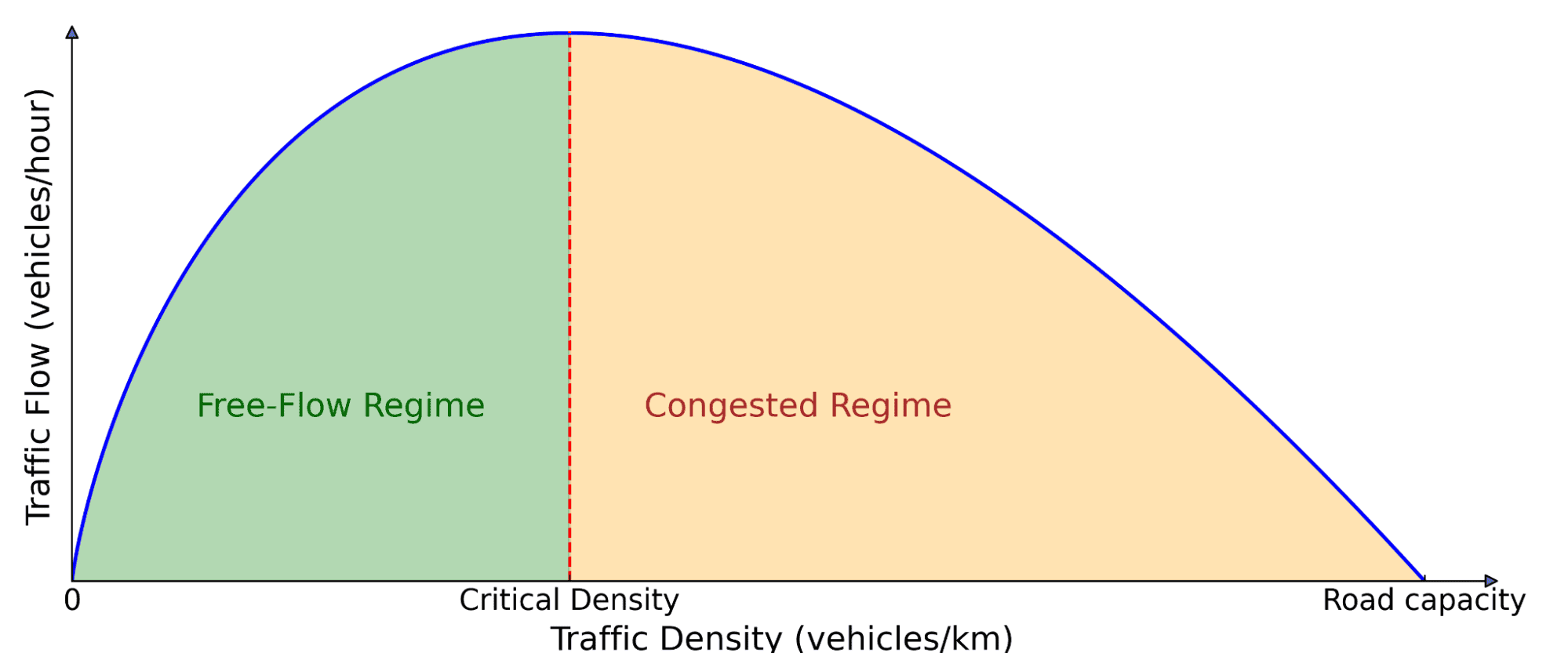

交通流的基本图。路上的汽车数量(密度)会影响向前移动的交通量(流量)。在低密度下,增加更多的汽车会增加流量,因为有更多的车辆可以通过。但在超过临界阈值后,汽车开始相互阻碍,导致拥堵,此时增加更多的汽车实际上会减慢整体移动速度。

用于波浪平顺的强化学习自动驾驶汽车

强化学习是一种强大的控制方法,智能体通过与环境的交互来学习最大化奖励信号。智能体通过试错收集经验,从错误中学习,并随着时间的推移而改进。在我们的案例中,环境是一个混合自主交通场景,其中自动驾驶汽车学习驾驶策略,以抑制“走走停停”的波浪,并降低它们自身和附近人类驾驶车辆的燃料消耗。

训练这些 RL 智能体需要具有逼真交通动态的快速仿真,能够复制高速公路“走走停停”的行为。为此,我们利用了在田纳西州纳什维尔附近的 24 号州际公路(I-24)收集的实验数据,并用它来构建仿真环境,车辆在其中重放高速公路轨迹,产生不稳定的交通流,让后方的自动驾驶汽车学习去平顺化。

仿真重放了一个表现出多个“走走停停”波浪的高速公路轨迹。

我们在设计自动驾驶汽车时就考虑到了实际部署,确保它们仅使用关于自身和前方车辆的基本传感器信息即可运行。观测数据包括自动驾驶汽车的速度、前车速度以及它们之间的距离间隙。基于这些输入,RL 智能体会指示自动驾驶汽车的瞬时加速度或目标速度。仅使用这些局部测量值的关键优势在于,RL 控制器可以去中心化地部署在大多数现代车辆上,而无需额外基础设施。

奖励设计

最具挑战性的部分是设计一个奖励函数,当它被最大化时,能够与我们希望自动驾驶汽车实现的各种目标保持一致:

- 波浪平顺化: 减少“走走停停”的振荡。

- 能源效率: 降低所有车辆(不只是自动驾驶汽车)的燃料消耗。

- 安全性: 确保合理的跟车距离并避免突然刹车。

- 驾驶舒适性: 避免激进的加速和减速。

- 遵循人类驾驶规范: 确保“正常”的驾驶行为,不让周围的驾驶员感到不适。

平衡所有这些目标是很困难的,因为必须找到每个部分的合适系数。例如,如果最小化燃料消耗在奖励中占主导地位,RL 自动驾驶汽车就会学会停在高速公路中间,因为那样在能源上是最优的。为了防止这种情况,我们引入了动态的最小和最大间隙阈值,以确保安全合理的行为,同时优化燃油效率。我们还惩罚自动驾驶汽车后方人类驾驶车辆的燃料消耗,以阻止其学习一种自私的行为,即以牺牲周围交通为代价来优化自动驾驶汽车的能源节省。总而言之,我们的目标是在节能和拥有合理且安全的驾驶行为之间取得平衡。

仿真结果

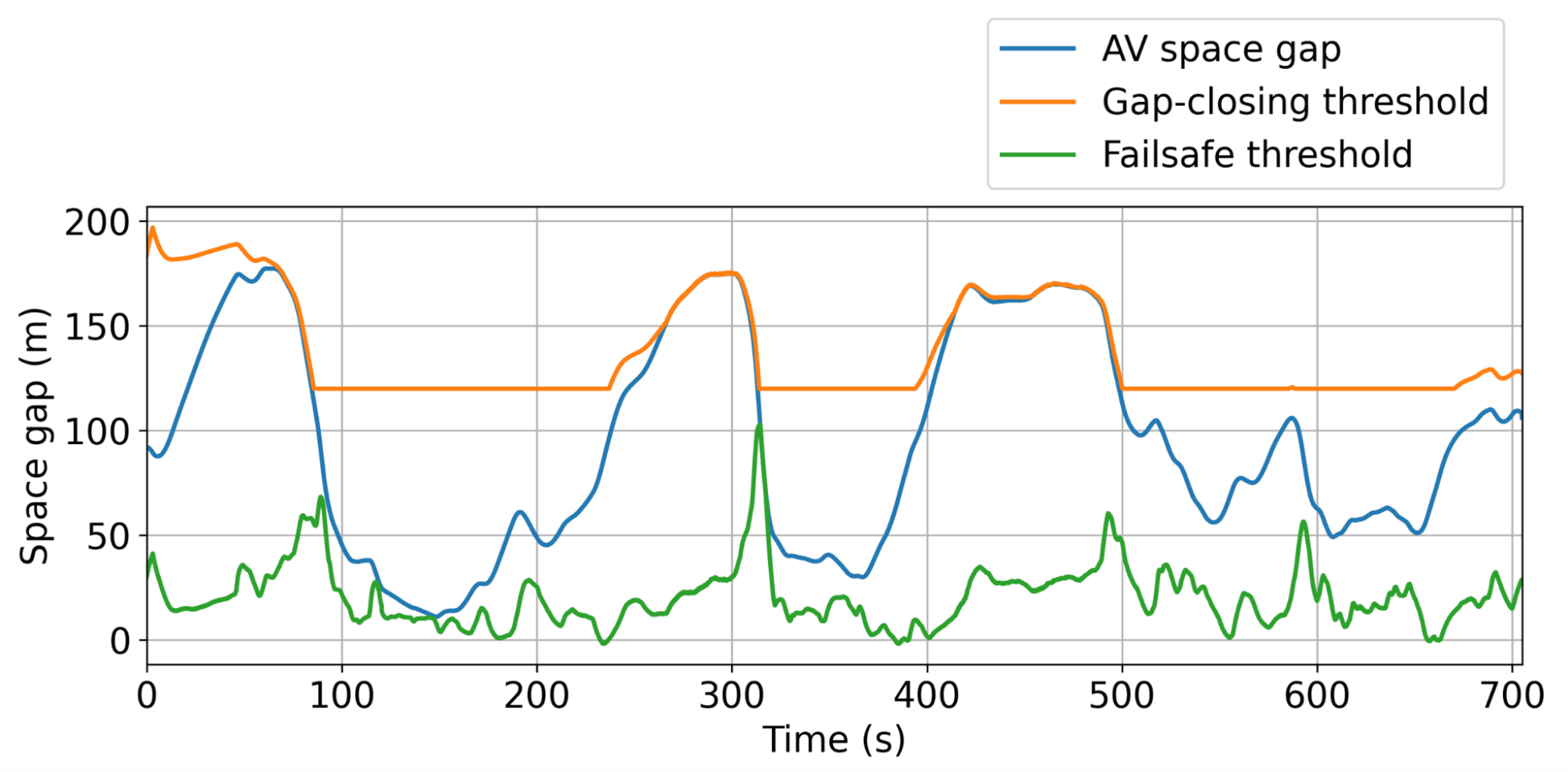

动态最小和最大间隙阈值的说明,在此范围内,自动驾驶汽车可以自由操作,以尽可能高效地平顺交通。

自动驾驶汽车通常学会的行为是保持比人类驾驶员稍大的间隙,这使它们能够更有效地吸收即将到来的、可能的突然的交通减速。在仿真中,这种方法在最拥堵的情况下,在不到 5% 的自动驾驶汽车在场的情况下,为所有道路使用者带来了高达 20% 的显著燃料节省。而且这些自动驾驶汽车不必是特殊的车辆!它们可以只是配备了智能自适应巡航控制(ACC)的普通消费汽车,这也是我们在规模化测试中所采用的。

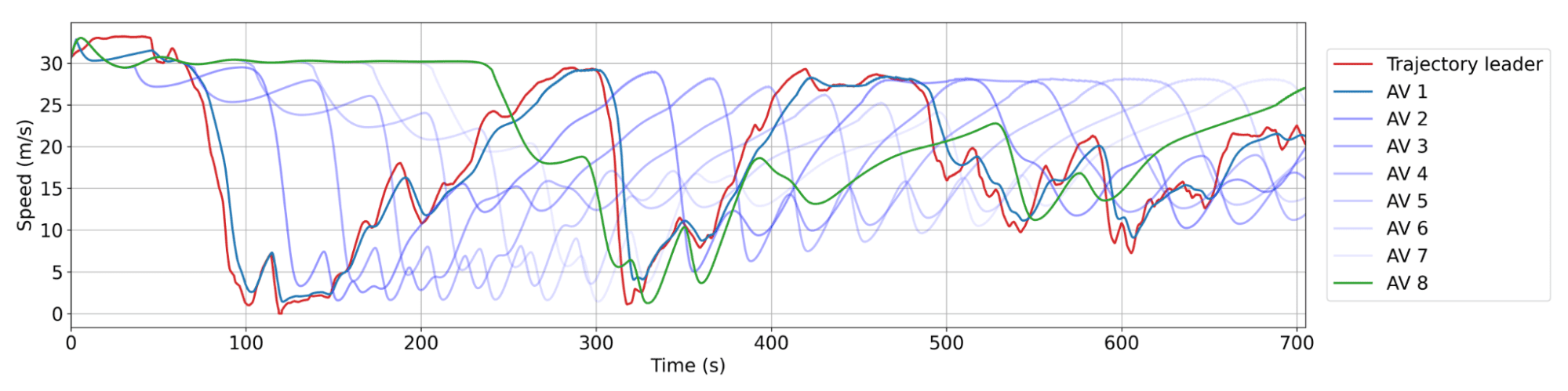

RL 自动驾驶汽车的平顺行为。 红色:来自数据集的人类轨迹。蓝色:车队中连续的自动驾驶汽车,其中 AV 1 是最靠近人类轨迹的。AV 之间通常有 20 到 25 辆人类驾驶汽车。每辆自动驾驶汽车的减速幅度或加速幅度都比其领航车小,从而随着时间的推移导致波幅减小,从而实现节能。

RL 自动驾驶汽车的平顺行为。 红色:来自数据集的人类轨迹。蓝色:车队中连续的自动驾驶汽车,其中 AV 1 是最靠近人类轨迹的。AV 之间通常有 20 到 25 辆人类驾驶汽车。每辆自动驾驶汽车的减速幅度或加速幅度都比其领航车小,从而随着时间的推移导致波幅减小,从而实现节能。

100 辆自动驾驶汽车现场测试:大规模部署 RL

我们在实验周期间停在我们运营中心的 100 辆汽车。

鉴于仿真结果令人鼓舞,自然而然的下一步就是弥合从仿真到高速公路的鸿沟。我们将训练好的 RL 控制器部署在 I-24 上 100 辆汽车上,在持续数天的交通高峰时段进行测试。这项被称为 MegaVanderTest 的大规模实验,是有史以来规模最大的混合自主交通平顺实验。

在现场部署 RL 控制器之前,我们对其进行了广泛的仿真训练和评估,并在硬件上进行了验证。总的来说,部署步骤包括:

- 在数据驱动的仿真中训练: 我们使用来自 I-24 的高速公路交通数据创建了一个具有逼真波浪动态的训练环境,然后在各种新交通场景中验证了训练好的智能体的性能和鲁棒性。

- 部署到硬件: 在机器人软件中验证后,训练好的控制器被上传到汽车上,能够控制车辆的设定速度。我们通过车辆的机载巡航控制系统进行操作,该系统充当低级安全控制器。

- 模块化控制框架: 测试中的一个关键挑战是无法获得前方车辆信息传感器。为克服这一问题,RL 控制器集成到一个分层系统中,即 MegaController,该系统结合了一个考虑下游交通状况的速度规划指南,并将 RL 控制器作为最终决策者。

- 硬件验证: RL 智能体被设计为在一个大多数车辆都是人类驾驶的环境中运行,因此需要适应不可预测行为的鲁棒策略。我们通过在严密的人工监督下在道路上驾驶 RL 控制的车辆来验证这一点,并根据反馈对控制进行修改。

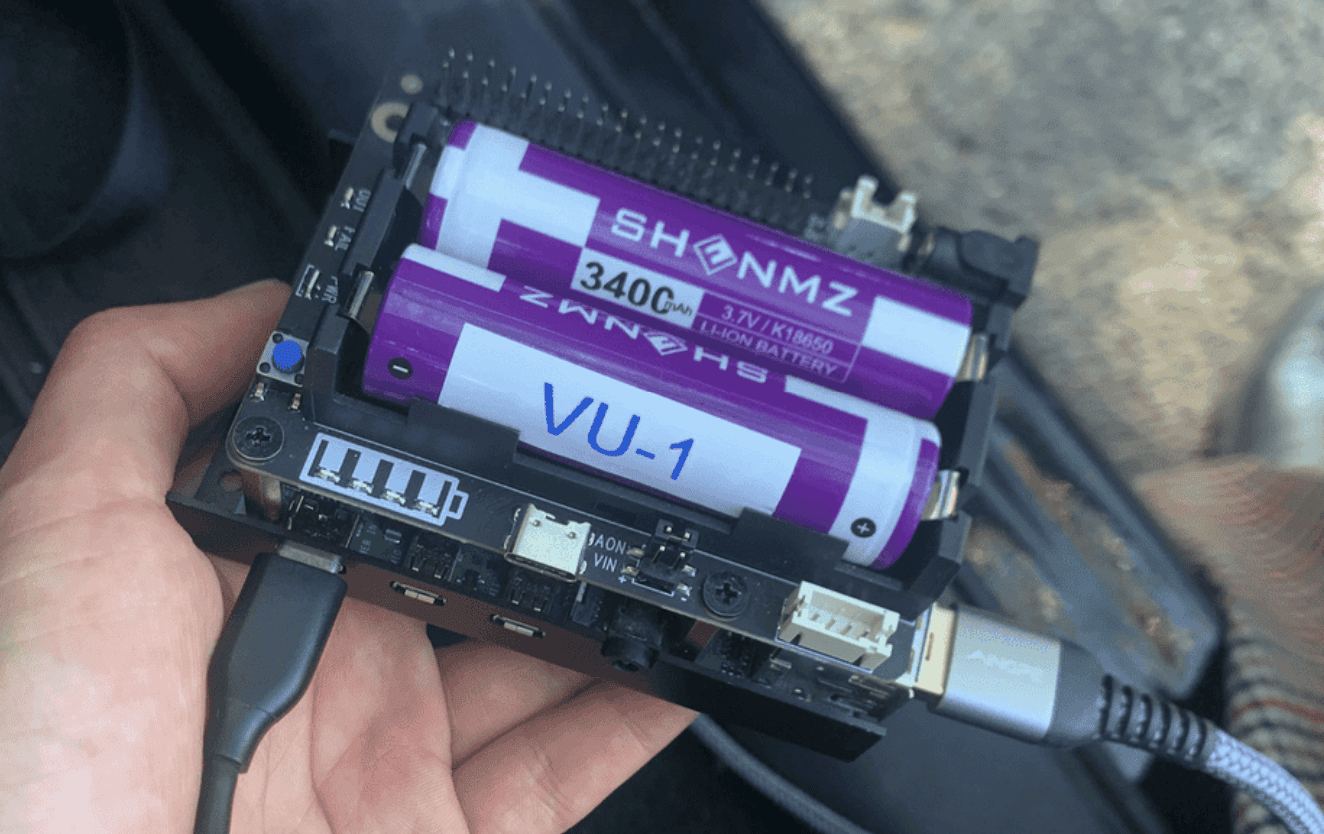

100 辆汽车中的每一辆都连接到一个 Raspberry Pi,RL 控制器(一个小型神经网络)部署在该 Pi 上。

100 辆汽车中的每一辆都连接到一个 Raspberry Pi,RL 控制器(一个小型神经网络)部署在该 Pi 上。

RL 控制器直接控制车载自适应巡航控制(ACC)系统,设定其速度和期望的跟车距离。

RL 控制器直接控制车载自适应巡航控制(ACC)系统,设定其速度和期望的跟车距离。

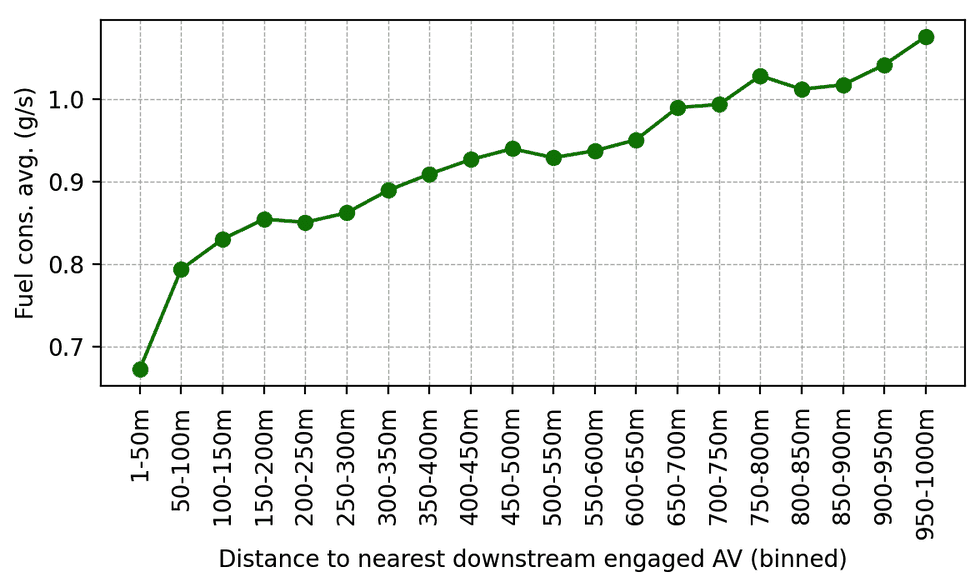

验证完成后,RL 控制器被部署到 100 辆汽车上,并在早高峰时段在 I-24 上行驶。周围的交通对实验一无所知,确保了驾驶员行为的公正性。实验期间,数据是从沿着高速公路设置的数十个高空摄像头中收集的,这通过计算机视觉流水线提取了数百万个单独的车辆轨迹。根据这些轨迹计算的指标表明,自动驾驶汽车周围的燃料消耗有所降低,这与仿真结果和先前的较小规模验证部署的预期一致。例如,我们可以观察到,人们离我们的自动驾驶汽车开得越近,他们平均消耗的燃料似乎就越少(这是使用校准的能量模型计算的):

在实验期间的某一天,作为距离最近的参与 RL 控制的自动驾驶汽车的距离函数,下游交通中的平均燃料消耗。随着人类驾驶员离自动驾驶汽车越来越远,他们的平均燃料消耗就会增加。

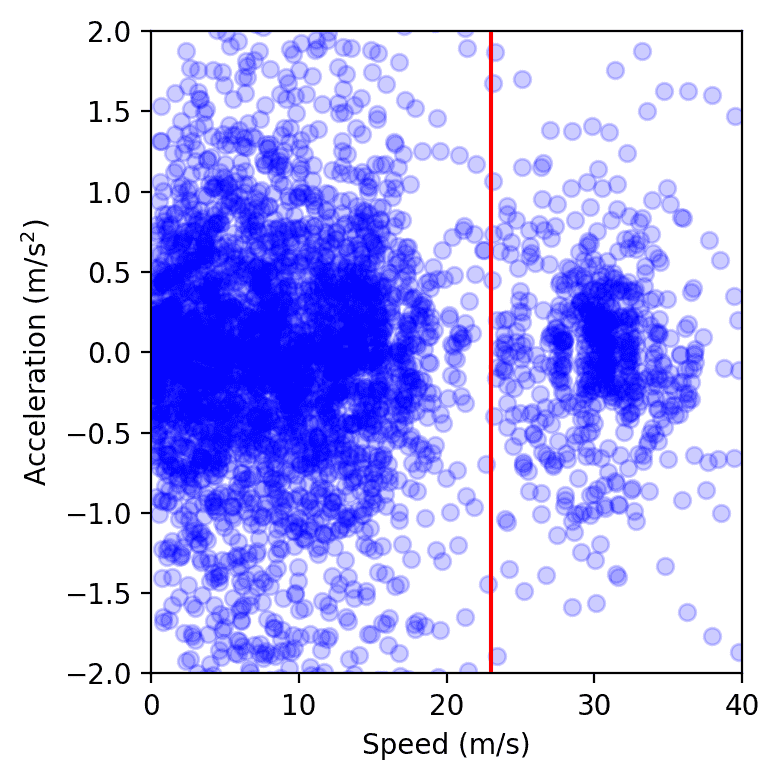

衡量影响的另一种方法是衡量速度和加速度的方差:方差越低,波幅应该越小,这与我们在现场测试数据中观察到的情况一致。总的来说,尽管从大量的摄像头视频数据中获取精确的测量结果很复杂,但我们观察到在我们的控制汽车周围有 15% 到 20% 的节能趋势。

实验某一天高速公路上所有车辆在速度-加速度空间中的数据点。红色线左侧的簇代表拥堵,右侧的簇代表自由流。我们观察到,存在自动驾驶汽车时,拥堵簇的面积更小,通过计算软凸包的面积或拟合高斯核来衡量。

最后的思考

这次 100 辆车的现场操作测试是去中心化的,自动驾驶汽车之间没有明确的合作或通信,这反映了当前的自动驾驶部署现状,使我们向更平顺、更节能的高速公路又迈进了一步。然而,仍有巨大的改进潜力。使仿真更快、更准确,并结合更好的人类驾驶模型,对于弥合仿真与现实之间的差距至关重要。为自动驾驶汽车配备额外的交通数据,无论是通过先进的传感器还是集中规划,都可以进一步提高控制器的性能。例如,虽然多智能体强化学习在改善协同控制策略方面很有前景,但启用自动驾驶汽车之间通过 5G 网络进行显式通信如何进一步提高稳定性和减轻“走走停停”波浪,仍然是一个悬而未决的问题。至关重要的是,我们的控制器与现有的自适应巡航控制(ACC)系统无缝集成,使大规模现场部署成为可能。配备智能交通平顺控制的车辆越多,我们道路上的波浪就越少,这意味着为每个人减少污染和节省燃料!

许多贡献者参与了 MegaVanderTest 的实现!完整的名单可以在CIRCLES 项目页面上找到,以及更多关于该项目的细节。

阅读更多:[论文]

🚀 想要体验更好更全面的AI调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,小白也可以简单操作。

青云聚合API官网https://api.qingyuntop.top

支持全球最新300+模型:https://api.qingyuntop.top/pricing

详细的调用教程及文档:https://api.qingyuntop.top/about

评论区