📢 转载信息

原文链接:https://www.kdnuggets.com/powerful-local-ai-automations-with-n8n-mcp-and-ollama

原文作者:Nahla Davies

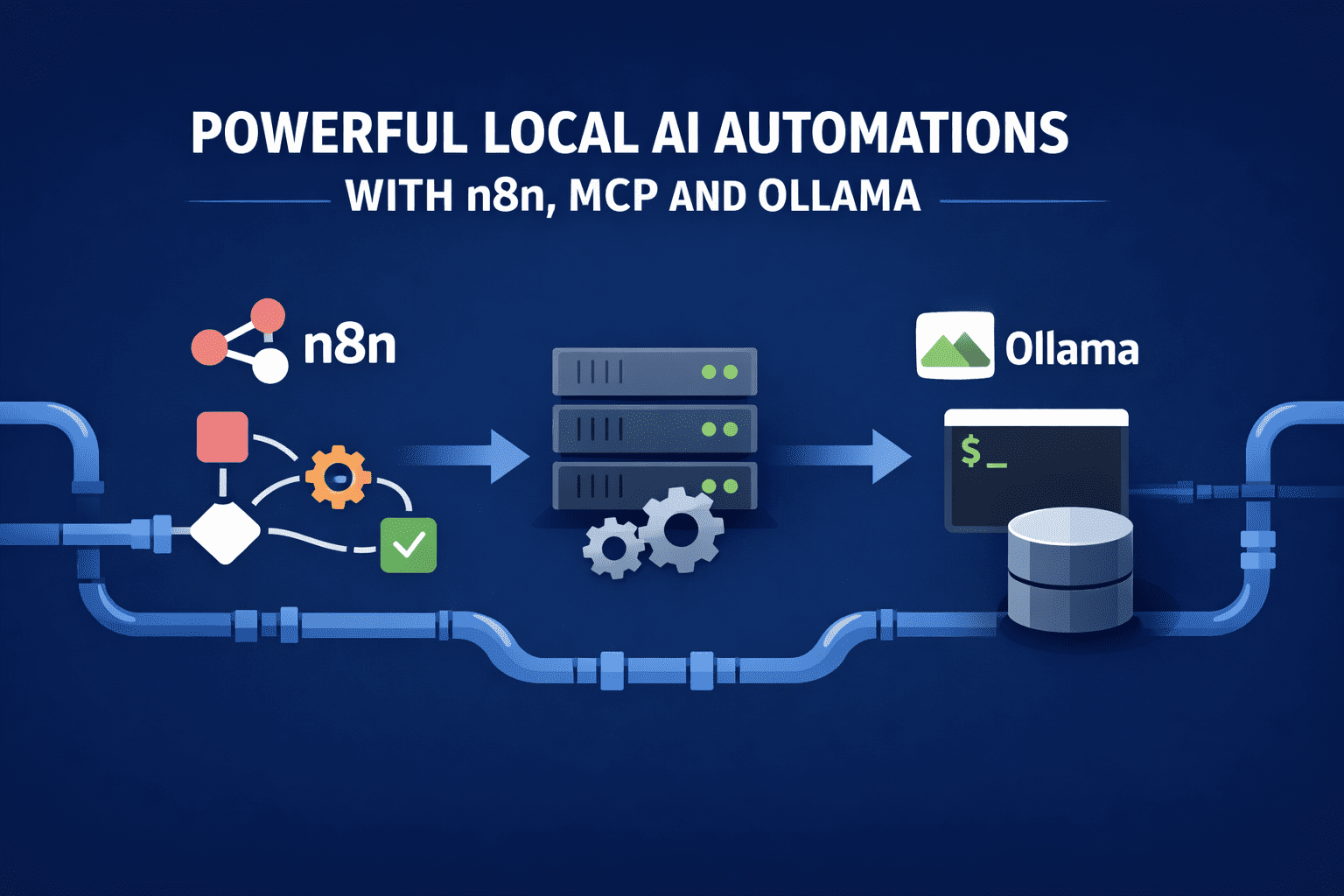

Image by Editor

运行本地大型语言模型的真正价值

运行大型语言模型(LLM)的真正价值在于它们是否能执行实际工作。n8n、模型上下文协议(MCP)和 Ollama 的价值不在于架构上的优雅,而在于它们能够自动化那些原本需要工程师介入的任务。

这个技术栈之所以有效,是因为每个组件都有明确的职责:n8n 负责编排,MCP 负责限制工具的使用,而 Ollama 则根据本地数据进行推理。

最终目标是在单个工作站或小型服务器上运行这些自动化流程,以取代脆弱的脚本和昂贵的基于 API 的系统。

自动化的日志分类与根因假设生成

这种自动化流程始于 n8n 每五分钟从本地目录或 Kafka 消费者中摄取应用程序日志。n8n 执行确定性的预处理:按服务分组、对重复的堆栈跟踪进行去重,并提取时间戳和错误代码。只有经过精简的日志包才会被传递给 Ollama。

本地模型接收到一个范围明确的提示,要求它对故障进行聚类,识别第一个因果事件,并生成两到三个合理的根因假设。MCP 暴露了一个单一工具:query_recent_deployments。当模型请求该工具时,n8n 会针对部署数据库执行查询并返回结果。然后模型会更新其假设并输出结构化的 JSON。

n8n 存储输出,将摘要发布到内部 Slack 频道,并且仅当置信度超过预设阈值时才会打开一个工单。整个过程中不涉及任何云端 LLM,并且模型在经过预处理之前绝不会看到原始日志。

分析管道的持续数据质量监控

n8n 会监控本地数据仓库中传入的批处理表,并对传入数据与历史基线进行模式差异比对。检测到漂移时,工作流会将变化的紧凑描述发送给 Ollama,而不是发送完整数据集。

模型被指示判断这种漂移是良性的、可疑的还是破坏性的。MCP 暴露了两个工具:sample_rows 和 compute_column_stats。模型会选择性地请求这些工具,检查返回的值,并生成一个分类结果以及一段易于人类理解的解释。

如果漂移被分类为破坏性的,n8n 会自动暂停下游管道,并用模型的推理解释来注释该事件。随着时间的推移,团队会积累一个可搜索的历史模式更改和决策的档案,所有这些都由本地生成。

机器学习管道的自主数据集标注与验证循环

此自动化专为处理持续流入数据而训练模型的团队设计,在这些团队中,手动标注成为瓶颈。n8n 监控本地数据投放位置或数据库表,并在固定时间间隔内对新的、未标记的记录进行批处理。

每个批次在推理发生之前,都会经过确定性的预处理,以去除重复项、规范化字段并附加最小元数据。

Ollama 只接收清理后的批次,并被指示生成带置信度分数的标签,而不是自由文本。MCP 暴露了一个受限的工具集,以便模型可以在任何内容被接受之前,根据历史分布和采样检查来验证其输出。然后,n8n 决定标签是自动批准、部分批准还是路由给人工审核。

循环的关键组成部分包括:

- 初始标签生成: 本地模型根据提供的模式和示例严格分配标签和置信度值,生成 n8n 可以在无需解释的情况下验证的结构化 JSON。

- 统计漂移验证: 通过 MCP 工具,模型可以从先前批次请求标签分布统计数据,并标记表明概念漂移或错误分类的偏差。

- 低置信度升级: n8n 会自动将置信度低于阈值的样本路由给人工审阅者,同时接受其余的样本,从而在不牺牲准确性的情况下保持高吞吐量。

- 反馈再注入: 人工更正作为新的参考示例被反馈回系统,模型可以在未来的运行中通过 MCP 检索它们。

这创建了一个本地可扩展、随时间推移而改进的闭环标注系统,并将人类从关键路径中移除,除非他们确实有必要参与。

来自内部和外部来源的自更新研究简报

此自动化在夜间运行。n8n 会从选定的存储库、最新的内部文档和精选的已保存文章中拉取新的提交。每项内容都会被分块并在本地嵌入。

Ollama,无论是通过终端还是 GUI 运行,都被提示更新现有的研究简报而不是创建新的。MCP 暴露的检索工具允许模型查询先前的摘要和嵌入。模型识别出哪些内容已更改,仅重写受影响的部分,并标记矛盾或过时的声明。

n8n 将更新后的简报提交回存储库并记录差异。结果是一个无需手动重写的、不断演进的活文档,完全由本地推理驱动。

带有证据链接的自动化事件事后复盘

当一个事件被关闭时,n8n 会从警报、日志和部署事件中组装时间线。工作流不会盲目地要求模型撰写叙述,而是按严格的时间顺序分块地输入时间线。

模型被指示生成一份带有明确引用时间线事件的事后复盘报告。MCP 暴露了一个fetch_event_details 工具,模型可以在缺少上下文时调用它。最终报告中的每个段落都引用了具体的证据 ID。

n8n 会拒绝任何缺少引用的输出,并重新提示模型。最终文档是一致的、可审核的,并且在不向外部暴露操作数据的情况下生成。

本地合同和政策审查自动化

法务和合规团队在内部机器上运行此自动化。n8n 摄入新的合同草稿和政策更新,去除格式,并分段处理条款。

Ollama 被要求将每个条款与批准的基线进行比较并标记偏差。MCP 暴露了一个 retrieve_standard_clause 工具,允许模型提取规范语言。输出包括确切的条款引用、风险级别和建议的修订。

n8n 将高风险发现路由给人工审阅者,并自动批准未更改的部分。敏感文件永远不会离开本地环境。

内部存储库的工具驱动代码审查

此工作流在拉取请求上触发。n8n 提取差异和测试结果,然后将其发送给 Ollama,指示它只关注逻辑更改和潜在的失败模式。

通过 MCP,模型可以调用 run_static_analysis 和 query_test_failures。它利用这些结果来支持其审查评论。只有当模型识别出具体、可重现的问题时,n8n 才会发布行内评论。

结果是一个不会产生风格看法的代码审查器,并且只在有证据支持其声明时才发表评论。

总结

每个示例都限制了模型的范围,只暴露必要的工具,并依赖 n8n 进行执行。本地推理使得这些工作流足够快,可以连续运行,并且成本足够低,可以始终保持开启状态。更重要的是,它使推理过程贴近数据,并将执行置于严格的控制之下——这是它应有的位置。

在此基础上,n8n、MCP 和 Ollama 不再是基础设施实验,而是开始作为一个实用的自动化技术栈发挥作用。

Nahla Davies 是一位软件开发人员和技术作家。在全职从事技术写作之前,她曾管理过一家 Inc. 5,000 体验式品牌组织的首席程序员,该组织的服务客户包括三星、时代华纳、网飞和索尼等。

🚀 想要体验更好更全面的AI调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,文档丰富,小白也可以简单操作。

评论区