📢 转载信息

原文链接:https://www.qbitai.com/2025/10/339267.html

原文作者:Jay (来自 量子位)

双SOTA突破!华中科技大学白翔团队推出LIRA框架,精准解决多模态分割与理解难题

多模态大模型(MLLM)的应用场景正从最初的文生图,扩展到像素级任务,如图像分割。然而,现有模型如OMG-LLaVA和LISA(CVPR 2024)在实现高精度分割和避免理解幻觉方面仍面临挑战,主要归因于对物体属性理解的不足和细粒度感知能力的局限。

为解决这些痛点,华中科技大学团队与金山办公团队联合提出了创新的多模态大模型LIRA。

LIRA引入了两个核心模块:

- 语义增强特征提取器(SEFE):融合语义特征与像素级特征,增强模型对物体属性的推理能力,从而获得更精确的分割结果。

- 交错局部视觉耦合(ILVC):基于分割掩码自回归生成局部描述,为模型提供细粒度监督,有效减少理解幻觉。

通过这两个模块的协同作用,LIRA在分割和理解两项任务上均达到了新的SOTA(State-of-the-Art)水平。该项目已被ICCV 2025录用。

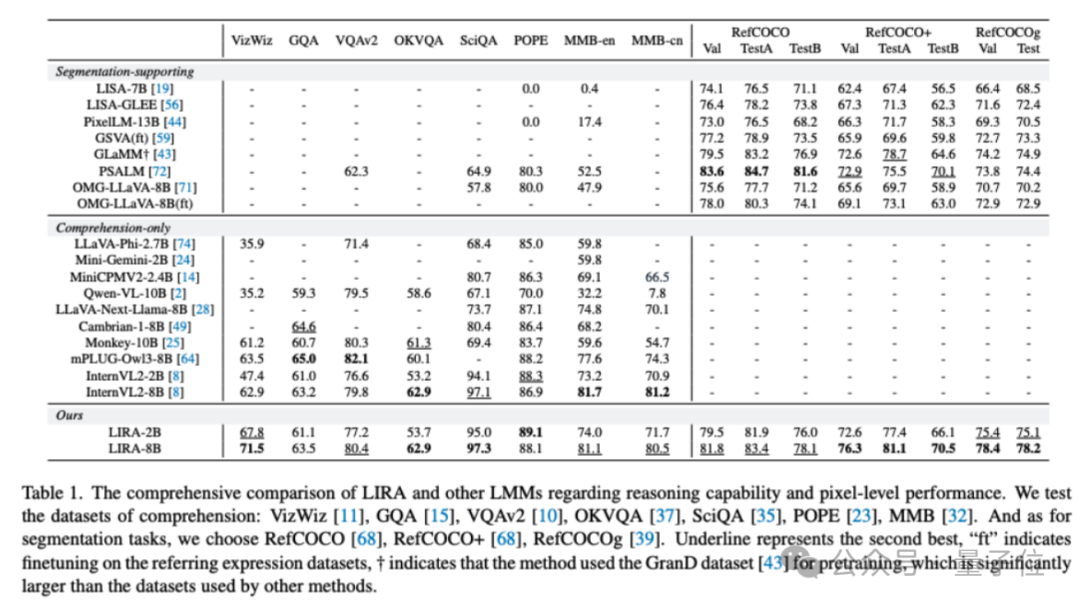

与InternVL2相比,LIRA在保持理解性能的同时,新增了图像分割能力;与OMG-LLaVA相比,LIRA在图像分割任务上平均提升了8.5%,在MMBench基准测试中提升了33.2%。

现有方法的局限:分割不准与理解幻觉

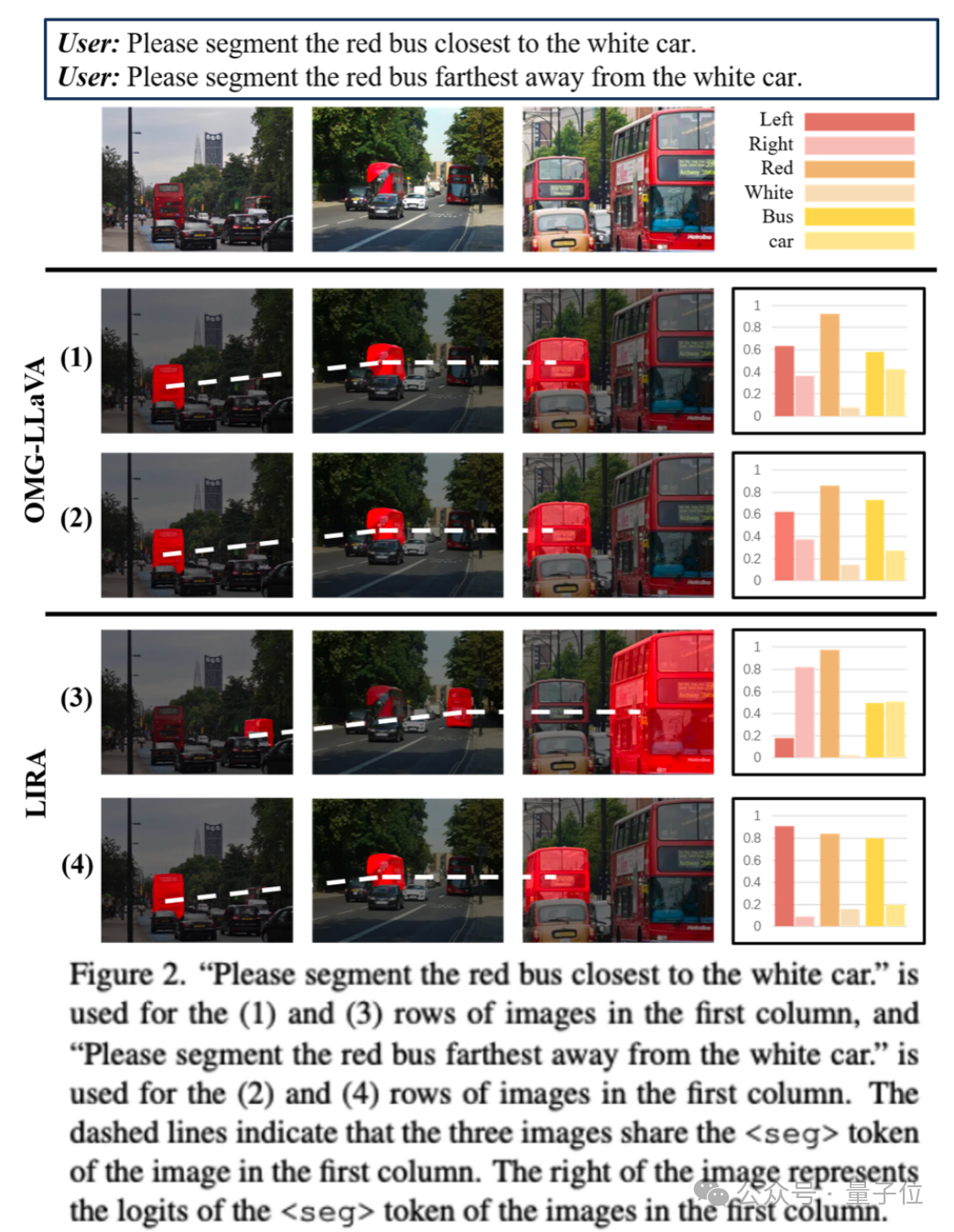

虽然多模态大模型已开始涉足像素级分割,但复杂场景下的目标分割仍然困难重重。例如,在某些情况下,OMG-LLaVA可能无法准确分割出“最靠近白色汽车的红色公交车”。

研究发现,模型生成的Token Embedding可能包含了与原始图像无关的语义信息(例如,与“left”相关的logits过高),导致分割错误。此外,现有方法依赖位置查询,但局部描述与对应图像区域特征之间的联系不明确,容易产生“幻觉”。

研究团队提出疑问:是否应该让模型直接基于局部图像特征来生成描述,从而建立更清晰的视觉特征与语义映射?

LIRA模型架构:两大核心模块助推性能飞跃

1. 语义增强特征提取器(SEFE)

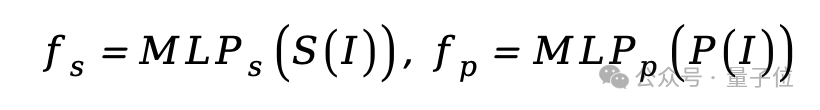

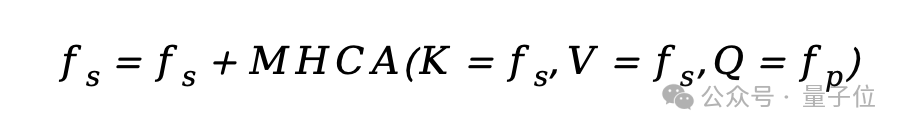

SEFE模块旨在提升模型对物体属性的理解,从而提高分割精度。它巧妙地融合了来自预训练多模态大模型的语义编码器和分割模型的像素编码器的特征。

首先,语义和像素特征经过多层感知机(MLP)转换到相同维度,然后通过多头交叉注意力机制进行融合,最终形成全局特征输入到LLM中。

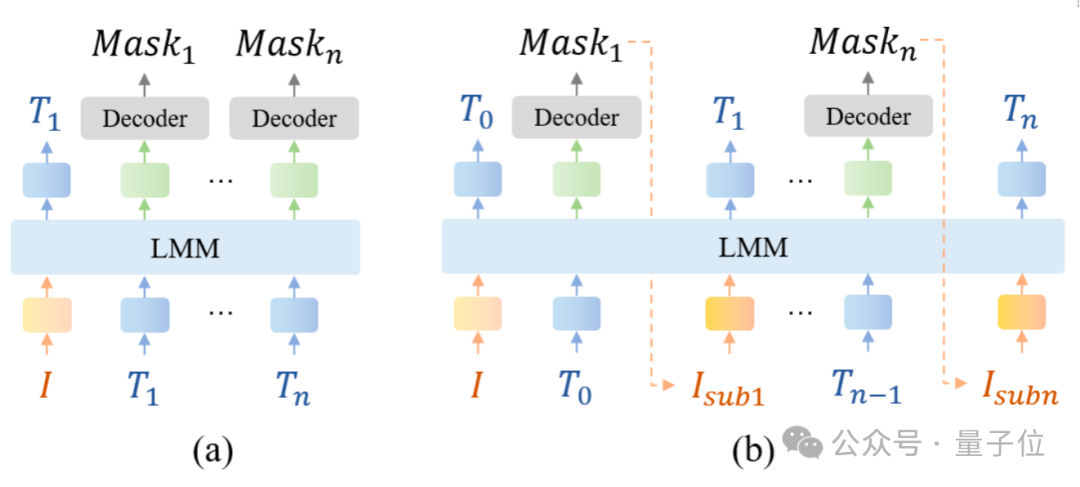

2. 交错局部视觉耦合模块(ILVC)

为了精确对齐局部特征和对应的文本描述,ILVC模块受到人类认知的启发:先关注区域,再进行描述。它解决了现有方法仅依赖Token Embedding而缺乏明确局部关联的问题。

具体流程是:模型先生成分割掩码,基于掩码裁剪出对应区域,然后通过SEFE提取该区域的局部特征。这些特征随后被送回文本大模型以生成描述并预测后续内容。这种交错的训练范式,成功地为局部图像区域引入了细粒度监督,显著缓解了理解幻觉。

实验验证:性能全面超越现有最佳方法

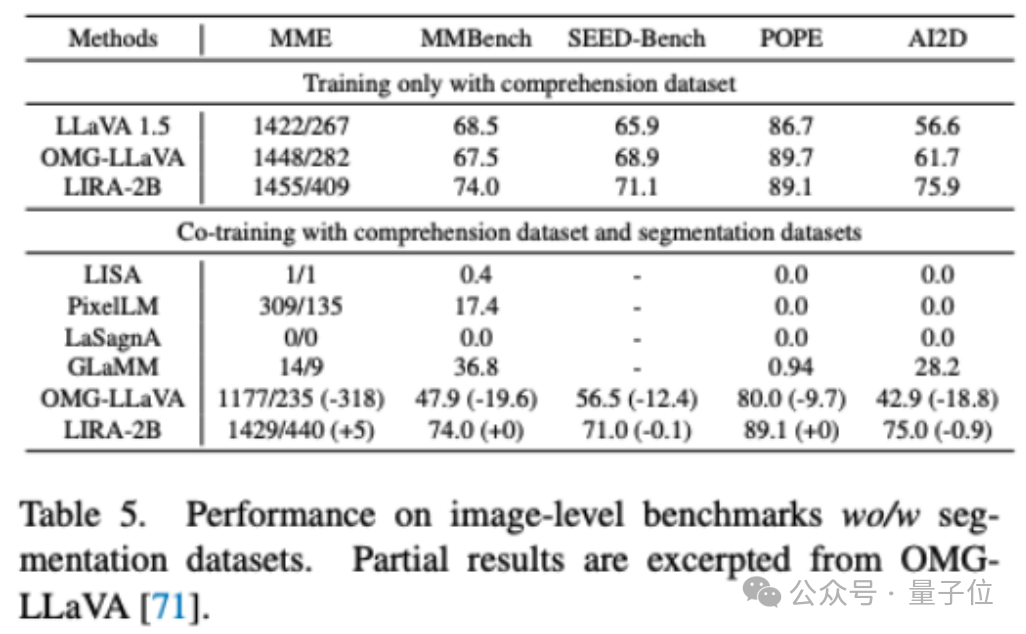

实验结果证明,LIRA能够有效集成理解和分割任务,并在多个基准测试中表现出色。

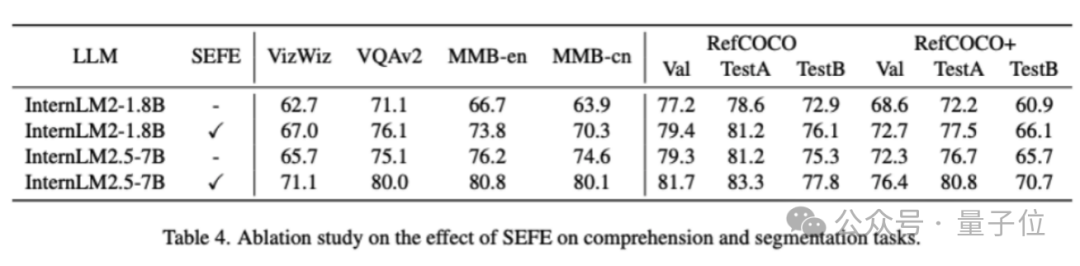

SEFE模块贡献

消融实验显示,整合SEFE后,基于InternLM2-1.8B骨干网络,理解任务平均提升5.7%,分割任务提升3.8%;基于InternLM2.5-7B,提升分别为5.1%和3.4%。

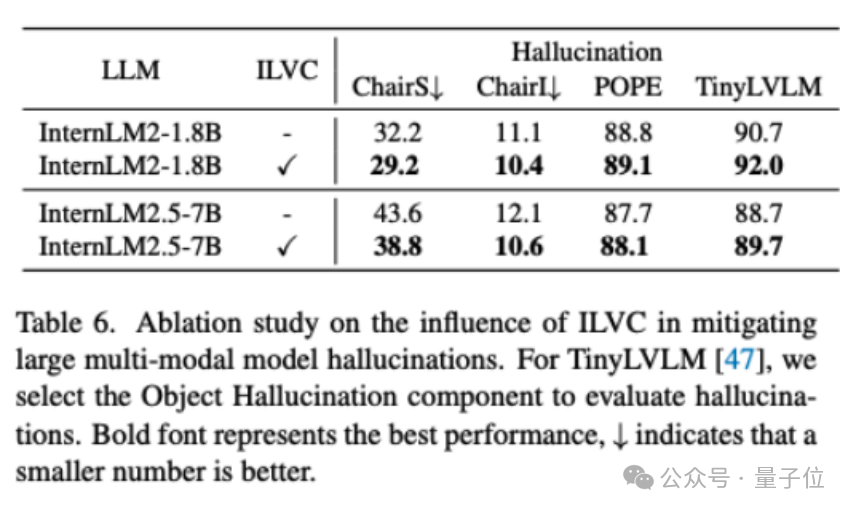

ILVC模块缓解幻觉

在SEFE基础上引入ILVC后,在ChairS数据集上,1.8B和7B模型的幻觉率分别降低了3.0%和4.8%。

联合训练效果

当LIRA使用理解数据和分割数据联合训练时,性能仅比单独使用理解数据训练略微下降0.2%,远优于OMG-LLaVA在五个理解数据集上近15%的性能下降。

综上所述,LIRA通过SEFE和ILVC两个创新模块,实现了多模态大模型在细粒度分割任务上的性能协同提升,并为缓解理解幻觉提供了新视角,为未来研究开辟了新的方向。

了解更多:

- arXiv: https://arxiv.org/abs/2507.06272

- GitHub: https://github.com/echo840/LIRA

🚀 想要体验更好更全面的AI调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,小白也可以简单操作。

评论区