📢 转载信息

原文链接:http://bair.berkeley.edu/blog/2024/03/21/xt/

原文作者:Berkeley AI Research (BAIR)

计算机视觉的瓶颈:如何处理“大”图像?

作为计算机视觉研究人员,我们坚信每一像素都蕴含着故事。然而,在处理大型图像时,我们领域似乎遇到了“写作障碍”。如今,大尺寸图像已不再罕见——我们口袋里的相机,以及环绕地球的卫星拍摄的照片,其巨大和精细程度,已将我们现有的最佳模型和硬件推向极限。通常情况下,内存使用量会随着图像尺寸的增加而呈平方级增长。

目前,处理大图像时我们通常只能选择两种次优方案:降采样(Down-sampling)或裁剪(Cropping)。这两种方法都会导致图像中信息和上下文的大量丢失。我们重新审视了这些方法,并推出了 $x$T 框架,这是一个能够在当代 GPU 上端到端建模大图像的新框架,可以有效地整合全局上下文与局部细节。

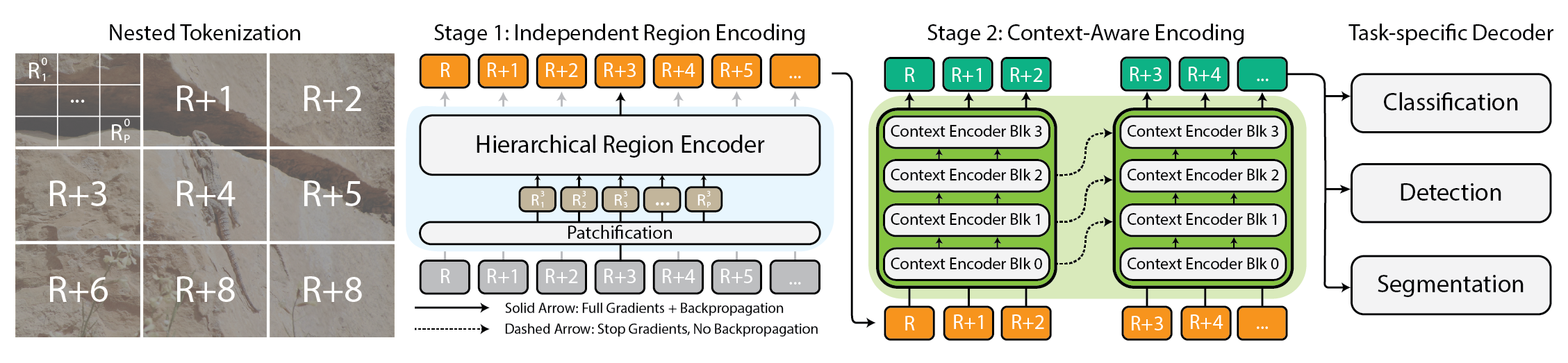

$x$T 框架的架构图。

为何必须关注大图像?

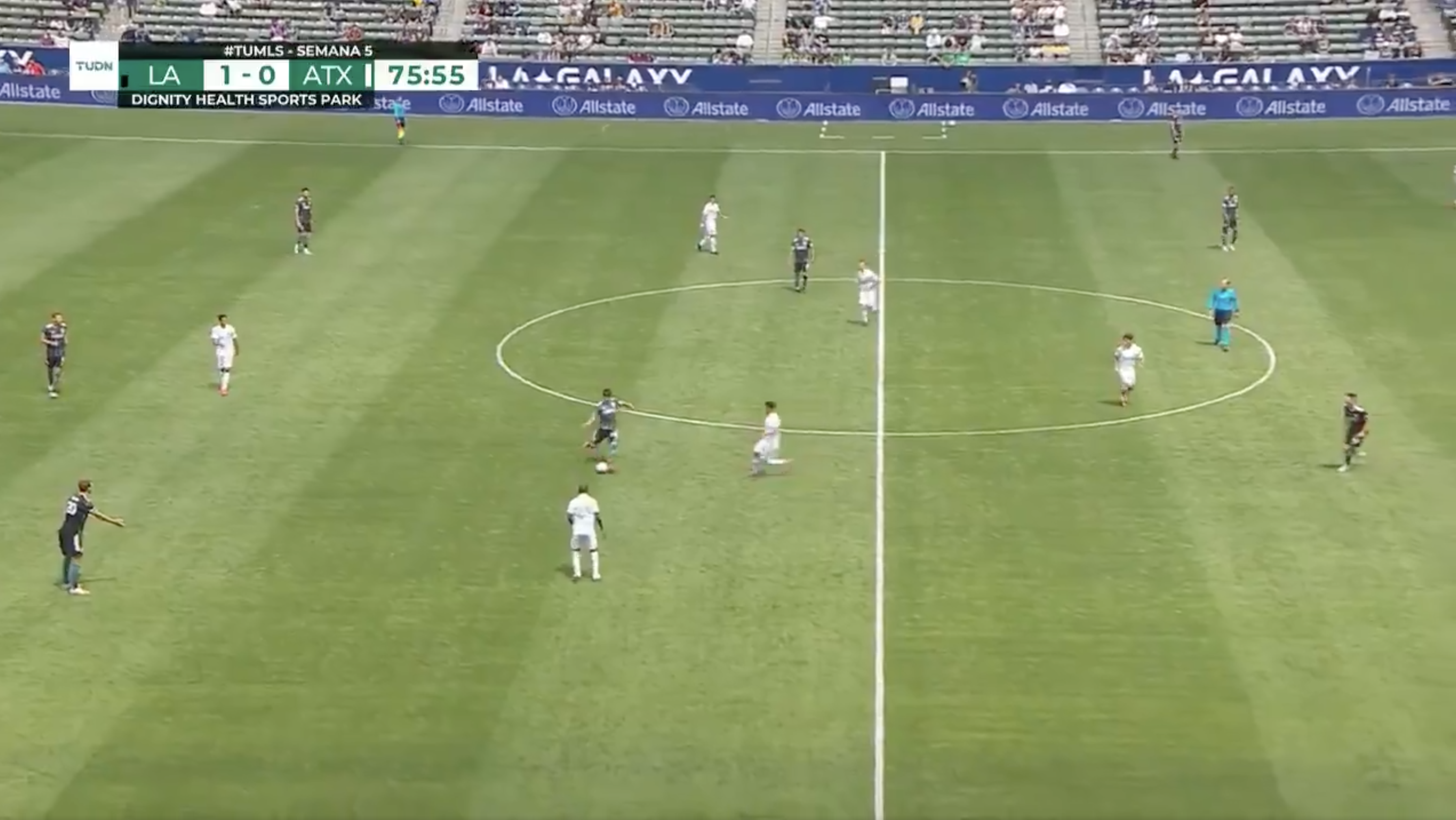

为什么要费力处理大图像呢?想象一下,您正坐在电视机前观看最喜欢的足球赛。整个球场上布满了球员,但同一时刻发生的动作可能只集中在屏幕的一小部分。如果您只能看到球当前位置周围的一小块区域,您会满意吗?或者,如果以低分辨率观看比赛,您会满意吗?无论相隔多远,每一个像素都在讲述一个故事。这在所有领域都是如此,从您的电视屏幕到病理学家查看用于诊断微小癌变区域的千兆像素玻片。这些图像是信息的宝库。如果我们的工具无法完全驾驭地图,那么探索这些财富又有什么意义呢?

了解全局动态的体育比赛才有趣。

这正是目前的痛点所在。图像越大,我们就越需要在保持全局视野(看森林)和关注局部细节(看树木)之间取得平衡,这使得同时掌握两者变得极具挑战性。目前大多数方法迫使我们在牺牲全局视野或忽略细节之间做出选择,而这两个选项都不理想。

$x$T 如何尝试解决这一问题?

想象一下要拼一个巨大的拼图。如果您试图一次性解决整个拼图,那将是压倒性的。更好的方法是先从较小的部分入手,仔细查看每一块,然后再弄清楚它们如何组合成更大的画面。这基本上就是我们使用 $x$T 处理大图像的方式。

$x$T 将这些巨大的图像分层切割成更小、更易于处理的片段。但这不仅仅是变小的问题。关键在于理解每个片段本身的含义,然后利用一些巧妙的技术,弄清楚这些片段如何在更大的尺度上相互连接。这就像与图像的每个部分进行“对话”,了解它的故事,然后与其他部分分享这些故事,以获得完整的叙事。

嵌套分词(Nested Tokenization)

$x$T 的核心在于嵌套分词的概念。简单来说,在计算机视觉领域,分词就像将图像切分成模型可以消化和分析的片段(Token)。然而,$x$T 更进一步,在该过程中引入了层次结构——因此称为“嵌套”。

想象一下,您需要分析一张详细的城市地图。您不会试图一次性查看整个地图,而是将其分解为各个区域,然后在这些区域内再细分为邻里,最后再细分到街道。这种分层分解使得管理和理解地图的细节变得更加容易,同时还能追踪所有内容在更大图景中的位置。这就是嵌套分词的精髓:我们将图像分割成区域,这些区域可以根据视觉骨干网络(我们称之为区域编码器)期望的输入大小,进一步细分为子区域,然后再进行补丁化处理(patchified)以供区域编码器处理。这种嵌套方法使我们能够在局部层面提取不同尺度的特征。

协调区域编码器与上下文编码器

一旦图像被整齐地划分为 Token,$x$T 就会采用两种类型的编码器来理解这些片段:区域编码器(Region Encoder)和上下文编码器(Context Encoder)。每个都在拼凑图像的完整故事中扮演着独特的角色。

区域编码器是一个独立的“局部专家”,它将各个独立的区域转换为详细的表示。然而,由于每个区域是隔离处理的,图像之间不会共享任何信息。区域编码器可以是任何最先进的视觉骨干网络。在我们的实验中,我们使用了像 Swin 和 Hiera 这样的分层视觉 Transformer,以及 ConvNeXt 这样的 CNN!

接下来是上下文编码器,这位“全局大师”。它的工作是将来自区域编码器的详细表示缝合在一起,确保一个 Token 的洞察能被考虑到其他 Token 的上下文中。上下文编码器通常是一个长序列模型。我们实验了 Transformer-XL(以及我们称之为 Hyper 的变体)和 Mamba,但您也可以使用 Longformer 和该领域其他最新进展。尽管这些长序列模型通常是为语言设计的,但我们证明了可以将它们有效地用于视觉任务。

$x$T 的魔力在于这些组件——嵌套分词、区域编码器和上下文编码器——如何协同工作。通过首先将图像分解成可管理的片段,然后系统地分析这些片段的独立性及相互关联性,$x$T 成功地在保持原始图像细节保真度的同时,整合了长距离上下文,并能够在当代 GPU 上端到端处理巨型图像。

实验结果

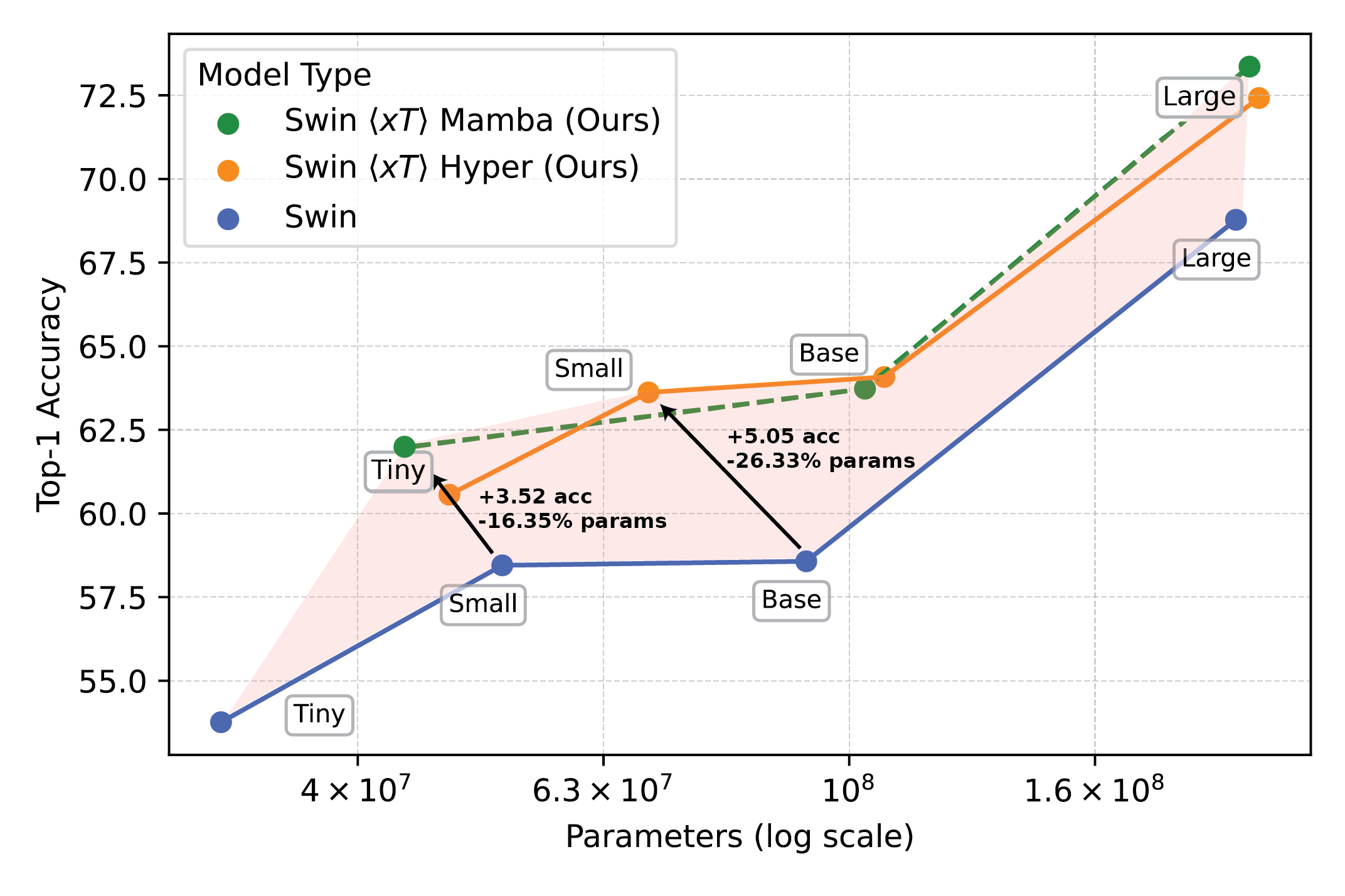

我们在具有挑战性的基准任务上评估了 $x$T,这些任务涵盖了成熟的计算机视觉基线和严格的大图像任务。特别是,我们使用了 iNaturalist 2018 进行细粒度物种分类,xView3-SAR 进行上下文依赖的分割,以及 MS-COCO 进行目标检测。

使用 $x$T 增强的强大视觉模型在细粒度物种分类等下游任务上开辟了新前沿。

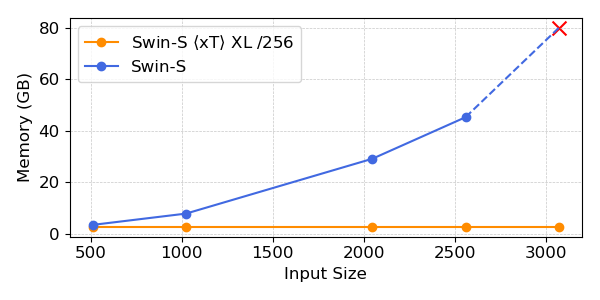

我们的实验表明,$x$T 能够在所有下游任务上实现更高的准确率,同时使用的参数更少,且每个区域的内存消耗远低于最先进的基线 *。我们能够在 40GB 的 A100 上处理大到 29,000 x 25,000 像素的图像,而可比较的基线在 2,800 x 2,800 像素时就会内存溢出。

使用 $x$T 增强的强大视觉模型在细粒度物种分类等下游任务上开辟了新前沿。

*这取决于您选择的上下文模型,例如 Transformer-XL。

为什么这比您想象的更重要?

这种方法不仅仅是酷炫,更是必需的。对于追踪气候变化或诊断疾病的科学家来说,它是一个游戏规则的改变者。这意味着可以创建出理解完整故事而非仅仅部分片段的模型。例如,在环境监测中,能够同时看到广阔地貌的整体变化和特定区域的细节,有助于理解气候影响的全貌。在医疗保健领域,这可能意味着早期发现疾病与否的差别。

我们并非声称一举解决了世界上所有问题。我们希望通过 $x$T 开启了新的可能性。我们正在迈入一个新时代,不再需要在清晰度和广度之间做出妥协。 $x$T 是我们向着能够轻松驾驭大尺度图像复杂性的模型迈出的重要一步。

仍有许多工作要做。研究将会发展,我们处理更大、更复杂图像的能力也希望能随之发展。事实上,我们正在进行 $x$T 的后续研究,以进一步拓展这一前沿。

总结

有关此工作的完整介绍,请参阅 arXiv 上的论文。项目页面 http://ai-climate.berkeley.edu/xt-website/ 包含我们已发布代码和权重的链接。如果您觉得这项工作有帮助,请按如下方式引用:

@article{xTLargeImageModeling, title={xT: Nested Tokenization for Larger Context in Large Images}, author={Gupta, Ritwik and Li, Shufan and Zhu, Tyler and Malik, Jitendra and Darrell, Trevor and Mangalam, Karttikeya}, journal={arXiv preprint arXiv:2403.01915}, year={2024}

}🚀 想要体验更好更全面的AI调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,小白也可以简单操作。

青云聚合API官网https://api.qingyuntop.top

支持全球最新300+模型:https://api.qingyuntop.top/pricing

详细的调用教程及文档:https://api.qingyuntop.top/about

评论区