📢 转载信息

原文链接:https://www.ithome.com/0/889/326.htm

原文作者:故渊(IT之家)

一、划时代突破:长文生成提速 128 倍

苹果公司与俄亥俄州立大学的研究团队近期联合发表论文,提出一种名为“少步离散流匹配”(Few-Step Discrete Flow-Matching,简称 FS-DFM)的新型语言模型。

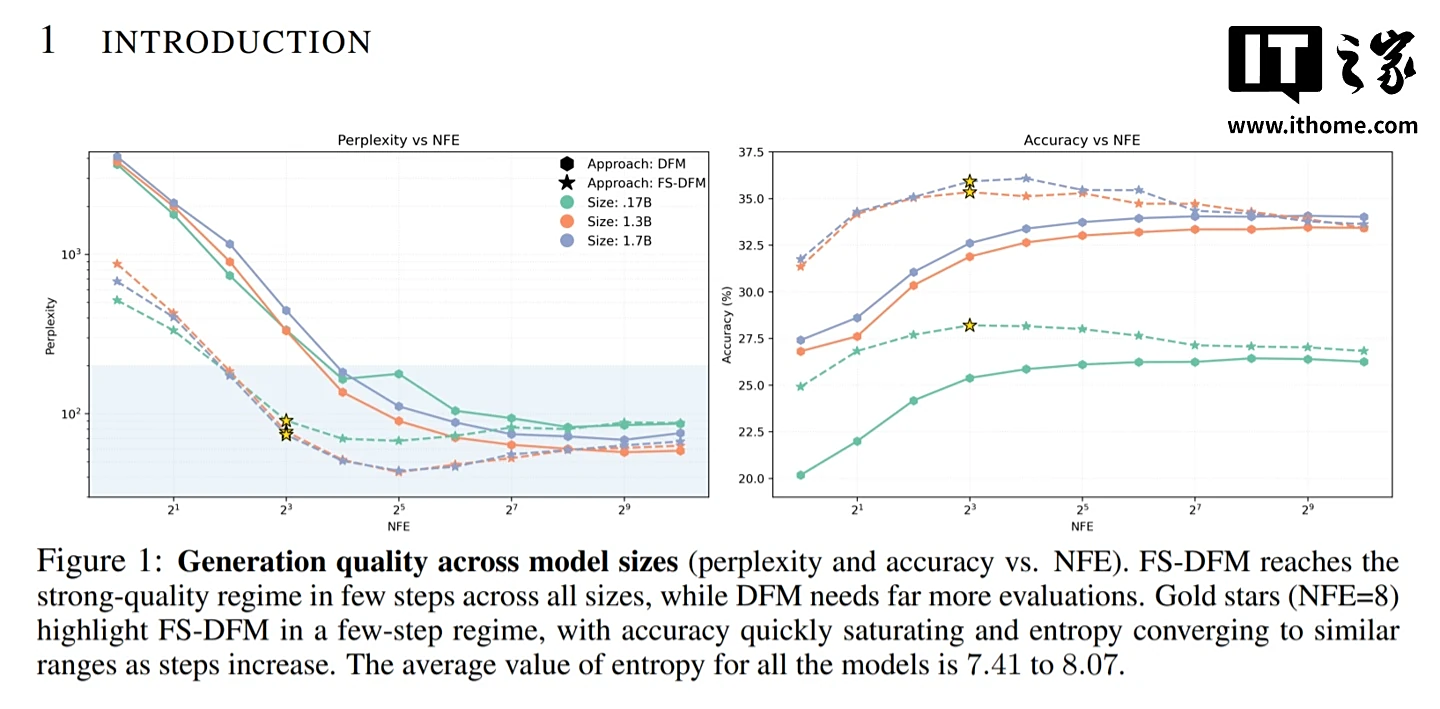

根据科技媒体 9to5Mac 的报道,苹果推出的 FS-DFM 扩散模型,成功解决了长文本生成领域的效率瓶颈。该模型仅需 8 轮快速精练迭代,就能生成高质量的长篇文本,其效果足以媲美传统扩散模型执行上千步迭代所实现的效果。这意味着 FS-DFM 的写入速度比同类模型最多可提高 128 倍。

二、FS-DFM:扩散模型的新范式

在深入了解 FS-DFM 的高效机制之前,我们需要回顾两种主流的语言模型范式:

-

自回归模型: 以 ChatGPT 为代表,其工作方式是逐字(Token)串行生成文本,后一个字的生成严格依赖于前面所有内容。

-

扩散模型: 采用并行策略,一次性生成多个字,再通过多轮迭代逐步优化,直至形成完整的回应。

FS-DFM 作为扩散模型的一个变体,进一步简化了迭代过程,旨在用最少的步骤直接生成最终结果。

三、实现高效能的“三步法”

苹果研究人员为实现这一突破性加速,设计了一套精妙的“三步法”训练机制:

-

适应性训练: 模型经过专门训练,能够灵活适应不同的精炼迭代次数,不再受限于固定的迭代步骤。

-

引入“教师”模型: 团队引入一个“教师”模型进行引导,确保模型在每轮迭代中都能进行大幅且精准的更新,同时避免出现“矫枉过正”(过度修正导致失真)的问题。

-

优化迭代机制: 优化迭代机制本身,让模型能以更少、更稳健的步骤生成最终文本。

四、性能对比:小参数量带来大优势

在性能评估中,FS-DFM 与拥有 70 亿参数的 Dream 模型和 80 亿参数的 LLaDA 模型进行了对比。

测试结果令人振奋:即使是参数量仅为 1.7 亿至 17 亿的 FS-DFM 变体,在关键指标上仍表现出色:

- 困惑度(Perplexity): 衡量文本准确与流畅性的指标,越低越好。FS-DFM 表现出更低的困惑度。

- 熵(Entropy): 衡量模型选词置信度。FS-DFM 展现出更稳定的熵,避免了生成文本过于单调重复或出现胡言乱语的情况。

这表明 FS-DFM 在保持极高效率的同时,仍然能保证文本的质量和稳定性。

🚀 想要体验更好更全面的AI调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,小白也可以简单操作。

青云聚合API官网https://api.qingyuntop.top

支持全球最新300+模型:https://api.qingyuntop.top/pricing

详细的调用教程及文档:https://api.qingyuntop.top/about

评论区