📢 转载信息

原文作者:Dan Ferguson, Deepti Ragha, Dmitry Soldatkin, Lokeshwaran Ravi, Ram Vegiraju, and Sadaf Fardeen

在2025年,Amazon SageMaker AI 进行了多项改进,旨在帮助您训练、调优和托管生成式AI工作负载。在本文系列的第1部分中,我们讨论了灵活训练计划和推理工作负载价格性能的改进。

在本文中,我们将讨论在可观测性、模型定制和模型托管方面所做的增强。这些改进为托管在SageMaker AI上的客户用例开辟了全新的类别。

可观测性

2025年SageMaker AI的可观测性增强功能有助于提供对模型性能和基础设施健康状况的深度洞察。增强的指标提供了细粒度的、实例级别和容器级别的CPU、内存、GPU利用率以及调用性能跟踪,并具有可配置的发布频率,以便团队可以诊断以前被端点级别聚合所隐藏的延迟问题和资源效率低下情况。推理组件的滚动更新通过减轻重复配置基础设施的需求来提高部署安全性——更新以可配置的批次部署,并集成Amazon CloudWatch警报监控,如果在检测到问题时触发自动回滚,从而实现零停机部署,同时通过渐进式验证最小化风险。

增强指标

SageMaker AI今年推出了增强指标,有助于在实例和容器级别提供对端点性能和资源利用率的细粒度可见性。此功能解决了可观测性中的一个关键差距,有助于客户诊断以前被端点级别聚合所掩盖的延迟问题、调用失败和资源效率低下。增强指标提供了CPU、内存和GPU利用率的实例级别跟踪,以及调用性能指标(延迟、错误、吞吐量),并为SageMaker端点提供了InstanceId维度。对于推理组件,容器级别指标提供了对单个模型副本资源消耗的可见性,同时具有ContainerId和InstanceId维度。

您可以配置指标发布频率,为需要快速响应的关键应用程序提供近乎实时的监控。通过在CreateEndpointConfig API中设置一个简单的MetricsConfig参数来实现自助启用,有助于减少洞察时间,帮助您自行诊断性能问题。增强指标可以帮助您确定哪个特定的实例或容器需要关注,诊断主机之间的流量分布不均,优化资源分配,并将性能问题与特定的基础设施资源相关联。该功能与CloudWatch警报和自动扩展策略无缝协作,提供主动监控和对性能异常的自动化响应。

要启用增强指标,请在创建端点配置时添加MetricsConfig参数:

response = sagemaker_client.create_endpoint_config( EndpointConfigName='my-config', ProductionVariants=[{...}], MetricsConfig={ 'EnableEnhancedMetrics': True, 'MetricPublishFrequencyInSeconds': 60 # Supported: 10, 30, 60, 120, 180, 240, 300 } )增强指标在所有AWS区域中都可用于单个模型端点和推理组件,为大规模生产AI部署提供全面的可观测性。

带滚动更新的护栏部署

SageMaker AI为推理组件引入了滚动更新,有助于以增强的安全性和效率改变您部署模型更新的方式。传统的蓝/绿部署需要配置重复的基础设施,造成资源限制——特别是对于像大型语言模型这样的GPU密集型工作负载。滚动更新以可配置的批次部署新模型版本,同时动态扩展基础设施,并集成CloudWatch警报监控指标,如果在检测到问题时触发自动回滚。这种方法有助于减轻配置重复集群的需求,减少部署开销,并通过渐进式验证实现零停机更新,从而在保持可用性的同时最小化风险。有关更多详细信息,请参阅增强Amazon SageMaker AI推理的推理组件滚动更新以提升部署护栏。

可用性

SageMaker AI的可用性改进侧重于消除复杂性并加速AI团队的价值实现时间。无服务器模型定制通过根据模型和数据大小自动配置计算资源来减少基础设施规划时间,通过基于UI和基于代码的工作流程以及集成的MLflow实验跟踪,支持可验证奖励强化学习 (RLVR) 和AI反馈强化学习 (RLAIF) 等高级技术。双向流式传输通过维护持久连接,支持实时多模态应用程序,数据可以在两个方向上同时流动——有助于将语音代理和实时转录等用例从事务性交换转变为连续对话。通过跨区域的全面AWS PrivateLink支持和IPv6兼容性增强的连接性,有助于确保企业部署能够满足严格的合规性对齐要求,同时使网络架构面向未来。

无服务器模型定制

新的SageMaker AI无服务器定制功能解决了组织面临的一个关键挑战:对AI模型进行微调的过程冗长且复杂,传统上需要数月时间和大量的计算资源管理专业知识。许多团队难以选择合适的计算资源、管理强化学习等高级微调技术的复杂性,以及驾驭从模型选择到评估再到部署的端到端工作流程。

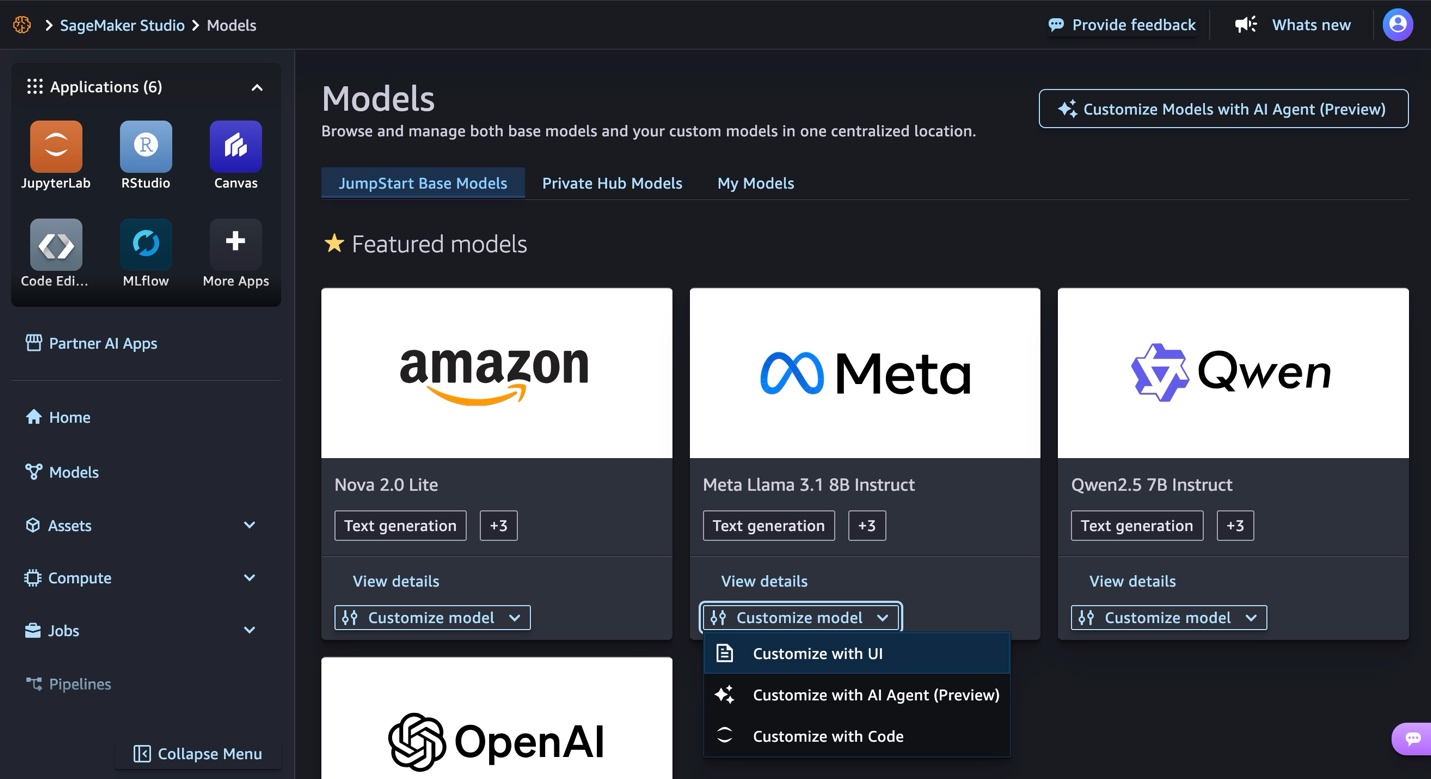

此无服务器解决方案通过根据模型和数据大小自动配置正确的计算资源来消除这些障碍,使团队能够专注于模型调优而不是基础设施管理,并有助于加速定制过程。该解决方案支持流行的模型,包括Amazon Nova、DeepSeek、GPT-OSS、Llama和Qwen,提供基于UI和基于代码的定制工作流程,使具有不同技术专长水平的团队也能使用高级技术。

该解决方案提供了多种高级定制技术,包括监督微调、直接偏好优化、RLVR和RLAIF。每种技术都有助于以不同方式优化模型,选择受数据集大小和质量、可用计算资源、任务要求、所需准确性水平和部署约束等因素影响。该解决方案通过无服务器MLflow集成了实验跟踪,可自动记录关键指标而无需代码修改,帮助团队在整个定制过程中监控和比较模型性能。

部署灵活性是一项关键功能,可以选择部署到Amazon Bedrock进行无服务器推理或部署到SageMaker AI端点进行受控资源管理。该解决方案包括内置的模型评估功能,用于将定制模型与基础模型进行比较,一个用于提示或聊天模式测试的交互式沙盒,以及与更广泛的Amazon SageMaker Studio环境的无缝集成。这个端到端的—从模型选择和定制到评估和部署—完全在一个统一的界面中处理。

该服务目前在美东(弗吉尼亚北部)、美西(俄勒冈)、亚太地区(东京)和欧洲(爱尔兰)区域可用,采用按令牌付费的模式进行训练和推理。这种定价方法有助于为不同规模的组织定制AI模型提供成本效益,而无需前期基础设施投资,并且无服务器架构有助于确保团队可以根据实际使用情况而不是预置容量来扩展其模型定制工作。有关此核心功能的更多信息,请参阅Amazon SageMaker AI中新的无服务器定制加速模型微调。

双向流式传输

SageMaker AI在2025年引入了双向流式传输功能,将推理从事务性交换转变为用户和模型之间的连续对话。此功能允许数据在单个持久连接上同时双向流动,支持实时多模态用例,范围从音频转录和翻译到语音代理。与传统方法(客户端发送完整问题并等待完整答案)不同,双向流式传输允许语音和响应同时流动——用户可以在模型开始生成结果时立即看到结果,并且模型可以在连续流中保持上下文,而无需重新发送对话历史记录。该实现结合了HTTP/2和WebSocket协议,SageMaker基础设施负责管理从客户端到模型容器的有效多路复用连接。

该功能支持自带容器实现和合作伙伴集成,Deepgram是启动合作伙伴,通过AWS Marketplace提供其Nova-3语音转文本模型。此功能解决了实时语音AI应用的关键企业需求——特别是对于要求音频处理保留在其Amazon虚拟私有云(VPC)内的具有严格合规性需求的组织——同时消除了传统上与自托管实时AI解决方案相关的操作开销。持久连接方法减少了TLS握手和连接管理的 基础设施开销,用高效的长期会话取代了短暂连接。

开发人员可以通过两种方法实现双向流式传输:构建实现WebSocket协议在ws://localhost:8080/invocations-bidirectional-stream上(并具有适当的Docker标签com.amazonaws.sagemaker.capabilities.bidirectional-streaming=true)的自定义容器,或者直接从AWS Marketplace部署预构建的合作伙伴解决方案,如Deepgram的Nova-3模型。该功能要求容器处理传入的WebSocket数据帧并将响应帧发送回SageMaker,提供了Python和TypeScript的示例实现。有关更多详细信息,请参阅Amazon SageMaker AI上实时推理的双向流式传输介绍。

IPv6和PrivateLink

此外,SageMaker AI在2025年通过跨区域的全面PrivateLink支持和对公共及私有端点的IPv6兼容性扩展了其连接能力。这些增强功能极大地有助于改善服务的可访问性和企业部署的安全态势。PrivateLink集成使得可以从VPC私密访问SageMaker AI端点,而无需穿过公共互联网,将流量保留在AWS网络基础设施内部。这对于具有严格合规性要求或数据驻留政策,要求对机器学习工作负载进行私密连接的组织尤其有价值。

为SageMaker AI端点添加IPv6支持解决了组织转向IPv6时对现代IP寻址日益增长的需求。现在,您可以使用IPv6地址访问SageMaker AI服务,无论是公共端点还是私有VPC端点,为网络架构设计提供了灵活性,并使基础设施投资面向未来。双栈能力(同时支持IPv4和IPv6)有助于向后兼容,同时帮助组织按自己的节奏采用IPv6。结合PrivateLink,这些连接增强功能使SageMaker AI对各种企业网络环境更易于访问和更安全,从使用AWS Direct Connect连接的传统本地数据中心到完全构建在IPv6上的现代云架构。

结论

2025年对SageMaker AI的增强代表着使生成式AI工作负载对企业客户更具可观测性、可靠性和可访问性的重大飞跃。从精确定位基础设施瓶颈的细粒度性能指标到无服务器定制,这些改进解决了团队在规模化部署AI时面临的现实挑战。增强的可观测性、更安全的部署机制和简化的工作流程相结合,有助于使组织能够更快地发展,同时保持生产系统所需的可靠性和安全标准。

这些功能现已在所有区域推出,增强指标、滚动更新和无服务器定制等功能已准备好帮助改变您构建和部署AI应用程序的方式。无论您是为特定领域的任务微调模型、使用双向流式传输构建实时语音代理,还是通过滚动更新和集成监控促进部署安全,SageMaker AI都能提供工具来加速您的AI之旅,同时降低运营复杂性。

立即开始探索增强指标文档,试用无服务器模型定制,或为您的实时推理工作负载实现双向流式传输。有关实施这些功能的全面指南,请参阅Amazon SageMaker AI文档或联系您的AWS客户团队,讨论这些功能如何支持您的特定用例。

关于作者

Dan Ferguson是AWS的资深解决方案架构师,常驻美国纽约。作为机器学习服务专家,Dan致力于支持客户高效、有效地整合机器学习工作流程。

Dan Ferguson是AWS的资深解决方案架构师,常驻美国纽约。作为机器学习服务专家,Dan致力于支持客户高效、有效地整合机器学习工作流程。

Dmitry Soldatkin是AWS的高级机器学习解决方案架构师,协助客户设计和构建AI/ML解决方案。Dmitry的工作涵盖了广泛的ML用例,主要关注生成式AI、深度学习和企业级ML扩展。他曾帮助保险、金融服务、公用事业和电信等多个行业的公司。他对持续创新和利用数据推动业务成果充满热情。在加入AWS之前,Dmitry曾在金融服务行业的数据分析和机器学习领域担任架构师、开发人员和技术领导者。

Dmitry Soldatkin是AWS的高级机器学习解决方案架构师,协助客户设计和构建AI/ML解决方案。Dmitry的工作涵盖了广泛的ML用例,主要关注生成式AI、深度学习和企业级ML扩展。他曾帮助保险、金融服务、公用事业和电信等多个行业的公司。他对持续创新和利用数据推动业务成果充满热情。在加入AWS之前,Dmitry曾在金融服务行业的数据分析和机器学习领域担任架构师、开发人员和技术领导者。

Lokeshwaran Ravi是AWS的资深深度学习编译器工程师,专注于ML优化、模型加速和AI安全。他致力于提高效率、降低成本和构建安全生态系统,以实现AI技术的民主化,使尖端机器学习在各行业中都具有可访问性和影响力。

Lokeshwaran Ravi是AWS的资深深度学习编译器工程师,专注于ML优化、模型加速和AI安全。他致力于提高效率、降低成本和构建安全生态系统,以实现AI技术的民主化,使尖端机器学习在各行业中都具有可访问性和影响力。

Sadaf Fardeen领导SageMaker的推理优化章程。她负责SageMaker上LLM推理容器的优化和开发。

Sadaf Fardeen领导SageMaker的推理优化章程。她负责SageMaker上LLM推理容器的优化和开发。

Suma Kasa是SageMaker服务团队的ML架构师,专注于SageMaker上LLM推理容器的优化和开发。

Suma Kasa是SageMaker服务团队的ML架构师,专注于SageMaker上LLM推理容器的优化和开发。

Ram Vegiraju是SageMaker服务团队的ML架构师。他专注于帮助客户在Amazon SageMaker上构建和优化他们的AI/ML解决方案。在业余时间,他喜欢旅行和写作。

Ram Vegiraju是SageMaker服务团队的ML架构师。他专注于帮助客户在Amazon SageMaker上构建和优化他们的AI/ML解决方案。在业余时间,他喜欢旅行和写作。

Deepti Ragha是Amazon SageMaker AI团队的高级软件开发工程师,专注于ML推理基础设施和模型托管优化。她构建的功能旨在提高部署性能、降低推理成本,并使各种规模的组织都能使用ML。工作之余,她喜欢旅行、徒步旅行和园艺。

Deepti Ragha是Amazon SageMaker AI团队的高级软件开发工程师,专注于ML推理基础设施和模型托管优化。她构建的功能旨在提高部署性能、降低推理成本,并使各种规模的组织都能使用ML。工作之余,她喜欢旅行、徒步旅行和园艺。

🚀 想要体验更好更全面的AI调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,文档丰富,小白也可以简单操作。

评论区