📢 转载信息

原文链接:https://blogs.nvidia.com/blog/rtx-ai-garage-comfyui-tutorial/

原文作者:Joel Pennington

由人工智能驱动的内容生成现已嵌入到 Adobe 和 Canva 等日常工具中,大量的机构和工作室也将其技术整合到工作流程中。图像模型现在可以持续提供照片级写实的结果,视频模型可以生成长而连贯的片段,而且两者都可以遵循创意指导。

创作者越来越多地在个人电脑上本地运行这些工作流,目的是将素材保留在直接控制之下,消除云服务成本,并消除迭代的摩擦——从而使他们能够以真实创意项目所需的速度来完善输出。

自诞生以来,NVIDIA RTX PC 就一直是运行创意 AI 的首选系统,原因在于其高性能(缩短迭代时间)以及用户可以在其上免费运行模型,从而消除了对“Token”数量的焦虑。

随着本月早些时候 CES 上推出的最新 RTX 优化和新的开源模型,创作者可以更快、更高效地工作,并拥有更大的创意控制权。

入门指南

入门视觉生成式 AI 可能会让人感觉复杂且受限。在线 AI 生成器易于使用,但控制力有限。

像 ComfyUI 这样的开源社区工具简化了高级创意工作流程的设置,并且易于安装。它们还提供了一种简单的方法来下载最新最好的模型,例如 FLUX.2 和 LTX-2,以及顶级的社区工作流。

以下是如何使用 ComfyUI 和流行模型在 RTX PC 上本地启动视觉生成式 AI 的方法:

- 访问 comfy.org 下载并安装适用于 Windows 的 ComfyUI。

- 启动 ComfyUI。

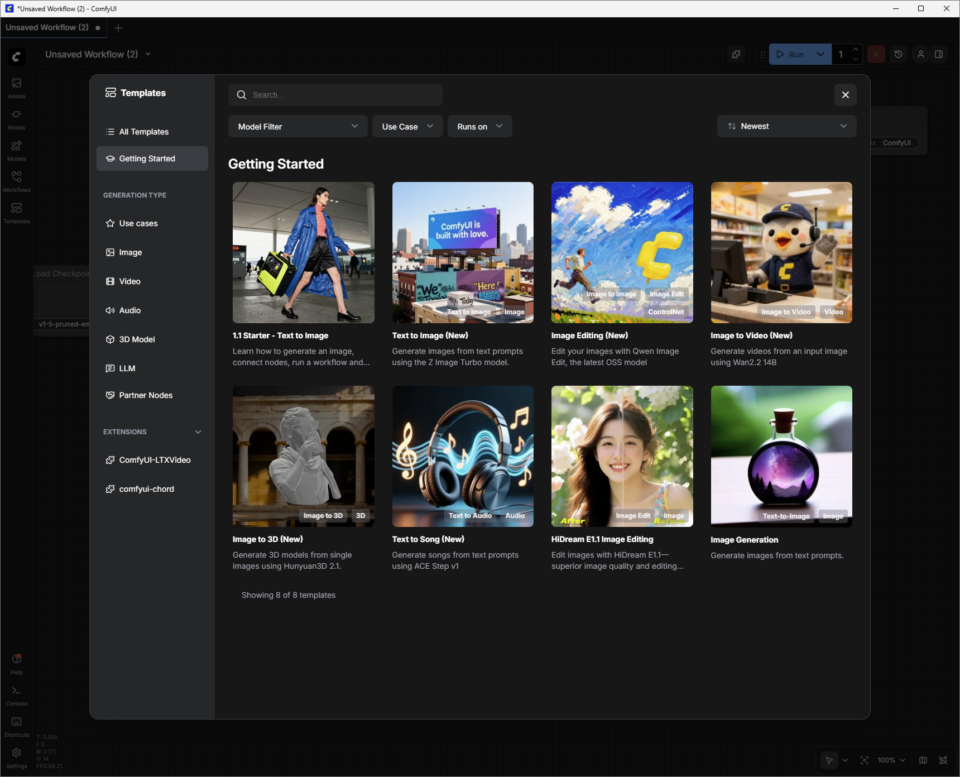

- 使用入门模板创建初始图像:

- 点击“Templates”(模板)按钮,然后点击“Getting Started”(入门),并选择“1.1 Starter – Text to Image”(1.1 入门 – 文本生成图像)。

- 将模型“Node”(节点)连接到“Save Image Node”(保存图像节点)。这些节点在一个管道中协同工作,利用 AI 生成内容。

- 按下蓝色的“Run”(运行)按钮,观察绿色的“Node”高亮显示,您的 RTX 驱动的 PC 就会生成第一张图像。

更改提示词并再次运行,即可更深入地进入视觉生成式 AI 的创意世界。

请在下方阅读更多内容,了解如何深入研究使用更高级图像和视频模型的其他 ComfyUI 模板。

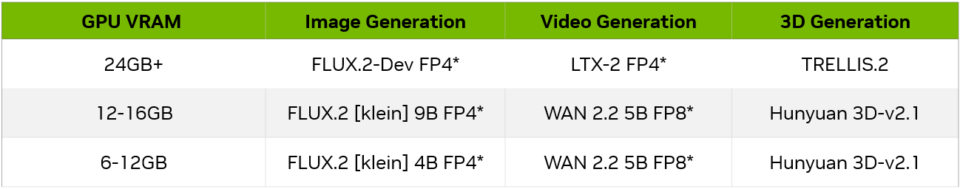

模型大小与 GPU

随着用户对 ComfyUI 及其支持的模型越来越熟悉,他们需要考虑 GPU 显存(VRAM)容量以及模型是否能容纳其中。以下是根据 GPU 显存大小的入门示例:

生成图像

要探索如何使用 FLUX.2-Dev 提高图像生成质量:

在 ComfyUI 的“Templates”(模板)部分,点击“All Templates”(所有模板)并搜索“FLUX.2 Dev Text to Image”。选择它,ComfyUI 就会加载连接的节点集合,即“Workflow”(工作流)。

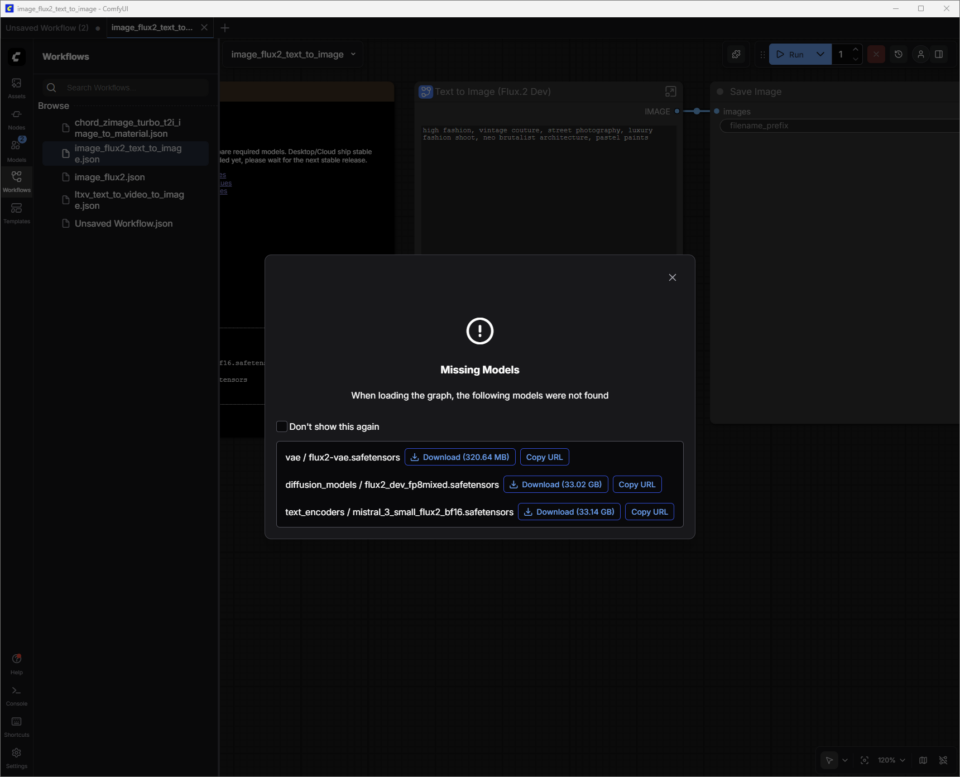

FLUX.2-Dev 具有需要下载的模型权重。

模型权重是 AI 模型内部的“知识”——您可以将其视为大脑中的突触。当像 FLUX.2 这样的图像生成模型经过训练时,它会从数百万张图像中学习模式。这些模式以数十亿个称为“权重”的数值形式存储。

ComfyUI 没有内置这些权重。相反,它会根据需要从 Hugging Face 等存储库下载它们。这些文件很大(FLUX.2 的大小可能超过 30GB,具体取决于版本),这就是系统需要足够的存储空间和下载时间来获取它们的原因。

将出现一个对话框,指导用户下载模型权重。权重文件(filename.safetensors)会自动保存到用户 PC 上正确的 ComfyUI 文件夹中。

保存工作流:

模型权重下载完成后,下一步是将这个新下载的模板保存为“Workflow”(工作流)。

用户可以点击左上角的汉堡菜单(三条横线)并选择“Save”(保存)。该工作流现在保存在用户的“Workflows”(工作流)列表中(按 W 键显示或隐藏该窗口)。关闭标签页即可退出工作流,而不会丢失任何工作。

如果不小心在模型权重下载完成之前关闭了下载对话框:

- 按 W 键快速打开“Workflows”(工作流)窗口。

- 选择工作流,ComfyUI 将加载它。这也会提示下载任何缺失的模型权重。

- ComfyUI 现在已准备好使用 FLUX.2-Dev 生成图像。

FLUX.2-Dev 的提示词技巧:

- 从对主体、场景、风格和情绪的清晰、具体的描述开始——例如:“复古赛车在雨中的电影特写镜头,湿沥青上的霓虹反射,高对比度,35mm 摄影。”对于入门者来说,短到中等长度的提示词——一句或两句集中的句子——通常比长篇叙事提示词更容易控制。

- 添加约束条件以指导一致性和质量。指定以下内容:

- 构图(“广角镜头”或“肖像”)

- 细节级别(“高细节,焦点锐利”)

- 写实度(“照片级写实”或“风格化插画”)

- 如果结果过于复杂,请删除形容词而不是添加更多。

- 避免使用负面提示词——坚持提示您想要的内容。

请在 Black Forest Labs 的这篇指南中了解有关 FLUX.2 提示词的更多信息。

磁盘上的保存位置:

完成图像精修后,右键单击“Save Image Node”(保存图像节点)即可在浏览器中打开图像,或将其保存到新位置。

ComfyUI 的默认输出文件夹通常如下所示,具体取决于应用程序类型和操作系统:

- Windows(独立/便携版):该文件夹通常在 C:\ComfyUI\output 或程序解压位置附近的类似路径中。

- Windows(桌面应用程序):路径通常位于 AppData 目录内,例如:C:\Users\%username%\AppData\Local\Programs\@comfyorgcomfyui-electron\resources\ComfyUI\output

- Linux:安装位置默认为 ~/.config/ComfyUI。

提示词生成视频

探索如何提高视频生成质量,以新的 LTX-2 模型为例:

Lightrick 的 LTX‑2 是一款先进的音视频模型,专为在 ComfyUI 中进行可控的、故事板风格的视频生成而设计。下载 LTX‑2 图像到视频模板和模型权重后,请开始像对待简短的镜头描述而不是完整的电影剧本一样来撰写提示词。

与前两个模板不同,LTX‑2 图像到视频模板将图像和文本提示词结合起来生成视频。

用户可以将一个使用 FLUX.2-Dev 生成的图像,并添加文本提示词来赋予其生命力。

LTX‑2 的提示词技巧:

要在 ComfyUI 中获得最佳效果,请使用现在时书写一个连贯的段落,或者使用简单的脚本格式,包括场景标题(sluglines)、动作、角色名称和对话。目标是四到六个描述性句子,涵盖所有关键方面:

- 确立镜头和场景(广角/中景/特写、光照、颜色、纹理、氛围)。

- 将动作描述为清晰的序列,定义具有可见特征和肢体语言的角色,并指定摄像机移动。

- 最后,使用引号添加音频,例如环境声音、音乐和对话。

- 将细节级别与镜头尺度相匹配。例如,特写镜头需要比广角镜头更精确的角色和纹理细节。请清楚说明摄像机相对于主体的关系,而不仅仅是它的移动方向。

可以考虑添加到提示词中的其他细节:

- 摄像机移动语言:指定方向,如“慢速推近”、“手持跟踪”、“过肩镜头”、“横向移动”、“向上倾斜”、“推入”、“拉回”或“静态帧”。

- 镜头类型:指定广角、中景或特写,并注意细致的光照、浅景深和自然运动。

- 节奏:指导慢动作、延时摄影、持久镜头、连续镜头、冻结帧或无缝过渡,以塑造节奏和基调。

- 氛围:添加雾、薄雾、雨、黄金时刻光线、反射和丰富的表面纹理等细节,以使场景扎根。

- 风格:在提示词的开头指定风格,如绘画风、黑色电影、胶片感、定格动画、像素化边缘、时尚编辑或超现实。

- 光照:使用特定语言指导逆光、特定调色板、柔和的轮廓光、镜头光晕或其他光照细节。

- 情感:专注于提示单主体表演,具有清晰的面部表情和小手势。

- 声音和音频:提示角色以不同语言讲话或唱歌,并配以清晰的环境声音描述。

优化显存使用和图像质量

作为前沿模型,LTX-2 使用大量的显存(VRAM)来提供高质量的结果。随着分辨率、帧率、长度或步数的增加,内存使用量也会增加。

ComfyUI 和 NVIDIA 合作优化了一项权重流式传输功能,如果 GPU 显存耗尽,该功能允许用户将工作流的部分内容卸载到系统内存中——但这会以性能为代价。

根据 GPU 和用例,用户可能希望限制这些因素,以确保合理的生成时间。

LTX-2 是一个非常先进的模型——但与任何模型一样,调整设置会对质量产生很大影响。

在 ComfyUI 中 LTX-2 的快速入门指南中了解有关使用 RTX GPU 优化 LTX-2 使用的更多信息。

使用 FLUX.2-Dev 和 LTX-2 构建自定义工作流

用户可以通过将模型组合到一个新的工作流中,简化在 FLUX.2-Dev 以生成图像、在磁盘上找到它,并将其作为图像提示添加到 LTX-2 图像到视频工作流之间的过程:

- 打开保存的 FLUX.2-Dev 文本到图像工作流。

- 按住 Ctrl 键并用鼠标左键单击 FLUX.2-Dev 文本到图像节点。

- 在 LTX-2 图像到视频工作流中,使用 Ctrl+V 粘贴该节点。

- 只需将鼠标悬停在 FLUX.2-Dev 文本到图像节点的 IMAGE 点上,左键单击并拖动到 Resize Image/Mask Input(调整图像/遮罩输入)点上。将出现一个蓝色的连接器。

以新名称保存,即可在一个工作流中同时完成图像和视频的文本提示。

高级 3D 生成

除了使用 FLUX.2 生成图像和使用 LTX‑2 生成视频之外,下一步是添加 3D 引导。 NVIDIA 3D 引导生成式 AI 蓝图展示了如何使用 3D 场景和资产来驱动 RTX PC 上更可控、更具制作风格的图像和视频管道——其中包含用户可以检查、调整和扩展的现成工作流。

创作者可以在 Stable Diffusion subreddit 和 ComfyUI Discord 上展示他们的作品、与其他用户联系并寻求帮助。

#ICYMI — NVIDIA RTX AI PC 的最新进展

💻CES 2026 上的 NVIDIA

CES 的公告包括使用 LTX-2 和 ComfyUI 升级,在 PC 上加速 4K AI 视频生成。此外,ComfyUI、LTX-2、Llama.cpp、Ollama、Hyperlink 等方面的主要 RTX 加速解锁了 AI PC 上的视频、图像和文本生成用例。

📝 Black Forest Labs 的 FLUX 2 变体

FLUX.2 [klein] 是一组紧凑、超快速的模型,支持图像生成和编辑,提供最先进的图像质量。这些模型通过 NVFP4 和 NVFP8 加速,速度提高多达 2.5 倍,使其能够在各种 RTX GPU 上高效运行。

✨Project G-Assist 更新

借助默认启用的新“Reasoning Mode”(推理模式),Project G-Assist 在准确性和智能方面得到了提升,并且能够一次执行多个命令。G-Assist 现在可以通过 iCUE 控制 G-SYNC 显示器、CORSAIR 外围设备和 CORSAIR PC 组件的设置——涵盖照明、配置文件、性能和冷却。

很快还将增加对 Elgato Stream Decks 的支持,使 G-Assist 更接近于统一的 AI 界面,用于调整和控制几乎任何系统。对于 G-Assist 插件开发者来说,一个新的基于光标的插件构建器使用 Cursor 的智能体式编码环境加速开发。

在 Facebook、Instagram、TikTok 和 X 上关注 NVIDIA AI PC ——并通过订阅 RTX AI PC 新闻邮件保持了解。

在 LinkedIn 和 X 上关注 NVIDIA Workstation。

请参阅有关软件产品信息的声明。

🚀 想要体验更好更全面的AI调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,文档丰富,小白也可以简单操作。

评论区