📢 转载信息

原文链接:https://www.nature.com/articles/d41586-025-04106-0

原文作者:Nature

你无需成为先知,也能预见到来年人工智能领域将出现更多进展,新的和更新的模型、出版物和专利将持续不断地涌现。如果当前的趋势具有参考价值,许多国家也将出台更多与人工智能相关的法律法规。根据加利福尼亚州斯坦福大学研究人员制作的《2025年人工智能指数报告》(Artificial Intelligence Index Report 2025),2023年全球至少通过了30项此类法律,次年又增加了40项。

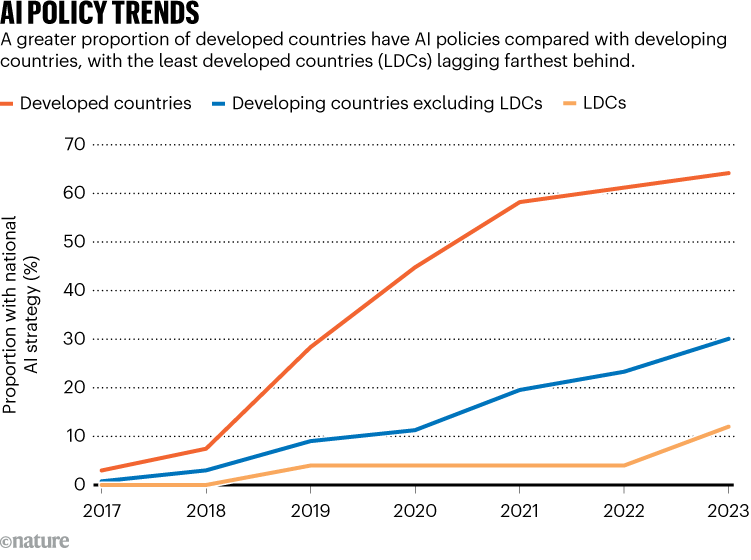

过去几年中,人工智能立法最活跃的地区是东亚和太平洋地区、欧洲以及美国的一些州。2024年,美国各州通过了82项人工智能相关法案。但也有一些显著的冷门地区:低收入和中低收入国家(见“人工智能政策趋势”)的活动相对较少。与此同时,美国联邦政府正在逆势而行,取消人工智能政策工作并挑战州级人工智能法律。

来源:联合国贸易和发展会议,基于《2024年人工智能指数报告》数据。

今年必须是更多低收入国家开始监管人工智能技术,并且美国说服其认识到当前做法的危险性的一年。美国是人工智能技术最大的市场之一,全世界的人们都在使用主要由美国公司开发的模型。无论一个国家在生产者和消费者光谱上的位置如何,所有国家都需要人工智能法律和政策。我们无法想象能源、粮食生产、制药或通信等领域的技术不受安全监管的约束。人工智能也应如此。

国际共识正在形成。例如,中国当局对人工智能监管极为重视,许多欧洲国家也是如此。欧盟《人工智能法案》的大部分规定预计将于八月生效。2024年,非洲联盟发布了全非洲范围的人工智能政策制定指南。此外,也有人在努力建立一个全球性的人工智能合作组织,可能通过联合国来实现。

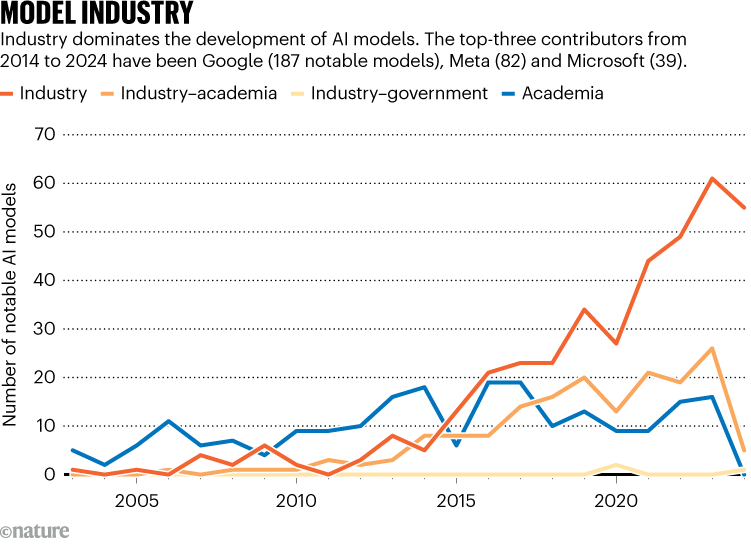

一系列国家和地区的法律法规已经或正在制定中。例如,一些国家正试图禁止“深度伪造”(deepfake)视频。这应该是一个普遍目标。公司还应提供用于训练模型的数据的详细信息,并确保在训练过程中尊重版权。首要目标必须是实现类似于管理其他通用技术的监管。人工智能开发者——其中大多数是公司(见“模型行业”)——需要透明地解释其产品的工作原理,证明其模型是通过合法手段生产的,并表明技术是安全的,且对风险和伤害负有责任。研究人员也需要透明度,其中更多的人需要将他们的模型发表在同行评审的文献中。

来源:《2025年斯坦福人工智能指数报告》。

据联合国贸易和发展会议(UNCTAD)——负责低收入和中等收入国家的联合国贸易政策机构——报告,到2023年底,三分之二的高收入国家和30%的中等收入国家制定了人工智能政策或战略,而最低收入国家中只有略高于10%的国家做到了。这些国家需要在其人工智能监管努力中得到支持。

此外,还需要与美国进行接触。唐纳德·特朗普总统上任后,取消了前一届政府设立的一项计划,该计划通过该计划,国家标准与技术研究院(NIST)已开始与技术公司一起评估人工智能标准。12月,一项行政命令发布,禁止与白宫人工智能政策相冲突的州法律。

一些科技公司的领导者似乎对这种发展方向感到满意。但另一些公司知道,良好的监管能为公司带来标准的一致性,并使他们能够进行可预测的长期规划。对公司及其客户而言,宽松的监管,或者完全没有监管,都不是有利的。

监管机构的公务员知道需要更好的监管,既要保护人民(特别是儿童)免受伤害,也要让消费者安心。他们可以看到公众对人工智能的风险存在相当大的焦虑,这部分是由于公司宣称要致力于实现通用人工智能(artificial general intelligence)的雄心所加剧的。他们也听到了人工智能研究界的声音,包括该领域的一些先驱者,他们正在警告来自不可控人工智能的潜在生存风险。

特朗普政府的官员表示,监管可能会导致美国在人工智能竞赛中落后于中国。但是,正如《自然》新闻团队报道的那样(《自然》 648, 503–505; 2025),中国正在探索一条替代性的创新路径。其人工智能公司正在创建创新产品,使用比美国同行更开放的技术,并在需要更多披露信息的全国性法规下开展工作。

科技公司知道,他们的商业模式依赖于公众的合作,特别是在数据访问方面。如果人们对他们的数据安全和被负责任地使用失去信心,或者发现人工智能产品正在伤害他人,这种合作将会消失。

人工智能是一项潜在的变革性技术。然而,我们不知道这将如何体现,也不知道它将产生何种影响。许多国家在评估风险方面保持谨慎是正确的,但政策制定需要更多的协调一致。各国应共同努力,设计不仅能促进发展,而且能包含安全护栏的政策。让2026年成为大家就此达成共识的一年吧。

🚀 想要体验更好更全面的AI调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,文档丰富,小白也可以简单操作。

评论区