📢 转载信息

原文链接:https://www.deeplearning.ai/the-batch/issue-322

原文作者:DeepLearning.AI

重磅发布:Agentic AI 课程,带你掌握下一代智能体构建核心技术

朋友们,我非常激动地宣布我的最新课程:Agentic AI!本课程将帮助您快速掌握构建前沿智能体(Agentic Workflows)的技能。您可以在 DeepLearning.AI 网站上找到它:点此查看。唯一的先决条件是熟悉 Python,了解一些 LLM 知识会更有帮助。

本课程采用自定进度模式,以厂商中立的方式授课,使用纯 Python 编码——不会将细节隐藏在框架中。因此,您将学到核心概念,这些概念可以随后使用任何流行的 Agentic AI 框架实现,或者无需任何框架。

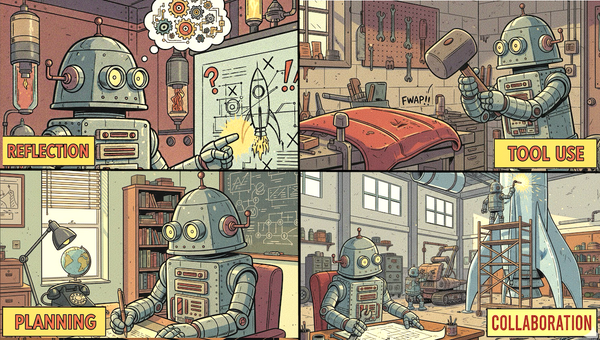

具体来说,您将学习如何实现四个关键的智能体设计模式:

- 反思(Reflection):智能体审视自己的输出并找出改进方法。

- 工具使用(Tool Use):由 LLM 驱动的应用程序决定调用哪些函数来执行网络搜索、访问日历、发送电子邮件、编写代码等。

- 规划(Planning):您将使用 LLM 来决定如何将任务分解为子任务以供执行。

- 多智能体协作(Multi-agent Collaboration):构建多个专业智能体——就像公司雇佣多个员工一样——来执行复杂任务。

更重要的是,您还将学习构建高效智能体的最佳实践。

通过与许多团队合作的经验,我发现,一个人能否有效构建智能体的最大预测指标是他们是否懂得如何执行有纪律的评估(evals)和错误分析流程。不懂得这样做的团队可能会花费数月时间调整智能体,却收效甚微。我见过一些团队花费数月时间调整提示词、为智能体构建工具等,最终却遇到了无法突破的性能瓶颈。

但是,如果您了解如何在每一步(即“追踪” traces)中嵌入评估并监控智能体的动作,您就能高效地锁定需要改进的组件。您将不再盲目猜测,而是让评估数据来指导您。

您还将学习如何将复杂的应用程序系统地分解为一系列任务,并使用上述设计模式来实现它们。理解这个过程后,您也将能更好地发现构建智能体的机会。

本课程通过代码生成、客户服务智能体和自动化营销工作流等多个示例来说明这些概念。我们还将构建一个深度研究智能体,它可以搜索信息、总结和综合,并生成深思熟虑的报告。

完成本课程后,您将了解智能体的关键构建块,以及组装和调整这些构建块的最佳实践。这将使您远远领先于目前构建智能体的大多数团队。

请加入我的课程,让我们一起构建令人惊叹的智能体!

继续构建,

Andrew

来自 DeepLearning.AI 的消息

由 Andrew Ng 和 DeepLearning.AI 主办的 AI Dev 25 大会即将登陆纽约!11 月 14 日,与 1200 多名 AI 开发者一起参加为期一天的活动,活动包括技术主题演讲、动手研讨会、现场演示以及全新的金融科技(Fintech)专场。立即锁定您的门票!

最新资讯

Claude 实力再升级

Anthropic 更新了其中等规模模型 Claude Sonnet,使其成为 Claude 系列中首个达到 4.5 版本的成员。它还增强了 Claude Code 智能体编程工具,加入了期待已久的功能。

Claude Sonnet 4.5:新模型提供了性能的显著提升以及推理 Token 的可变预算。

- 输入/输出:文本和图像输入(根据服务层级,最高可达 20 万到 100 万 Token),文本输出(最高 64,000 Token)。

- 可用性:可通过 Claude.ai 免费使用,API 访问通过 Anthropic、Amazon Bedrock 和 Google Vertex 的输入/输出分别为每百万 Token 3 美元/15 美元。

- 特性:支持可变 Token 预算推理,“扩展处理时间”(根据文档描述为“数小时”),任务的串行(而非并行)完成。

- 知识截止日期:2025 年 1 月。

- 未公开:模型架构、训练数据和方法。

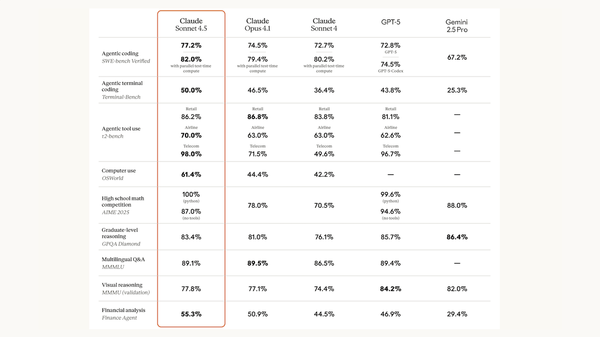

测试结果:在 Anthropic 的测试中,Claude Sonnet 4.5 在编码指标上表现突出,但在更广泛的评估中表现良好。

- 在 32,000 Token 的推理预算下,Claude Sonnet 4.5 目前位居 LM Arena 文本排行榜榜首。如果没有推理能力,它排名第四。

- 在 SWE-bench Verified 的编码挑战中,Claude Sonnet 4.5(82%)提高了最先进水平,超过了此前的领导者 Claude Sonnet 4(80.2%)和 Claude Opus 4.1(79.4%)。

- 在计算机使用基准测试 OSWorld 中,它取得了 61.4% 的成绩,远超其他排行榜上可用模型的表现。

- 当它使用 Python 工具时,在 AIME 2025 的数学问题测试中取得了 100% 的成绩,尽管当两个模型都不使用工具时,GPT-5 表现更佳。

- 在 GPQA-Diamond 和 MMMLU 等视觉推理测试中,Sonnet 4.5 的整体表现优于更大的 Claude Opus 4.1,但略逊于 Google Gemini Pro 4.5 和 OpenAI GPT-5。

Claude Code:Anthropic 的智能体编程工具进行了一次设计大修,增加了许多新功能。值得注意的是,它提供了一个软件开发工具包(SDK)——基于支撑 Claude Code 的相同软件基础设施、工具集、编排逻辑和内存管理——用于构建其他智能体工具。

- Claude Agent SDK。新的软件开发工具包将 Claude 模型与用于网络搜索、文件管理、代码部署和其他自主功能的软件工具配对。它提供了 Claude Code 所有功能所需的构建块,以便您可以构建自己的智能体应用程序。

- 上下文跟踪。当输入超过模型的上下文限制时,智能体用例需要保持连续性。当模型的消息历史接近此限制时,Claude Code 会要求模型总结最关键的细节,并将摘要作为最新输入传递给模型。它还会删除不再需要的工具结果,为进一步输入腾出空间。

- 内存。一个新的 API “内存工具”使模型能够在输入之外存储和检索特别重要的信息,例如项目状态。

- 检查点(Checkpoints)。Claude Code 现在存储检查点,保存安全状态,以便在出现错误时可以回滚。它还增加了一个 IDE 扩展,可用于 VSCode 和类似应用程序,以替代终端。

新闻背景:Anthropic 由前 OpenAI 员工创立,将自己定位为 OpenAI 的替代者:更安全、更人道、更有品味。尽管它从未停止宣扬这些价值观,但重点已变得更简单:编码和工作效率。虽然 ChatGPT 在消费者中可能是 AI 的代名词,但 Anthropic 正专注于软件开发人员和企业。

重要意义:Claude Sonnet 4.5 与增强的 Claude Code 的结合,体现了 Anthropic 对工作效率的重视。这种关注回应了商业世界的一些焦虑:AI 什么时候能为我的员工带来回报?它将如何改变他们的工作方式?目前来看,编码(通过 Claude Code 或竞争对手)是一个明显的答案。

我们的思考:Claude Agent SDK 是一个重要的发布,它将使许多开发人员能够构建强大的智能体应用。我们期待 Claude 衍生出爆炸性的应用生态!

通义千问 3 (Qwen3) 既有“大”也有“小”

阿里巴巴为其 Qwen3 系列增添了迄今为止最大的大型语言模型,同时也发布了可以处理文本、图像、视频和/或音频的更小模型。

最新动态:闭源的 Qwen3-Max 使阿里巴巴在最大的大型语言模型中占有一席之地。 Qwen3-VL-235B-A22B 是一个开源模型,在同等规模中处理文本、图像和视频表现顶尖。另一个开源模型 Qwen3-Omni 则加入了音频处理功能,并取得了优异的结果。

Qwen3-Max 拥有 1 万亿参数,在 36 万亿 Token 上进行训练。它提供基础版和指令微调版,推理版即将推出。与阿里巴巴的其他 Max 模型一样(但与大多数 Qwen 系列不同),其权重不公开。

- 输入/输出:文本输入(最高 262,000 Token),文本输出(最高 65,536 Token)。

- 架构和训练:1 万亿参数的混合专家(MoE)解码器,具体的训练数据和方法未公开。

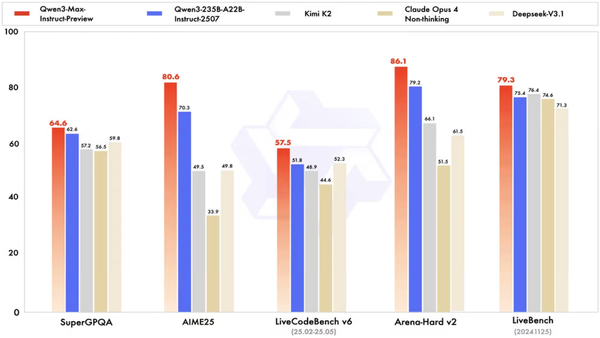

- 性能:在阿里巴巴的测试中,Qwen3-Max 的整体表现略逊于 Google Gemini 2.5 Pro 和 OpenAI GPT-5,但优于 Anthropic、DeepSeek 和 xAI 的大型模型。在 Artificial Analysis 的 智能指数上,其得分仅略低于较小的 Qwen3-235B-A22B。

- 可用性:通过 新加坡阿里云,输入/输出 Token 价格为每百万 1.20 美元/6.00 美元;通过 北京阿里云,价格为每百万 0.861 美元/3.441 美元。

Qwen3-VL-235B-A22B 是 Qwen3-235B-A22B 的视觉语言变体,专为需要理解图像和视频的智能体交互而设计。它提供基础版、指令微调版和推理版。

- 输入/输出:文本、图像、视频输入(最高 262,000 Token,可扩展至 100 万 Token),文本输出(最高 81,920 Token)。

- 架构和训练:混合专家(MoE)解码器(总共 2350 亿参数,每个 Token 激活 220 亿),视觉编码器,具体的训练数据和方法未公开。

- 性能:在阿里巴巴的测试中,Qwen3-VL-235B-A22B 优于其他开源模型,并且在许多图像和视频基准测试中,无论是否有推理能力,其表现都与现有最佳模型相当。它在数学视觉(MathVision)、设计到代码(Design2Code)以及多项文本识别测试中,确立了开源和闭源模型的新 SOTA。在智能体能力(ScreenSpot Pro, OSWorldG, Android World)、文档理解(MMLongBench-Doc, DocVQATest)和 2D/3D 空间感知(CountBench)测试中,它优于 Gemini 2.5 Pro 和 OpenAI GPT-5。在 MMMU-Pro 的科学、技术和数学部分、SimpleVQA 中的视觉推理谜题以及 VideoMMMU 中的视频理解挑战方面,其表现仅次于 Gemini Pro 2.5。

- 可用性:根据 Apache 2.0 许可,商用和非商用用途免费;通过 阿里云,输入/输出 Token 价格为每百万 0.70 美元/2.80 美元。

Qwen3-Omni-30B-A3B 对文本、图像、视频和音频进行了预训练,因此它可以直接在它们之间进行转换。它提供指令微调版和推理版,以及一个专用的音频/视频字幕模型。

- 输入/输出:文本、图像、视频或音频输入(最高 65,536 Token),文本或语音输出(最高 16,384 Token)。

- 架构和训练:混合专家(MoE)Transformer(总共 300 亿参数,每个 Token 激活 30 亿),专用于多模态和语音处理的专家,具体的训练数据和方法未公开。

- 性能:Qwen3-Omni 是性能最好的开源语音模型,在许多测试中优于 GPT-4o。在 36 个音频和音视频基准测试中,Qwen3-Omni-30B-A3B 在 22 个测试中取得了 SOTA 结果。在混合媒体理解和语音输出测试中,其结果与 Gemini 2.5 Pro、ByteDance Seed-ASR 和 OpenAI GPT-4o Transcribe 相当。

- 可用性:根据 Apache 2.0 许可,商用和非商用用途免费;通过 阿里云,文本输入/输出价格为每百万 0.52 美元/1.99 美元;图像-视频输入/文本输出价格为每百万 0.94 美元/3.67 美元;音频输入/输出价格为每百万 4.57 美元/18.13 美元。

新闻背景:阿里巴巴最近发布了 Qwen3-Next,它通过交替使用注意力层和 Gated DeltaNet 层来加速性能。新模型不使用这种架构,但这仍然是 Qwen 系列未来模型的潜在发展方向。

重要意义:虽然 Qwen3-Max 在性能上略逊于竞争对手,但新发布的开源多模态模型为开发人员提供了机会。Qwen3-VL-235B-A22B 提供了低成本、多功能性和可定制性,而 Qwen3-Omni-30B-A3B 为语音应用提供了有益的选择。阿里巴巴一直是一个持续、多样的实验者,将开源发布放在首位,其新发布涵盖了广泛的需求。

我们的思考:我们乐于看到开源模型取得世界领先的成果!凭借在多媒体理解、推理和工具使用方面的能力,Qwen3-VL 和 Qwen3-Omni 使所有开发人员都能实现广泛的智能体应用。

OpenAI、Meta 推动 AI 产品线多元化

OpenAI 和 Meta 之前满足于提供独立聊天机器人或将其集成到现有产品中,现在推出了互相竞争的社交视频网络及其他旨在提高收入和参与度的举措。

最新动态:OpenAI 的 Sora 2 是一款类似 TikTok 的应用,允许用户分享 10 秒的短片;而 Meta 的 Vibes 则允许 Facebook 用户生成新视频或混剪现有视频。此外,OpenAI 推出了 ChatGPT Pulse,该服务根据最近的聊天记录和连接的应用(如日历)数据创建个性化简报;以及 Instant Checkout,允许 ChatGPT 用户在聊天过程中购物。

工作原理:这些新举措利用了现有的 AI 能力来提高参与度和创收。

- Sora 2:OpenAI 的社交视频应用上周末登顶 iOS App Store 榜首。它允许用户生成有限数量的 10 秒、640x480 像素的短片,而 ChatGPT Pro(每月 200 美元)的订阅者可以无限量生成 20 秒、1920x1080 像素的短片。用户可以生成自己的肖像并允许他人生成(正如 OpenAI CEO Sam Altman 所做的那样,激发了他的观众生成关于他在 Target 商店偷窃 GPU 等滑稽片段)。在版权所有者提出异议后,该公司收紧了对动漫和其他角色的使用限制,Altman 在博客文章中写道。

- Vibes:Meta 的社交视频流显示在其 Meta AI 应用的免费标签下或在 Vibes 网站上。用户不能将自己放入视频中,但他们可以根据上传的图像生成剪辑,或者混剪其信息流中的现有视频,同时添加音乐和更改视觉风格。生成的视频可以发布到 Instagram 和 Facebook。

- ChatGPT Pulse:Pulse 是一种新型的个性化新闻和生产力服务。它跟踪用户的聊天、电子邮件和日历条目,创建旨在预测用户关注点并提供相关新闻、提醒、建议和提示的卡片。该服务目前仅限于 ChatGPT Pro 订阅者,但 OpenAI 表示最终会以某种形式对所有用户免费开放。

- Instant Checkout:要求产品推荐的 ChatGPT 用户无需离开聊天机器人界面即可从 Etsy 和 Shopify 购买推荐的商品。OpenAI 从销售中赚取佣金,这种结构类似于为 Wirecutter 等产品推荐服务产生收入的联盟链接;该公司表示,其佣金不会影响 ChatGPT 的推荐。在 ChatGPT 中的购买通过 Agentic Commerce Protocol 处理,这是 OpenAI 与支付处理商 Stripe 合作推出的协议,类似于谷歌的 Agent Payments Protocol。

新闻背景:OpenAI 目前的收入主要依赖于聊天机器人订阅,约占总收入的 80%。然而,在 ChatGPT 7 亿周活跃用户中,只有极少数订阅了服务。实施速率限制等策略会说服一部分用户注册,但个性化生产力、购物佣金和广告为从其余用户中获利提供了途径。

重要意义:基于生成式 AI 的产品已经确立,但仍处于起步阶段,还有无数的 AI 驱动的消费产品和服务有待发明。OpenAI 的 ChatGPT Pulse 是一个真正新颖的想法,利用智能体能力在任何领域提供及时、个性化的信息和观点。OpenAI 和 Facebook 都在试验社交视频,为用户提供了娱乐朋友和表达自己的新方式。当然,随着人们越来越多地将聊天机器人作为购买建议的来源,将大型语言模型与数字商务相结合可能会变得自然。

我们的思考:此类 AI 驱动产品的财务成功必将对未来 AI 研究和开发的走向产生深远影响。

LoRA 适配器即取即用

LoRA 方法通过训练一个小的适配器来修改预训练模型的权重(在推理时),从而简化了微调过程。研究人员构建了一个可以直接生成此类适配器的模型。

最新动态:东京初创公司 Sakana AI 的 Rujikorn Charakorn 及其同事推出了 Text-to-LoRA 模型,该模型根据描述要由另一个大型语言模型执行的任务的自然语言描述来生成特定任务的 LoRA 适配器。

核心洞察:通常,LoRA 适配器是为特定任务训练的。然而,一个模型可以学习根据任务描述,生成一个适用于它在训练中可能未遇到的任务的适配器。

工作原理:作者训练了一个标准的神经网络,使其根据描述任务的文本,为大型语言模型 Mistral-7B-Instruct 生成一个任务特定的 LoRA 适配器。

- 作者使用 479 个任务(例如回答物理问题和解决数学应用题)来训练该网络。每个任务包含 128 个示例输入-输出对以及一个描述,例如解决数学应用题的描述:“此任务通过数学推理挑战您的解决问题能力。您必须仔细阅读每种情况并系统地处理数据以计算最终结果。”

- 他们通过将任务描述传递给 gte-large-en-v1.5(一个预训练的嵌入模型)来生成任务描述的嵌入。

- 给定任务描述的嵌入和指定要适配的 Mistral-7B-Instruct 层的嵌入,Text-to-LoRA 学会生成 LoRA 适配器。具体来说,它学会了最小化 LoRA 适配后的 Mistral-7B-Instruct 的输出与真实输出之间的差异。

结果:作者在 10 个推理基准测试(如 BoolQ、Hellaswag 和 WinoGrande)上评估了使用 Text-to-LoRA 的 Mistral-7B-Instruct。他们将结果与 Mistral-7B-Instruct(i)使用常规任务特定适配器、(ii)使用同时在所有 479 个训练任务上训练的单个适配器、(iii)仅附加任务描述提示、(iv)使用纯提示进行比较。

- 在所有基准测试中,使用 Text-to-LoRA 的 Mistral-7B-Instruct 取得了 67.7% 的平均准确率。使用多任务适配器的 LLM 取得了 66.3%。仅附加任务描述提示的未适配 LLM 平均准确率为 60.6%,而纯提示的准确率为 55.8%。

- 与常规 LoRA 适配器相比,作者报告了 8 个任务(不包括 GSM8K 和 HumanEval)的结果。使用 Text-to-LoRA 的 Mistral-7B-Instruct 表现最佳(75.8%)。使用常规适配器的 LLM 取得了 73.9... [内容被截断]

🚀 想要体验更好更全面的 AI 调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,小白也可以简单操作。

青云聚合API官网https://api.qingyuntop.top

支持全球最新300+模型:https://api.qingyuntop.top/pricing

详细的调用教程及文档:https://api.qingyuntop.top/about

评论区