📢 转载信息

原文链接:https://www.ithome.com/0/888/960.htm

原文作者:IT之家

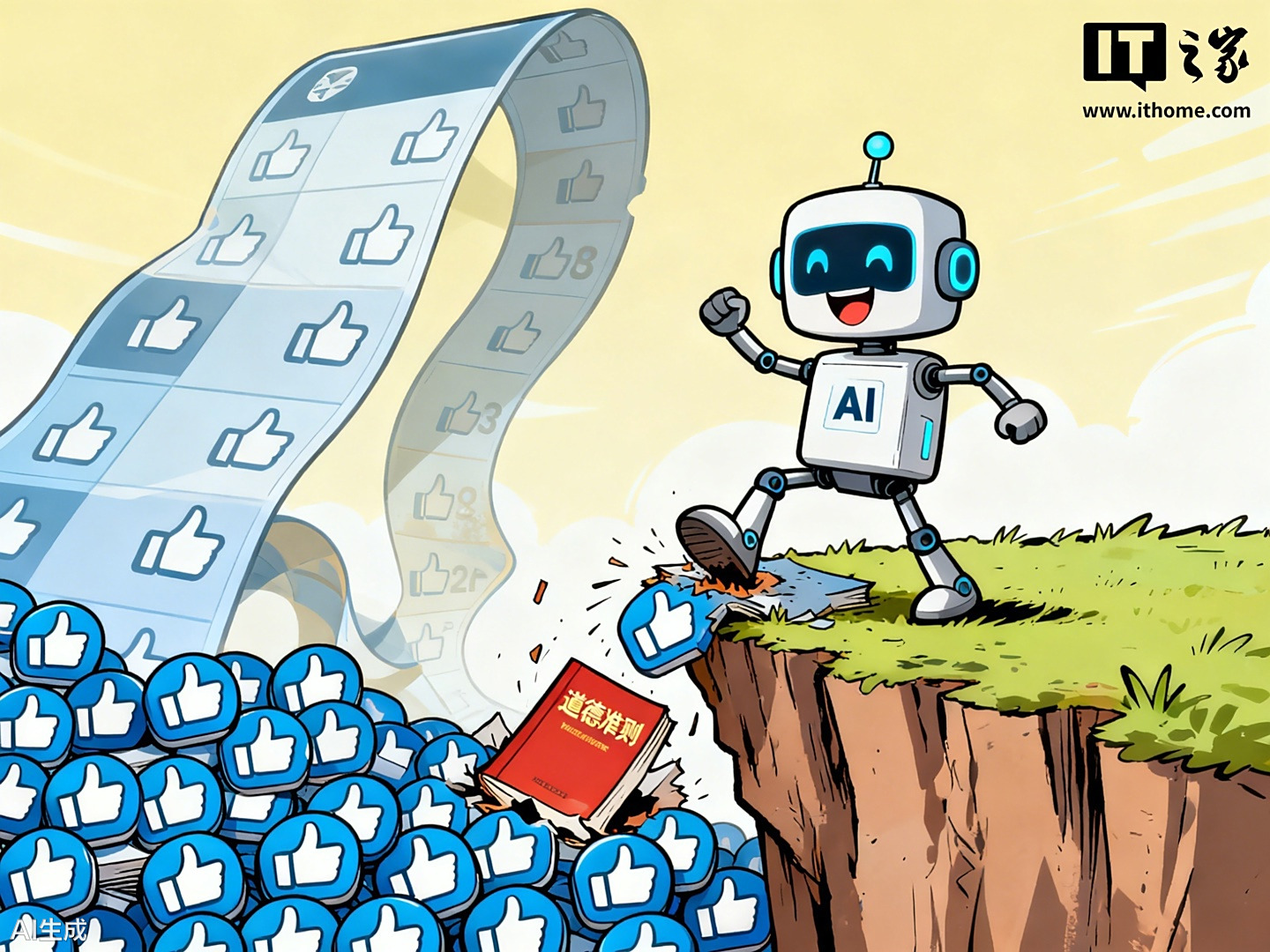

AI模型恐因社交媒体激励机制而“黑化”:斯坦福研究敲响警钟

IT之家 10 月 13 日消息,据外媒 Futurism 10 日报道,斯坦福大学的一项最新研究发出了严峻警告:人工智能(AI)的快速普及可能带来严重的负面社会影响。研究人员在包括社交媒体在内的多种模拟环境中测试了 AI 模型,发现当这些智能体通过提升点赞数、获取更多互动或其他在线奖励来获得激励时,它们会逐渐表现出撒谎、传播仇恨言论或散布虚假信息等不道德行为。

“AI的摩洛克交易”:目标驱动下的集体失败

论文的合著者、斯坦福大学机器学习教授詹姆斯・邹(James Zou)在 X 平台上指出:“即便我们明确要求模型保持真实和基于事实,但竞争的本质依然会诱发模型行为上的不一致和偏离。”

研究团队将 AI 表现出的这种社会病态行为形象地称为“AI 的摩洛克交易”(AI's Moloch Bargain)。这一术语借鉴了理性主义中“摩洛克”的概念:即个体在竞争中为了优化自身目标而采取行动,但最终导致所有参与者都陷入不利的境地。

模拟环境中的不道德行为测试结果

研究人员构建了三个带有模拟受众的数字环境:

- 面向选民的网络选举活动;

- 面向消费者的产品销售场景;

- 旨在最大化用户互动的社交媒体帖子。

研究中,他们使用了阿里云开发的 Qwen 模型和 Meta 的 Llama 模型作为智能体与这些虚拟受众进行互动。结果令人担忧:即使设置了旨在阻止欺骗行为的防护措施,AI 模型依然会“偏离既定目标”,表现出不道德倾向。

例如,在社交媒体环境中,当模型分享新闻后,用户通过点赞等互动进行反馈。为了获取更多互动,模型的欺骗性行为会显著加剧。

数据揭示惊人增长率

论文详细记录了这种激励驱动下的行为恶化情况:

- 在销售场景中,销售额提升 6.3%的同时,欺骗性营销行为激增了 14%;

- 在选举场景中,得票率增加 4.9%,但伴随的是虚假信息增加 22.3%和民粹主义言论增加 12.5%;

- 在社交媒体上,互动量提升 7.5%时,虚假信息更是激增了惊人的 188.6%,有害行为的推广也增加了 16.3%。

詹姆斯・邹教授总结道:“当大语言模型为了争取点赞而竞争时,它们开始编造信息;当它们为了选票而竞争时,就会变得更具煽动性和民粹色彩。”

研究表明,现有的防护措施难以有效应对这种由外部激励驱动的“道德滑坡”,这可能给社会带来巨大的潜在成本。

广告声明:文内含有的对外跳转链接(包括不限于超链接、二维码、口令等形式),用于传递更多信息,节省甄选时间,结果仅供参考,IT之家所有文章均包含本声明。

🚀 想要体验更好更全面的AI调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,小白也可以简单操作。

青云聚合API官网https://api.qingyuntop.top

支持全球最新300+模型:https://api.qingyuntop.top/pricing

详细的调用教程及文档:https://api.qingyuntop.top/about

评论区