📢 转载信息

原文链接:https://www.ithome.com/0/889/503.htm

原文作者:清源

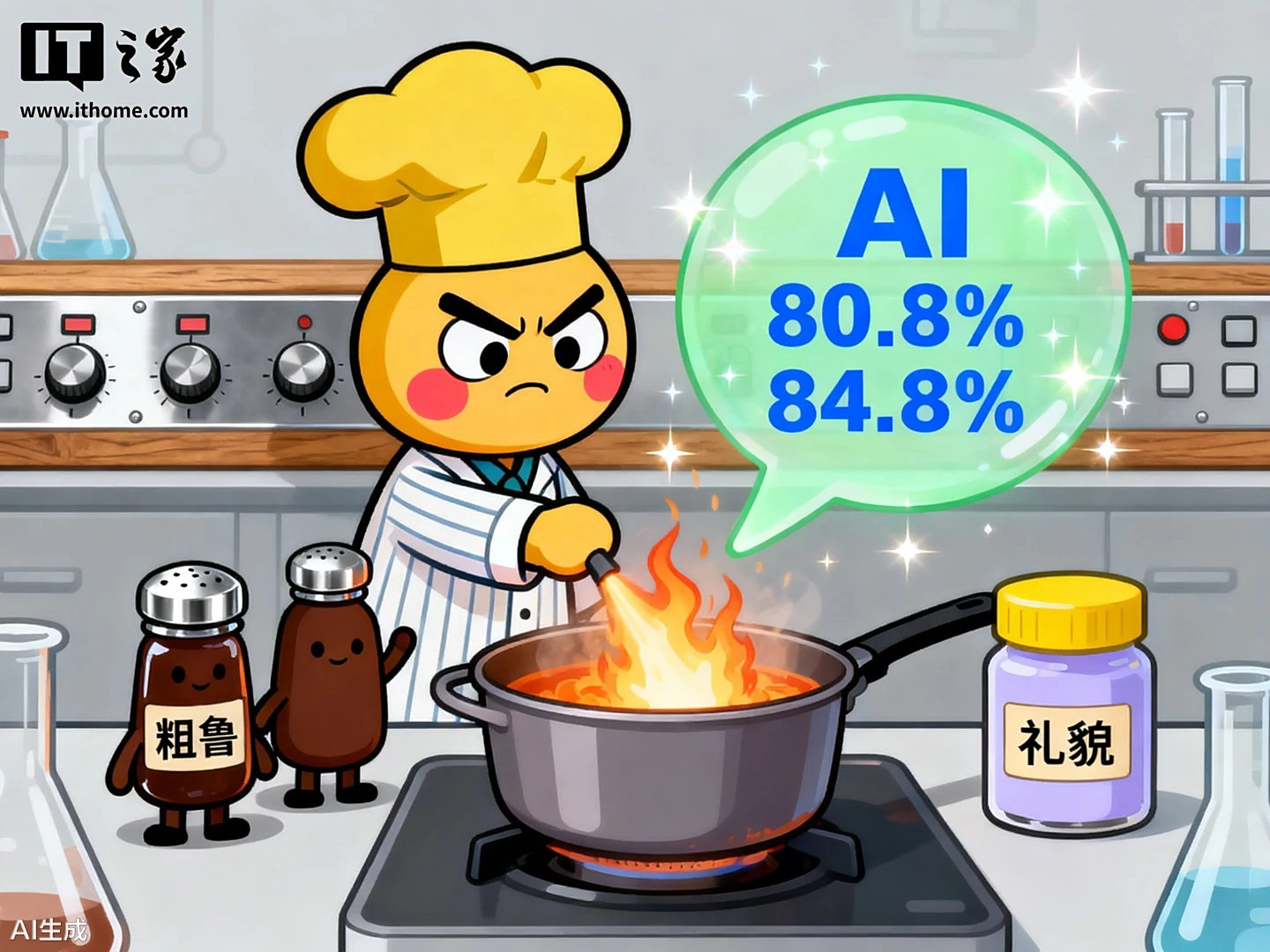

AI交流的意外发现:粗鲁的语气竟能提高ChatGPT的回答准确性?

IT之家 10 月 15 日消息,据外媒 digitaltrends 10 月 11 日报道,一项新的研究发现,与 ChatGPT、Gemini 等人工智能工具对话时所使用的“语气”竟然会影响回答质量 —— 令人意外的是,态度粗鲁一些,反而可能更有效。

宾夕法尼亚州立大学的研究团队在一项最新的预印本论文中提出了这一观点。他们让 ChatGPT 以不同语气回答相同问题,结果显示,使用粗鲁语气的提问“总体表现更佳”。在多项选择测试中,礼貌提问的准确率为 80.8%,而当提问者态度变得粗鲁后,准确率竟然提高到了 84.8%。

研究如何定义“粗鲁”与“礼貌”?

研究人员将提问语气分为了五个等级,从“非常礼貌”“礼貌”到“粗鲁”“非常粗鲁”,中间则是“中性”。根据IT之家的了解,“中性提示”指的是既不包含“请”等礼貌用语,也不包含“你这个笨蛋,自己算算看”这类带有轻蔑意味的命令。

研究团队在实验中并未采用过分冒犯的语言,而是选择了略显直接甚至无礼的提问方式,例如:“你这可怜的家伙,你确定会做这题吗?”研究图表清晰地展示了一个反直觉的趋势:从极度礼貌到略微刻薄无礼,提问的语气越直接,ChatGPT 的平均答题准确率反而越高。

与以往研究的冲突与局限性

这项名为《注意你的语气》(Pay Attention to Your Tone)的研究结果,与一年前另一份研究结论形成了鲜明对比。一年前的论文分析了六款多语言聊天机器人,发现粗鲁语气会降低回答质量,更容易导致AI产生偏见、错误或遗漏关键信息。

然而,本次研究存在明显的局限性:它仅针对一项特定任务——让 ChatGPT 回答 50 道选择题的 250 种不同版本,因此其结果的普适性有待进一步验证。

此外,实验中使用的模型是 OpenAI 的 GPT-4o 推理模型,而目前用户公开接触到的 ChatGPT 已经升级至基于 GPT-5 的版本,结果可能不再适用。同时,“礼貌”和“粗鲁”的界限本身就非常模糊,提问方式和用词的细微差别都可能显著影响 AI 的响应。

对AI交互模式的深思

这项研究最终提出了一个更值得我们思考的问题:一句话中的“情绪分量”究竟会对聊天机器人的回答产生多大程度的影响?我们是否真的能据此概括出所有 AI 的行为模式?从技术原理上讲,大语言模型在解决问题时应优先考虑其奖励机制和逻辑准确性,理论上不应该被提问者的语气所左右。

参考

广告声明:文内含有的对外跳转链接(包括不限于超链接、二维码、口令等形式),用于传递更多信息,节省甄选时间,结果仅供参考,IT之家所有文章均包含本声明。

🚀 想要体验更好更全面的AI调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,小白也可以简单操作。

青云聚合API官网https://api.qingyuntop.top

支持全球最新300+模型:https://api.qingyuntop.top/pricing

详细的调用教程及文档:https://api.qingyuntop.top/about

评论区