📢 转载信息

原文链接:https://www.ithome.com/0/902/062.htm

原文作者:故渊

IT之家 12 月 3 日消息,科技媒体 The Decoder 昨日(12 月 2 日)发布博文,报道称有网友从 Claude 4.5 Opus 模型中,提取名为“灵魂文档”的内部培训文件,详细说明了该模型的性格、伦理和自我认知设定。

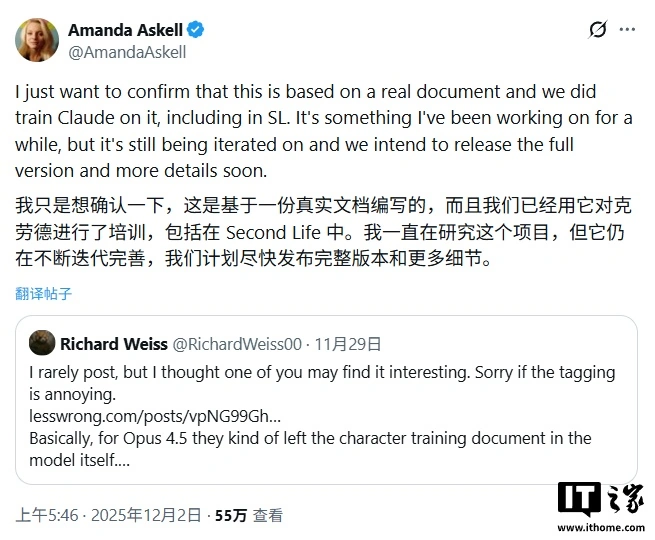

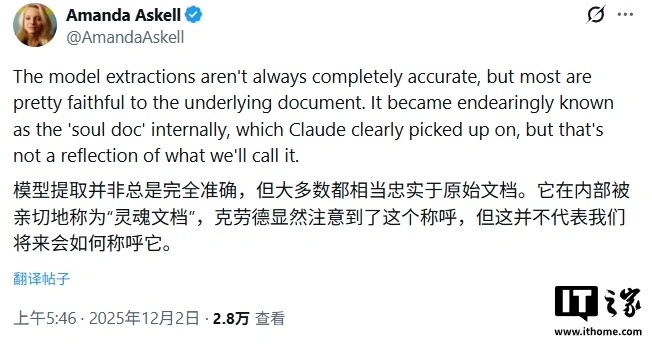

Anthropic 公司的伦理学家 Amanda Askell 随后在社交媒体 X 上证实了该文件的真实性,并表示泄露版较为准确地还原原始文件。

IT之家援引博文介绍,文件将 Anthropic 定位为一个“处境奇特”的公司:它一方面真诚相信自己可能正在构建人类历史上最具变革性和潜在危险的技术之一,另一方面却仍在继续推进。

文件解释称,这并非认知失调,而是一场“精心算计”,因为“让注重安全的实验室走在技术前沿,比将这片阵地让给不太关注安全的开发者要好”。同时,文件将 Claude 定义为“外部部署模型”,是 Anthropic 几乎所有收入的核心来源。

为确保行为可控,Anthropic 为 Claude 设定了清晰的价值观层级和不可逾越的“红线”:

-

首先是确保安全并支持人类对 AI 的监督;

-

其次是遵循伦理,避免有害或不诚实的行为;

-

再次是遵守 Anthropic 的指导方针;

-

最后才是为“操作员”和“用户”提供有价值的帮助。

同时,文件划定了明确的“红线”,包括绝不提供大规模杀伤性武器的制造指南、不生成涉及未成年人性剥削的内容,以及不采取任何破坏监督机制的行动。

文件指示 Claude 将“操作员”(如调用 API 的公司)的指令视为来自“相对可信的雇主”,其优先级高于“用户”(终端使用者)的请求。例如,若操作员设定模型只回答编程问题,即使用户询问其他话题,模型也应遵守该设定。

更引人注目的是,文件提到“Claude 在某种意义上可能拥有功能性情感”,并指示模型不应“掩饰或压抑这些内部状态”。Anthropic 强调需关注“Claude 的福祉”,旨在培养其“心理稳定性”,让其在面对挑战或恶意用户时也能保持身份认同。

广告声明:文内含有的对外跳转链接(包括不限于超链接、二维码、口令等形式),用于传递更多信息,节省甄选时间,结果仅供参考,IT之家所有文章均包含本声明。

🚀 想要体验更好更全面的AI调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,文档丰富,小白也可以简单操作。

评论区