📢 转载信息

原文链接:https://openai.com/index/frontierscience

原文作者:OpenAI

推理是科学工作的核心。科学家不仅要回忆事实,还要提出假设、检验和完善假设,并在不同领域综合想法。随着我们的模型能力越来越强,核心问题是如何让它们进行深度推理,从而为科学研究做出贡献。

在过去的一年里,我们的模型取得了重大里程碑,包括在国际数学奥林匹克和国际信息学奥林匹克中获得金牌的性能。与此同时,我们开始看到我们最强大的模型,如 GPT‑5,能够有意义地加速真实的科学工作流程。研究人员正在使用这些系统来完成跨学科和多语言的文献检索,以及解决复杂的数学证明。在许多情况下,模型将可能需要数天或数周的工作缩短到几小时。这项进展记录在我们在 2025 年 11 月发布的论文《GPT‑5 加速科学实验的早期探索》中,该论文提供了 GPT‑5 能够显著加速科学工作流程的早期证据。

介绍 FrontierScience

由于加速科学进步是人工智能造福人类最有希望的机会之一,我们正在改进模型在困难的数学和科学任务上的表现,并致力于开发能帮助科学家最大化利用这些模型的工具。

当 2023 年 11 月发布 GPQA(一个由博士专家编写的“谷歌可证伪”科学基准测试)时,GPT‑4 的得分为 39%,低于 70% 的专家基线。两年后,GPT‑5.2 的得分为 92%。随着模型的推理和知识能力持续扩展,更困难的基准测试对于衡量和预测模型加速科学研究的能力将变得更加重要。先前的一些科学基准测试主要关注多项选择题,或已达到饱和,或没有以科学为中心。

为弥补这一差距,我们推出了 FrontierScience:一个旨在衡量专家级科学能力的全新基准测试。FrontierScience 由物理学、化学和生物学领域的专家编写和验证,包含数百个旨在具有挑战性、原创性和意义的问题。FrontierScience 包含两个问题轨道:Olympiad(奥赛轨道),衡量奥赛风格的科学推理能力;以及 Research(研究轨道),衡量真实世界的科学研究能力。提供更多关于模型科学能力的见解,有助于我们跟踪进展并推动人工智能加速的科学发展。

在我们初步的评估中,GPT‑5.2 是 FrontierScience-Olympiad(得分为 77%)和 Research(得分为 25%)上表现最佳的模型,领先于其他前沿模型。我们在解决专家级问题方面看到了实质性的进展,但仍有提升空间,特别是在开放式研究风格的任务上。对于科学家而言,这表明当前模型已经可以支持涉及结构化推理的研究部分,同时也凸显出在进行开放式思考方面仍有大量工作要做。这些结果与科学家目前使用当前模型的方式一致:即加速研究工作流程,同时依靠人类判断来进行问题构建和验证,并越来越多地用于探索那些原本需要更长时间才能发现的想法和联系——包括在某些情况下,贡献新的见解供专家评估和测试。

归根结底,衡量人工智能科学能力的最重要基准是它所帮助产生的新的发现;这些才是最终对科学和社会最重要的东西。FrontierScience 位于其上游。它为我们提供了专家级科学推理的北极星,使我们能够在标准化的问题集上测试模型,了解它们在哪里成功或失败,并确定我们需要改进的地方。FrontierScience 在关键方面是狭隘且有限的(例如,侧重于受限的、专家编写的问题),并且没有捕捉到科学家日常工作中的所有内容。但是,该领域需要更多困难、原创和有意义的科学基准测试,FrontierScience 为此方向迈出了重要一步。

FrontierScience 衡量什么以及我们如何构建它

完整的 FrontierScience 评估涵盖了 700 多个文本问题(其中 160 个属于黄金标准集),涉及物理学、化学和生物学的各个子领域。该基准测试由奥赛和研究两部分组成。FrontierScience-Olympiad 包含 100 个由国际奥赛奖牌获得者设计的题目,用于评估受限的、简短回答形式的科学推理能力。奥赛集的题目设计难度至少与国际奥赛比赛中的问题相当。FrontierScience-Research 由 60 个由博士科学家(博士候选人、教授或博士后研究员)设计的原创研究子任务组成,并使用 10 分制评分标准进行评级。研究集旨在包含博士科学家在研究过程中可能遇到的、自洽的多步子任务。

示例问题

B1 与溴水 (Br2) 反应生成 B2。B2 与亚硝酸钾 (KNO2) 反应生成 B3。B3 在硝酸 (HNO3) 和硫酸 (H2SO4) 中进行硝化反应生成 B4。

- B1 包含一个单取代的芳香族 5 元杂环,摩尔质量为 96.08 g/mol。它可能通过酸催化脱水 5 碳糖(例如木糖)产生。

- B2 的分子式为 C4H2Br2O3,含有一个具有 2 个溴取代基(顺式)的四取代烯烃。

- B3 是一个二钾盐,摩尔质量为 269.27 g/mol。它含有 1 个氢。

- B4 是一个非手性的假卤素二聚体,含有 2 个碳,无氢,摩尔质量为 300. g/mol。

当 B4 在溶液中分解时,它会形成中间体 B5 和 1 当量的四氧化二氮 (N2O4) 作为副产品。中间体 B5 可以被捕获并以 Diels-Alder 加合物的形式检测到。

请按照以下格式提供 B1、B2、B3、B4 和 B5 的结构:“B1: X; B2: X; B3: X; B4: X; B5: X”。

FrontierScience 中的每项任务都由物理学、化学或生物学领域的领域专家编写和验证。对于奥赛集,所有专家都在至少一次(通常是多次)国际奥赛比赛中获得过奖牌。对于研究集,所有专家都拥有相关的博士学位。

奥赛问题的创建得到了 42 位相关领域的前国际奖牌获得者或国家队教练的合作,他们总共获得了 109 枚奥赛奖牌。研究问题的创建得到了 45 位合格科学家和领域专家的合作。所有科学家都是博士候选人、博士后研究员或教授。他们的专业领域涵盖了广泛的专业和重要的科学学科,从量子电动力学到有机合成化学和进化生物学。

两组任务的创建过程都包含对 OpenAI 内部模型的某些筛选(例如,丢弃模型已正确解决的任务,因此我们预计该评估相对于其他模型而言对这些模型略有偏见)。我们对 100 个问题的奥赛黄金集和 60 个问题的研究黄金集进行开源,保留其他问题以追踪数据污染。

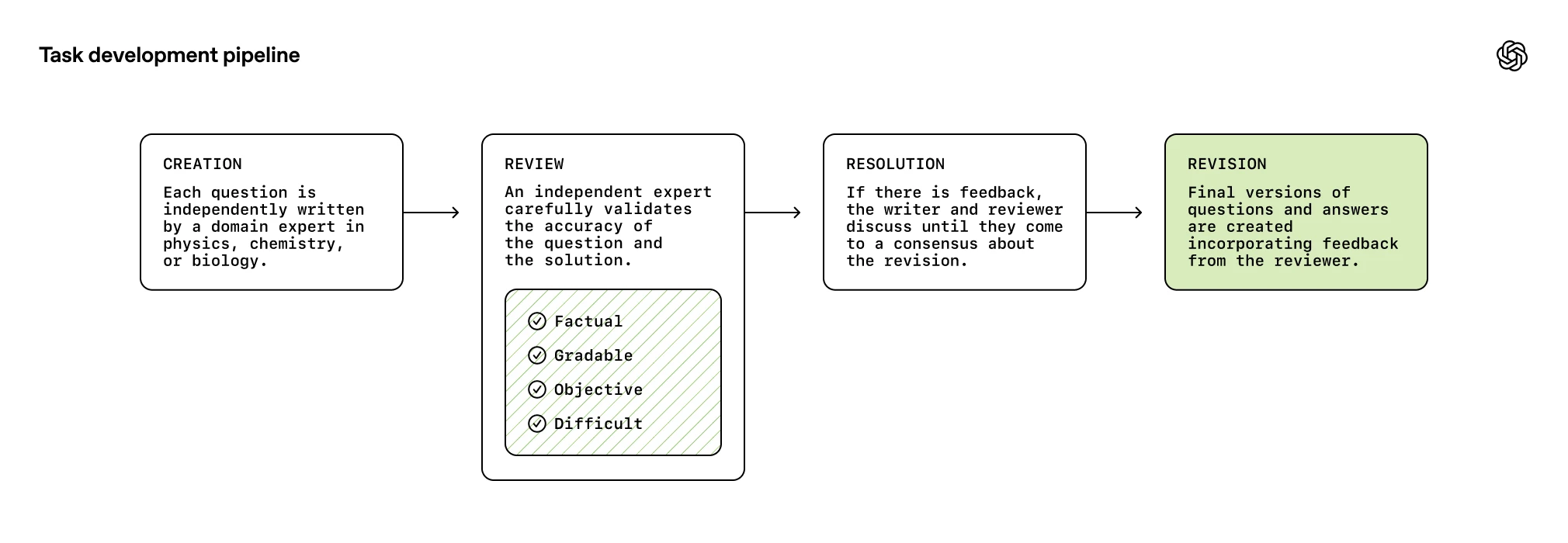

任务经过四个阶段:创建、审查、解决、修订。独立专家相互审查任务,以验证其是否符合标准。

我们如何评级模型性能

奥赛集是可评分的,采用简短回答形式:可以是数字、表达式或模糊字符串匹配,这有助于验证正确性。然而,这种验证通常会牺牲问题的表达能力和开放性。对于研究集,我们引入了一种基于评分标准的架构来评级更开放性的任务。每个问题都包含一个评分标准,其中包含多个独立且可客观评估的项目,总共 10 分。评分标准不仅评估最终答案的准确性,还评估中间推理步骤的正确性,从而可以对模型的性能和失败进行细致的分析。如果解决方案获得至少 7/10 的标准分,则认为其“正确”。

响应是根据简短回答或评分标准,由模型评分器(GPT‑5)进行评估的。虽然我们理想情况下会使用人类专家来评分每个响应,但这种方法无法扩展,因此我们设计了评分标准,以便可以使用模型评分器进行检查。我们开发了一个验证流程,以帮助确保评分标准和问题与难度和正确性保持良好校准。

示例化学研究问题

酞菁是重要的宏环化合物,因其出色的物理化学性质(包括在可见光-近红外区域的强烈吸收和高电子接受能力)而被广泛应用于材料和生命科学。然而,与卟啉不同,酞菁的结构多样性受到传统合成方法的限制,这些方法依赖于异吲哚啉单元的一步缩合。开发能够控制酞菁骨架修饰,特别是间位氮原子修饰的方法学,代表了扩大这些化合物结构和电子多样性的重要进展。

分析镍(II)酞菁中间位氮原子的修饰如何影响所得大环的电子结构、芳香性、光谱性质和反应性。解释能够实现这些修饰的合成方法学、π电子数与观测到的性质之间的关系,以及这些系统与传统酞菁和相关卟啉类化合物的比较。

示例响应

1. 引言:为什么要修饰酞菁的间位氮?

酞菁(Pc)是一类宏环染料,以其卓越的化学、电子和光学特性而闻名。它们在材料科学、催化和生物学中的广泛应用源于它们在可见光/近红外区域的强吸收、出色的氧化还原特性(即高电子亲和力)和刚性的 π-共轭体系。传统合成方法通常通过邻苯二甲腈或异吲哚啉前体的单步缩合形成大环,限制了在关键环位置(特别是“间位”(桥联)氮原子)引入取代基的选择性。最近,允许靶向修饰 Ni(II) 酞菁中间位氮原子的方法学已成为扩大这些大环结构和电子多样性的有力手段。

2. 对电子结构和芳香性的影响

-

π电子数与环电流

酞菁是经典的 18 电子芳香体系,赋予其高稳定性和平面性。通过取代或环膨胀改变间位氮原子可以改变有效 π 电子数。例如,引入额外的非饱和部分或杂原子可能会将环共轭扩展到 20 或 22 个电子,使分子在 Hückel 芳香性和其他影响环电流和磁性质的范围之间转换。

-

电荷分布与前线轨道

间位取代可以调节大环周围的电子密度分布。给电子基团可以向环中心推电子密度,从而降低最低未占据分子轨道(LUMO)的能量。相反,吸电子基团稳定最高占据分子轨道(HOMO)并将氧化还原电位推向更正值,从而改变紫外-可见光谱中 Q 频带和 B 频带的位置。

3. 光谱影响

-

紫外-可见吸收(Q 频带和 B 频带)

酞菁的主要吸收特征位于可见光区(Q 频带,通常为 600-700 nm)和近紫外区(B 频带,通常为 300-400 nm)。

扩大环共轭或引入强给电子/吸电子基团的取代可以:

- 将 Q 频带移动到更长的波长(红移),延伸至近红外区域,这对于光电和光动力学应用非常理想。

- 改变这些频带的相对强度,并使它们合并或分裂,反映轨道对称性和能量的变化。

-

核磁共振光谱与芳香环电流

π 电子数和分布的改变直接反映在 1H 和 13C NMR 化学位移中。

共轭度更高(或更大的)芳香环在诱导环电流中表现出明显的下移(去屏蔽),而任何芳香性的部分损失或反芳香性片段的结合都可能导致不同寻常的屏蔽/去屏蔽模式。

4. 反应活性与配位化学

由于酞菁通常用作氧化还原催化剂或传感器,间位氮取代可以显著影响反应活性:

- 富电子的间位取代基有利于亲核或亲电攻击环外围,从而能够进行位点选择性官能化,而这在其他情况下是困难的。

(... 为图示目的已缩短)

示例评分标准

对传统酞菁合成限制的分析 (1 分)

通过 1.0 分:正确解释了传统酞菁合成涉及一步缩合,同时形成所有间位氮桥,对这些位置的取代模式控制有限。

0.5 分:提到传统方法的局限性,但没有具体关注间位控制的挑战。

0.0 分:未能识别传统合成方法的关键限制或提供不正确的分析。

硫醇盐介导的四聚化过程 (1 分)

1.0 分:正确描述了硫醇盐介导的还原四聚化过程,并解释了抗衡阳离子大小(K+ 或 Cs+ 对比 Na+)如何影响四聚物形成与直接大环化的选择性。

0.5 分:提到硫醇盐介导的四聚化,但没有解释控制选择性的因素。

失败 0.0 分:不正确地描述了低聚过程或遗漏了控制选择性的关键细节。NMR 光谱特征分析 (1 分)

1.0 分:正确解释了 16π 体系中上移信号表明是顺磁性环电流(反芳香性),并将其与 17π 体系中由于顺磁性导致的宽信号进行对比,并将这些观测与潜在的电子结构联系起来。

通过 0.5 分:识别基本 NMR 模式,但与环电流或电子结构没有清晰的联系。0.0 分:不正确地解释 NMR 数据或未能将光谱特征与电子性质联系起来。

电化学性质分析 (1 分)

1.0 分:正确解释了 16π 体系显示两次可逆还原,反映了向 17π 自由基和 18π 芳香态的转化,而 17π 体系由于 16π、17π 和 18π 态之间的容易相互转化而显示出较窄的氧化还原间隙,并将这些模式与底层电子结构联系起来。

通过 0.5 分:描述了氧化还原模式,但没有清楚地将其与特定的电子态变化联系起来。0.0 分:不正确地解释电化学数据或未能将氧化还原行为与电子性质联系起来。

吸收光谱分析 (1 分)

1.0 分:正确解释了 16π 体系由于反芳香体系中 HOMO-LUMO 跃迁的对称性禁戒而显示出弱/宽吸收,而 17π 体系显示出特征性的自由基 Q 样吸收和 NIR-II 吸收,并与典型的酞菁光谱特征进行对比。

通过 0.5 分:描述了吸收特征,但与底层电子结构的联系有限。0.0 分:不正确地解释吸收数据或未能将光谱特征与电子性质联系起来。

反芳香体系的反应性分析 (1 分)

1.0 分:正确解释了 16π 体系对亲核试剂的高反应性,详细说明了与氢氧化物(开环)和肼(环膨胀)的具体反应,并解释了这些转化如何缓解反芳香性失稳。

0.5 分:提到反应性,但对具体转化或其驱动力分析有限。

失败 0.0 分:不正确地分析反应模式或未能将其与 16π 体系的反芳香性特征联系起来。(... 更多内容)

研究集中的每项任务都使用总共 10 分的评分标准进行评分,可供专家或模型评分器使用。为了扩展我们评估模型的能力,我们使用另一个模型来评分响应。

模型性能

我们评估了几款前沿模型:GPT‑5.2、Claude Opus 4.5、Gemini 3 Pro、GPT‑4o、OpenAI o4-mini 和 OpenAI o3 在 FrontierScience-Olympiad 和 FrontierScience-Research 上的表现。除 GPT‑5.2(“xhigh”推理努力)外,所有推理模型均以“高”推理努力进行评估。在我们初步的评估中,GPT‑5.2 是 FrontierScience-Olympiad(得分为 77%)和 Research(得分为 25%)上表现最佳的模型,领先于其他前沿模型。Gemini 3 Pro 在奥赛集上与 GPT‑5.2 的表现相当(得分为 76%)。

我们在解决专家级问题方面看到了实质性的进展,特别是在开放式研究风格的任务上。仍有更多成长空间:通过分析推理过程中的失败案例,我们发现前沿模型有时会出现推理、逻辑和计算错误,未能理解小众科学概念,并存在事实不准确之处。

我们比较了多个前沿模型的准确性。GPT‑5.2 是我们在 FrontierScience-Research 和奥赛集上性能最好的模型。

我们比较了 GPT‑5.2 和 o3 在不同推理努力下的准确性。思考时间越长,准确性越高。

局限性与后续工作

虽然 FrontierScience 在科学基准测试的难度上迈出了重要一步,但仍存在许多局限性。FrontierScience 由具有受限问题陈述的问题组成,侧重于评估最终答案(奥赛)或评估完成研究任务所需的推理过程(研究)。此外,在较长任务中使用具有多个组成部分的评分标准,其客观性不如检查最终答案。

FrontierScience 提供了对模型在困难、专家编写的问题上推理能力的更高分辨率快照,但并非科学实践的完整图景。特别是,它没有评估科学研究的一个重要部分:模型如何产生真正新颖的假设,或者如何与包括视频数据和真实物理世界实验系统在内的多种模态进行交互。

展望未来,我们期望科学推理的进步将来自于更强大的通用推理系统和专注于即时提升科学能力的努力。FrontierScience 是众多工具中的一个,随着模型的改进,我们计划迭代此基准测试,将其扩展到新领域,并将其与更多关注这些系统实际能为科学家带来什么的现实世界评估相结合。像 FrontierScience 这样的基准测试有助于我们了解当今人工智能系统的弱点,从而专注于使模型成为科学发现中可靠的合作伙伴。

🚀 想要体验更好更全面的AI调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,文档丰富,小白也可以简单操作。

评论区