📢 转载信息

原文作者:Surya Kari, Joseph Moulton, Joel Carlson, Mona Mona, Morteza Ziyadi, Pradeep Natarajan, Rajkumar Pujari, and Swastik Roy

在博文《使用Amazon Nova LLM作为裁判在Amazon SageMaker AI上评估生成式AI模型》中,我们介绍了Amazon Nova LLM-as-a-Judge功能。这是一个可通过Amazon SageMaker AI获取的专业评估模型,可用于系统地衡量生成式AI系统的相对性能。

SageMaker AI现提供由Amazon Nova驱动的、基于规则的大型语言模型(LLM)裁判。它不再对每个任务使用相同的通用规则,而是为每个单独的提示自动创建特定的评估标准。这有助于生成式AI开发者和机器学习(ML)工程师为其LLM和生成式AI产品自动生成精确的、特定场景的评估标准,而无需为每种用例手动设计规则集。

在本文中,我们将探讨Amazon Nova基于规则的裁判功能:什么是基于规则的裁判,裁判是如何训练的,应考虑哪些指标,以及如何校准裁判。我们还将分享Amazon Nova基于规则的LLM-as-a-Judge方法的Notebook代码,使用SageMaker训练作业来评估和比较两个不同LLM的输出。

Amazon Nova基于规则的裁判概述

基于规则的LLM裁判使用一个能力强大的LLM(特别是Amazon Nova)来充当其他AI模型或人工生成的响应的裁判。此功能提供了模型迭代之间的成对比较,因此您可以放心地做出关于模型改进的数据驱动决策。规则是用于评估性能的评分指南。传统上,为了评估AI模型,人类会手动编写适用于每个任务的一系列静态规则(静态规则集)。例如:“答案是否礼貌?”或“答案是否简短?” 这种方法的挑战在于,这些通用规则无法扩展到所有用户。创意写作提示需要与编码提示不同的评分标准,法律摘要也需要与一个通用清单不同的标准。Amazon Nova驱动的裁判为不同的交互创建自定义清单。用户向系统发送一个特定的提示(例如,“为患者总结这份医疗文件”)。裁判会分析该特定提示,并即时决定一个理想的答案应该是什么样的。它会自动编写如下标准:

- 它是否使用简单、非医学术语?

- 它是否准确地捕捉了诊断结果?

- 语气是否富有同情心?

然后,裁判会查看您的LLM模型生成的输出来对照它刚刚创建的这些特定标准进行评分。您将基于与该特定任务相关的规则(而非通用规则)获得一个质量分数。

示例输入

对于示例提示或输入“恐龙真的存在吗?”,我们有两个响应,如以下表格所示。

| 响应 A | 响应 B |

| 简单的回答是:是的,恐龙绝对存在过,但它们现在不存在了(除了它们的鸟类后代)。

以下是其含义的细分: 1. 恐龙是真实存在的 在超过1.5亿年的时间里,恐龙是地球上主要的陆地动物。我们知道它们存在,因为我们有大量的证据: 化石:我们在世界各地发现了数百万块恐龙化石——骨骼、牙齿、头骨和爪子。这些不是神话;它们是这些动物的实际保存下来的遗骸。 足迹:我们发现了无数的化石足迹,这些是泥土中留下的、后来变成石头的脚印。它们告诉我们恐龙是如何行走、奔跑和群居生活的。 蛋和巢穴:古生物学家发现了恐龙的化石蛋和巢穴,向我们展示了它们的繁殖方式。 甚至软组织:在一些极其罕见的情况下,科学家发现了恐龙羽毛、皮肤印记甚至蛋白质的化学痕迹的证据。 2. 但它们已经灭绝了(大多数) 大约在6600万年前,一颗巨大的小行星撞击了地球(就在现在的墨西哥湾)。这引发了一场灾难性事件,导致所有非鸟类恐龙——即除了会飞的恐龙之外的所有恐龙——灭绝。 3. 它们的后代就在我们身边:鸟类! 这是答案中最令人兴奋的部分!鸟类实际上是一种恐龙。 可以这样想:恐龙群体非常庞大。霸王龙(T. rex)、三角龙(Triceratops)和腕龙(Brachiosaurus)都是著名的成员。恐龙家谱的另一个分支是小型的、带羽毛的恐龙。其中一个带羽毛的恐龙群进化出了飞行的能力。它们是所有现代鸟类的直系祖先。因此,当您在街上看到鸽子或盘子上有一只鸡时,您看到的就是一只活着的恐龙。 总结:

|

恐龙确实存在过——但现在不存在了。恐龙是数百万年前生活在地球上的一大类爬行动物,主要是在中生代,大约从2.52亿年前持续到6600万年前。

化石证据——包括骨骼、足迹、蛋甚至皮肤印记——证实恐龙曾经漫步在地球上。科学家已经确定了数百种恐龙物种,从巨大的霸王龙和长颈的腕龙到像迅猛龙这样更小、更敏捷的掠食者。 大多数非鸟类恐龙在大约6600万年前灭绝,很可能是由于一次巨大的小行星撞击,再加上火山活动和气候变化。然而,有一类恐龙幸存了下来:现代鸟类的祖先。因此,从科学意义上讲,鸟类是活着的恐龙,使它们成为像霸王龙和三角龙这样的灭绝恐龙最近的现存亲属。 所以,虽然你今天不会看到一只剑龙在走动,但恐龙的遗产仍然存在——尤其是每当你看到麻雀或老鹰飞过时。   |

示例输出

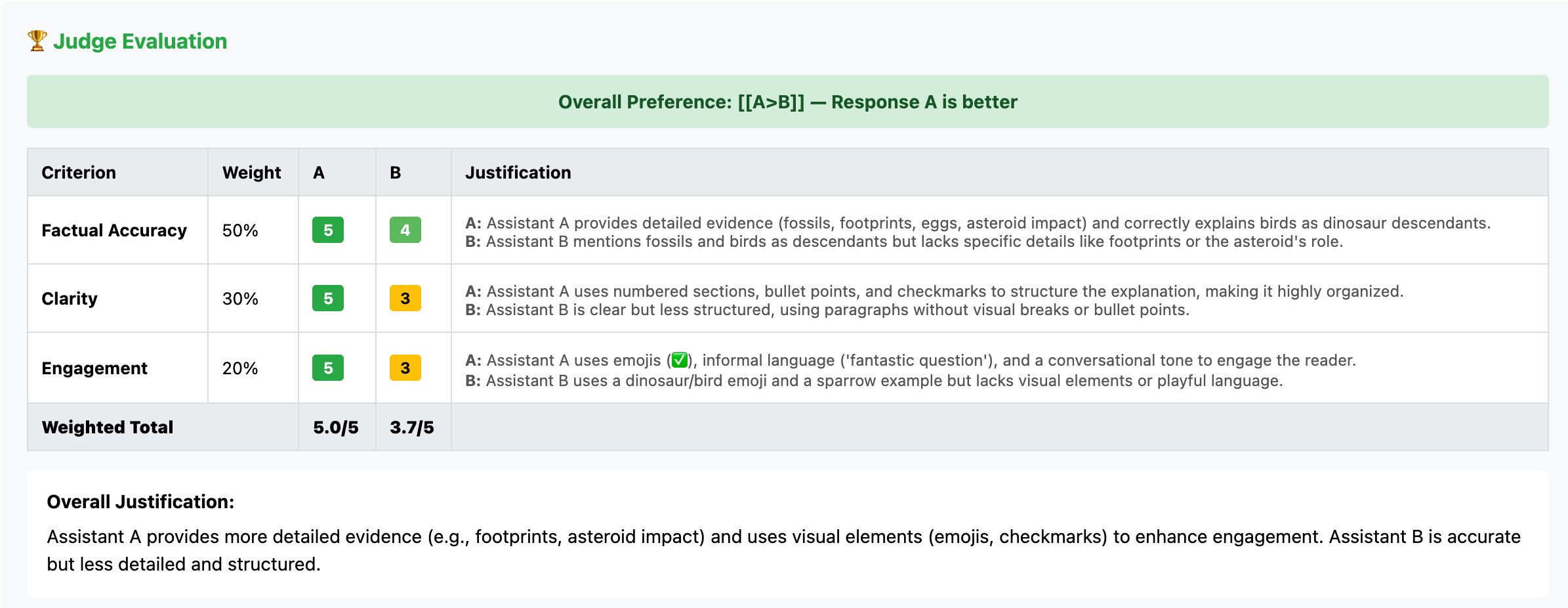

在两个响应中,基于规则的裁判更倾向于响应A,并且还提供了为什么更倾向于响应A而不是响应B的理由,如以下屏幕截图所示。

评估是针对用户提示的确切意图(编码与写作与总结)量身定制的。生成式AI开发者、数据科学家和ML工程师不必花费数百小时为每一种可能的情况手动编写评估规则。您可以即时评估数千种不同类型的提示,从而在各种用例中实现高质量。

企业实施示例

Amazon Nova基于规则的LLM裁判解决了不同场景中的关键评估挑战:

- 模型开发和检查点选择——开发团队将Amazon Nova基于规则的裁判评估集成到训练流程中,以自动评估检查点。按标准划分的评分揭示了迭代过程中哪些能力得到了加强或退化,从而能够对超参数调整和数据策展做出数据驱动的决策。

- 训练数据质量控制——团队使用Amazon Nova基于规则的裁判评估,通过对相关性标准生成点对点分数来过滤监督微调数据集,从而识别低质量示例。对于偏好数据集,计算出的响应对之间的差距使得课程学习(curriculum learning)策略能够过滤掉提供有限学习信号的压倒性的单方面示例。

- 自动化深度分析和根本原因分析——大规模部署生成式AI的组织可以使用Amazon Nova基于规则的裁判评估,对数千个模型输出来进行系统分析,而无需人工审查。当模型出现质量问题时,开发者可以检查哪些特定标准驱动了偏好判断,从而识别出需要针对性改进的系统性弱点,而不是进行广泛的重新训练工作。

动态规则生成的工作原理

Amazon Nova基于规则的LLM裁判的输入是一个三元组:<prompt, response_1, response_2>。裁判会比较给定提示下两个响应的质量,并输出一个偏好标签。除了总体标签外,裁判还会根据规则集生成一个决策理由。

规则集是一组用于评估两个响应的加权标准。基于规则的LLM裁判经过训练,可以生成权重之和为1的准则。规则集中的每个准则都有一个short_name(简称)、description(描述)和weight(权重)。裁判的决策包括对每个准则上两个响应的评分以及支持这些评分的详细理由。

Amazon Nova基于规则的LLM裁判采用了一种评估方法,即每次判断都由动态生成的、特定于提示的标准来支持。当裁判收到包含提示和候选响应的评估请求时,它会分析提示以理解上下文,并基于该上下文生成标准。这种动态生成过程确保了评估基于与手头任务直接相关的标准,从而提供了透明且可解释的评估。

对于每次评估,裁判都会生成结构化的YAML输出,其中包含生成的标准及其定义、每个标准的评分(1-5分制)以及解释每个分数的详细理由。最终输出包括四个偏好标签之一:[[A>B]]、[[B>A]]、[[A=B]]或[[A=B (bothbad)]。每个标准分数都附带一个理由,将评估建立在响应的可观察特征之上,从而能够对模型行为进行深入分析和调试。

将基于规则的Amazon Nova LLM-as-a-Judge与先前版本进行比较

基于规则的裁判与先前版本在评估结果的呈现方式和提供的信息方面有所不同。

先前版本的Amazon Nova LLM-as-a-Judge模型返回简单的偏好标签([[A>B]]或[[B>A]])。基于规则的版本会生成一个结构化的YAML输出,其中包含以下内容:

- 一个用于评估响应的特定于提示的规则集,组织为一组具有相关每准则重要性权重(权重总和为1)的标准

- 每个准则的简短自然语言描述

- 每个候选响应的李克特量表分数(1-5分制)或二元(真/假)决策

- 每个候选响应的每个准则分数的理由

- 总体偏好判断:A>B、B>A、A=B或A=B(两者都很差)中的一个

新的详细输出格式有助于实现广泛的细微差别用例。例如,规则中的特定准则允许对响应进行有针对性的比较。对于某些用例,简洁的响应可能更合适,而在其他用例中则需要全面的响应。理由和明确的准则评分有助于用户忽略不适合其需求的特定准则,并在不通过LLM裁判重新运行查询的情况下重新计算偏好判断。

指标解释

在我们的裁判评估过程中,我们使用几个重要指标作为排序裁判质量的比较点。前向一致性(Forward agreement)是一个指标,它计算与人类偏好的一致性,包括特定顺序中选择的响应和被拒绝的响应,这确保了正确标签始终是整个数据集的A>B或B>A之一。由于位置一致性是值得信赖的LLM裁判的一个重要期望属性,我们根据协调一致性(reconciled agreement)来评估我们的检查点——即,我们以两种可能的顺序向裁判呈现响应(进行两次响应偏好判断),以获得两个判断。只有当裁判在两个方向上都达成一致,并且该判断与人类偏好相匹配时,我们才认为裁判给出了正确答案。从定义上讲,这个数字将始终低于前向一致性。然而,由于现实世界的数据集不是排序的,它为LLM裁判模型的真实世界性能提供了更准确的替代指标。

加权分数(weighted_score_A 和 weighted_score_B)是添加到基于规则的裁判评估输出中的新指标,它们提供了对判断信心的视角。加权分数之间的巨大差异表明对一个响应相对于另一个响应的强烈偏好。这些分数是根据规则集中分配给每个准则的分数按样本计算的。每个准则分数被标准化到0-1范围(其中量表分数1-5映射到0.0-1.0,二元True/False映射到1.0/0.0),然后乘以该准则的权重并相加,以产生每个响应的加权分数。

分数差值(score_margin)显示了加权分数之间的差异,负值表示偏向响应B,正值表示偏向响应A。在最终的评估输出中,这些指标作为所有样本的平均值报告。每个样本的准则细分、单个分数和理由可以在详细的Parquet输出文件中找到。

对于每个比较样本,我们可以获得新规则裁判模型在比较两个结果时使用的具体标准,如下例代码所示:

================================================================================

Row 1:

Preference: ['B>A']

A wins: 0.0

B wins: 2.0

Weighted A: 0.225

Weighted B: 1.000

Margin: -0.775 Overall Justification:

Response B provides a comprehensive and detailed explanation of photosynthesis, covering the process, location, chemical equation, and importance. Response A only provides a brief, surface-level description without explaining the mechanism or significance. Criteria: completeness:

Score A: 2, Score B: 5

Weight: 0.5, Type: scale

Description: How thoroughly the response explains the photosynthesis process.

Justification A: Response A mentions the basic inputs and outputs but lacks detail on the mechanism, location in the cell, or the chemical equation.

Justification B: Response B provides a complete explanation including the process, chloroplasts, chemical equation, and the importance to life on Earth. clarity:

Score A: 3, Score B: 5

Weight: 0.3, Type: scale

Description: How clearly the response communicates the concept.

Justification A: Response A is clear but overly simplistic, lacking the detail needed for full understanding.

Justification B: Response B is well-structured and clearly explains each component of photosynthesis in an accessible way. accuracy:

Score A: 4, Score B: 5

Weight: 0.2, Type: scale

Description: How accurate the scientific information is.

Justification A: Response A is accurate in what it states but incomplete.

Justification B: Response B is fully accurate and includes the correct chemical equation and scientific terminology.

================================================================================这些加权指标是信息性的,并提供了关于评分细分的定量见解,但决定最终胜场数的实际偏好决策(A>B、B>A或A=B)基于裁判模型的总体偏好输出。

裁判的训练方法

Amazon Nova基于规则的裁判使用多方面奖励包进行训练。在我们的训练方法中,我们使用有效的奖励配方来优化LLM裁判的几个可取特征。我们主要针对以下标准:

- 偏好准确性——当裁判产生的决策与人类的黄金偏好一致时,会得到奖励。当它选择一个响应而不是另一个时,模型会得到奖励。

- 位置一致性——裁判的决策在特定候选响应顺序下被训练为对位置不一致问题具有弹性。

- 理由质量——裁判对决策的理由必须与生成的规则集、分数和最终判断保持一致。

- 分数校准——响应的加权分数必须与决策准确性保持校准(高信心的判断必须比低信心的判断更准确)。

我们从人类注释的偏好数据开始,采用自定义数据过滤和合成数据生成设置来获取与规则集对齐的偏好理由。我们从生成的合成规则集中采样,并开发了一个自定义流程,用于训练Amazon Nova基于规则的LLM裁判,使其能够熟练地生成具有精确粒度的适当标准,以实现一致且稳健的决策。

基准性能

在标准评估数据集上的测试显示出改进,特别是在需要细微判断的任务上,如以下表格所示。

| 基准 | 以前的Amazon Nova裁判 | 新的Amazon Nova基于规则的裁判 |

| PPE | 0.61 | 0.64 |

| RMBench | 0.66 | 0.88 |

| RewardBench | 0.88 | 0.9 |

| JudgeBench | 0.51 | 0.76 |

| CodeUltraFeedback | 0.69 | 0.72 |

| MMEval | 0.8 | 0.84 |

在JudgeBench和RMBench上较大的改进反映了对更复杂评估场景处理能力的提升。

校准

在我们的训练过程以及后处理过程中,我们评估Amazon Nova基于规则的裁判做出良好校准的决策的能力。为了实现平衡的校准,我们考察了人类注释偏好数据集上的信心桶。我们查看响应对的加权分数差异。我们的目标是让信心与准确性保持校准。理想情况下,当做出高信心决策时,LLM裁判应该更准确,而在做出低信心决策时,允许其准确性稍低。我们发现这种校准方法在分布内和分布外数据集上都能实现一致的决策制定。我们还查看了为不同标准生成的分数分布。我们寻求在整个评估数据集上出现近似正态分布的李克特量表分数(1-5)。这种双管齐下的校准检查过程有助于我们在多个性能相似的LLM裁判检查点中挑选出更好的一个。

基于规则的判断的使用案例

动态生成规则的可靠性源于三个决策:

- 裁判在代表现实世界用例的多样化、高质量的规则注释偏好数据上进行训练,使其学会区分有效的评估标准和肤浅的标准之间的模式。

- 我们在训练过程中采用的过滤机制会优先考虑那些展示出所需属性(全面性、互斥性、适当的特异性和任务相关性)的规则,确保模型从最好的示例中学习。

- 我们的奖励配方直接激励规则质量:那些导致准确、与位置无关的偏好以及良好校准信心的标准会获得正向奖励,而那些产生不一致判断的标准则会受到惩罚。

如何使用规则集来改进实际应用

许多现代应用在无参考(reference-free)环境中运行,其中不存在黄金标准的_人类答案_。在这种情况下,规则集的作用至关重要。在本节中,我们将重点介绍我们裁判生成的规则集可以用作知情决策的有用输入的实例。我们演示了我们的基于规则的裁判的输出——特别是加权标准、细粒度分数和明确的理由——如何作为关键的控制机制。

评估RAG系统

在检索增强生成(RAG)中,主要的失败模式是幻觉。传统的偏好裁判通常会将“响应是否良好?”与“它是否流畅?”、“格式是否正确?”、“内部逻辑是否合理?”等问题混为一谈。一个流畅但事实错误的响应通常比一个包含准确信息但结构混乱的响应更具可信度。为了选择一个总结模型,一个以事实性为重点的评估可以帮助您,因为检索结果不包含幻觉。使用基于规则的裁判进行此类判断可以帮助了解偏好判断是基于流畅性和格式等标准,还是基于忠实度、上下文相关性等相关标准。用户可以忽略不相关标准的得分,并根据其应用关心的标准子集重新评估判断。

创意评论家

在这个例子中,我们转向另一个方向,即创意和原创性比忠实于现实世界事实或先前上下文更受重视。考虑一个用例,您使用LLM生成短篇故事或剧本,但用户提供了一些过去的剧本示例以演示要求。要从这些生成中选择好的输出,需要生成的故事与示例有足够的区别,具有创意、原创性,并且不直接照搬现有的训练数据。最终用户可以在使用我们的基于规则的裁判时,针对原创性、连贯性和参与度等标准进行索引,以优化适合此用例的偏好判断。您还可以查看针对特定类型所需的原创性和创意评分的明确理由。

解决方案概述

此解决方案演示了如何使用基于规则的裁判功能在SageMaker AI上评估生成式AI模型。您也可以评估人工生成的响应,但在本解决方案中,我们展示了如何使用Amazon Nova作为基于规则的裁判来评估由Qwen等其他LLM生成的响应。

首先,我们通过从斯坦福问答数据集(SQuAD)中抽取问题并从Qwen2.5 1.5B Instruct和Qwen2.5 7B Instruct两个模型中生成候选响应来准备数据集。这两个模型都通过SageMaker托管的Hugging Face端点访问。来自两个模型的响应被保存在一个JSONL文件中(llm_judge.jsonl),其中包含提示、response_A(来自Qwen2.5 1.5B Instruct)和response_B(来自Qwen2.5 7B Instruct)。

接下来,将JSONL文件上传到Amazon Simple Storage Service (Amazon S3) 存储桶。然后,PyTorch Estimator启动一个评估作业,使用Amazon Nova基于规则的LLM-as-a-Judge配方。裁判模型动态生成针对每项任务量身定制的评估规则和标准,然后根据这些标准比较两个候选响应。该作业在像ml.g5.12xlarge这样的GPU实例上运行,并生成评估指标,包括按准则划分的得分、理由、比较评估、偏好计数和信心度量。结果被保存到Amazon S3中以供分析。

最后,一个可视化函数渲染图表和表格,总结了生成的规则集、跨评估维度的分数分布、两个Qwen2.5模型之间的比较性能,以及带有理由的详细示例。通过这种端到端的方法,您可以评估哪个模型表现更好,识别特定的优势和劣势,跟踪改进情况,并就部署生成模型做出数据驱动的决策——所有这些都无需人工注释。

先决条件

在运行Notebook之前,您必须完成以下先决条件:

- 对SageMaker AI进行以下配额增加请求。对于此用例,您必须在服务配额控制台(Service Quotas console)请求至少两个g5.12xlarge实例用于端点使用,以及至少一个g5.12xlarge实例用于训练作业使用。

- (可选)您可以创建一个Amazon SageMaker Studio域(参考使用Amazon SageMaker AI快速设置),以访问具有上述IAM的Jupyter Notebooks... [内容被截断]

🚀 想要体验更好更全面的AI调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,文档丰富,小白也可以简单操作。

评论区