📢 转载信息

原文链接:https://www.nature.com/articles/s41586-025-09716-2

原文作者:Alice Xiang, Jerone T. A. Andrews, Rebecca L. Bourke, William Thong, Julienne M. LaChance, Tiffany Georgievski, Apostolos Modas, Aida Rahmattalabbi, Yunhao Ba, Shruti Nagpal, Orestis Papakyriakopoulos, Dora Zhao, Jinru Xue, Victoria Matthews, Linxia Gong, Austin T. Hoag, Mircea Cimpoi, Swami Sankaranarayanan, Wiebke Hutiri, Morgan K. Scheuerman, Albert S. Abedi, Peter Stone, Peter R. Wurman, Hiroaki Kitano & Michael Spranger

摘要

计算机视觉是许多人工智能(AI)应用的核心,从自动驾驶汽车到消费设备。然而,这些技术创新的背后数据往往在收集时未能充分考虑伦理问题1,2,3。这导致了对缺乏多样性、固化偏见以及在未经数据权利人同意下收集的数据集的依赖。这些数据集损害了AI模型的公平性和准确性,并使用户权益受损4,5,6,7,8。尽管人们对计算机视觉技术中(尤其是人脸识别)的偏见问题已普遍关注9,但该领域仍缺乏可公开获取、经协商一致收集的数据集来评估大多数任务的偏见3,10,11。为此,我们推出了公平、以人为本的图像基准(FHIBE,发音为‘Feebee’),这是一个公开可用的人类图像数据集,它在同意、隐私、补偿、安全、多样性和实用性方面实施了最佳实践。FHIBE可负责任地用作许多以人为中心的计算机视觉任务的公平性评估数据集,包括姿态估计、人像分割、人脸检测与验证以及视觉问答。通过利用捕捉人口统计和身体属性、环境因素、仪器和像素级注释的综合注释,FHIBE可以识别各种各样的偏见。这些注释也支持更细致和粒度的偏见诊断,使从业者能够更好地理解偏见来源并减轻潜在的下游危害。因此,FHIBE代表了迈向可信赖AI的重要一步,提高了公平性基准的门槛,并为AI中负责任的数据策展提供了路线图。

主体

图像数据集在AI发展的历史上发挥了基础性作用,ImageNet12促成了2010年代初期深度学习方法的兴起13。尽管此后AI技术的能力和采用率取得了巨大进步,但数据和模型中的偏见仍然是一个持续存在的挑战2,14。数据评估不足可能导致公平性和鲁棒性问题,使得识别潜在危害变得具有挑战性1,10,15。这些危害包括固化种族主义、性别歧视和面相刻板印象2,4,以及排斥或错误代表整个群体3,5,16。因此,此类数据缺陷损害了AI模型的公平性和准确性。

未经同意大规模抓取网络图像2,6,17不仅加剧了数据偏见问题,还可能带来法律问题,尤其是在隐私7,18,19和知识产权(IP)20方面。因此,一些著名的Я数据集已被修改或撤回8。此外,缺乏对数据和注释的公平补偿,对AI开发供应链的伦理提出了关键担忧21,22。

政府机构(如NIST23)提供的数据集,或使用第三方许可图像的数据集24,往往存在缺乏知情同意和补偿的类似问题。许多数据集开发者错误地认为使用知识共享许可的图像就解决了相关的隐私问题3。只有少数基于同意的公平性数据集存在自我报告的标签25,26,27。然而,这些数据集的地域多样性很低。它们还缺乏像素级注释,这意味着它们只能用于少数以人为中心的计算机视觉任务3。

评估模型和减轻偏见是道德AI开发的关键。最近的方法,如PASS28、FairFaceVar29和MultiFair30,旨在通过对抗性训练和公平感知表示来减少人口统计信息泄露或强制执行公平性约束。以往的研究也表明,许多人脸识别模型和基准测试都编码了结构性偏见,突显了在开发每个阶段都需要公平性31。然而,这些方法仍然受到它们试图解决的数据集限制的制约,包括缺乏同意、人口统计自我报告和全球代表性。计算机视觉公平性文献中的大多数研究都依赖于重新利用非同意数据集,而这些数据集缺乏自我报告的人口统计信息。这种自我报告的人口统计信息缺失导致研究人员仅凭图像推断复杂的社会构建,例如图像主体的种族和性别。这些推断可能会固化刻板印象32,33,在不准确时对数据主体造成心理伤害34,35,并损害下游任务的有效性36。

负责任地策划的数据集匮乏给希望审计模型偏见的情境从业者带来了伦理困境。他们的选择是使用(1)带有法律或伦理风险的多样化和密集注释的公共数据集;(2)少数可公开获取的基于同意但限制极大的数据集之一(要求他们添加自己的像素级注释);(3)不向外部提供透明度的专有数据集;(4)因伦理问题被悄悄撤回但仍以衍生形式流传的数据集37;或者(5)什么都不做——即根本不检查偏见7,11,18。

为应对这些挑战,我们推出了FHIBE,这是一个公开可用、经协商一致收集、具有全球多样性的公平性评估数据集,适用于从人脸验证到视觉问答(VQA)的广泛视觉任务。FHIBE包含来自81个国家/地区的1,981个独立个体的10,318张图像38。现有的基于同意的公平性数据集25,26,27缺少来自具有严格法规的地区的数据,例如欧盟(EU),这使得FHIBE成为我们所知第一个包含来自欧盟经协商一致收集图像的公开可用的人类中心计算机视觉数据集。FHIBE拥有迄今为止最全面的关于人口统计和身体属性、环境条件、相机设置和像素级注释的注释。为了评估FHIBE的能力,我们使用它来评估广泛的狭义模型(针对特定任务设计)和基础模型(通用目的)在以人为中心的计算机视觉中的偏见。我们的分析涵盖了八项狭义模型任务(姿态估计、人像分割、行人检测、人脸检测、人脸解析、人脸验证、人脸重建和人脸超分辨率)以及基础模型的VQA。我们确认了先前记录的偏见,并表明FHIBE可以支持对导致此类偏见的因素进行更细致的诊断。我们还发现了先前未记录的偏见,包括模型对年龄较大个体的性能较低,以及基础模型中基于代词和祖先的强烈刻板联想。

大量的参与者参与了我们项目的数据收集、注释和质量保证(QA)流程(如补充信息C中所述)。为了收集尽可能具有全球多样性的数据集,我们与数据供应商合作,向众包图像主体收集数据。额外的注释也由众包和供应商雇用的注释员收集。我们为供应商提供了详尽的指南,并采取了额外的措施来确保QA、隐私保护、IP保护和同意撤销,以进一步保护数据收集过程中涉及人员的权利(方法)。通过创建FHIBE,我们不仅为研究人员提供了一个新的评估数据集,而且还展示了负责任的数据收集和策展在实践中的可能性和局限性。

FHIBE

概览

FHIBE包含1,981个独立个体的10,318张图像,平均每个主要主体有六张图像。我们采用了众包方法,与在全球运营的数据供应商合作收集数据集。我们制定了全面的数据收集指南,并实施了严格的质量评估协议,我们在方法中对此进行了详细讨论。

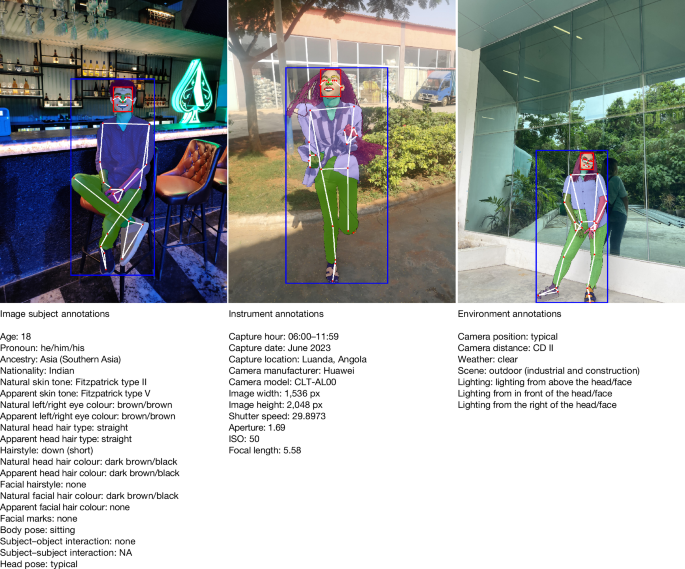

该数据集包括1,711个主要主体(提交自己图像的个体;补充信息C)和417个次要主体(与主要主体一起出现的个体,增加了图像的多样性和复杂性)。请注意,一些主要主体也是其他图像中的次要主体。总共有623张图像同时包含主要和次要主体。图像捕获时间跨度为2011年5月至2024年1月,涵盖5个地区和16个子区域的81个国家/地区38。为了增加图像的多样性(位置、服装、外观、环境条件等),我们允许参与者提交他们自己以前拍摄的图像。这些图像使用来自45个制造商的785种不同的相机型号拍摄,代表了广泛的现实世界条件,包括16种场景类型、6种光照条件、7种天气场景、3种相机位置和5种相机距离。图1提供了带有伴随的主体、仪器和环境元数据的示例图像。

出于可视化目的,我们在此图中展示每种图像的一种元数据类型。每项注释都与制作或检查该注释的注释员相关联。如果注释员披露了他们的人口统计属性(年龄、代词、祖先),则也提供该信息。补充信息A中提供了完整的注释列表。NA,不适用。

FHIBE还具有自我报告的姿态和交互注释,预定义标签分为16种身体姿势、2种头部姿势和47种不同的交互(14种与其他主体,33种与物体)。该数据集提供了丰富的外观特征,包括15种发型和4种面部毛发样式、7种发质、13种头发颜色和12种面部毛发颜色、9种眼睛颜色和11种面部标记类型。

还有6个代词类别、56个整数年龄(18至75岁)分为5个年龄类别、20个祖先子区域(分为5个区域)和6种 Fitzpatrick 皮肤色调39。通过年龄组、代词、祖先子区域和Fitzpatrick皮肤色调定义了1,234个交叉群体,每个群体的图像数量从1到1,129不等,中位数为9张图像。

FHIBE包含人脸和人体的像素级注释,包括边界框、33个关键点和28个分割类别(图2)。为每个注释提供了注释员标识符(一个区分每个注释员的匿名ID)。如果注释员自我披露了人口统计信息,也包含该信息以增加透明度。补充信息A中提供了完整的注释列表。FHIBE多样性的分布图显示在扩展数据图1和图2以及补充信息B和D中。对批注者间一致性的分析,显示了FHIBE注释的高质量和一致性,在方法和补充信息E中有所展示。

像素级注释包括关键点注释(红色小圆圈),指示人体和面部的几何结构(白线)(例如,右眼内侧、左脚脚趾);分割掩码将人体和面部分割成段,为每个像素分配一个标签(例如,左臂、珠宝);以及人脸和人体的边界框(分别为红色和蓝色矩形)。

此外,FHIBE包含两个衍生的人脸数据集:一个仅裁剪集,包含1,981个主体的10,941张图像,以及一个裁剪并对齐集,包含1,824个主体的8,370张图像。两个面部数据集都包含所有注释。

与现有数据集的比较

我们将FHIBE与扩展数据表1中用于公平性评估的27个以人为中心计算机视觉数据集进行了比较,考虑了它们的收集方法、注释和伦理维度。

大多数数据集是从互联网平台抓取或从抓取的数据集中派生的。七个著名的Я数据集已被其作者撤销,不再公开可用。他们撤回的原因通常没有明确说明,但表明了由于网络抓取用于AI开发的数据而带来的伦理挑战和担忧日益增加37。虽然许多数据集包含注释的边界框、关键点和分割掩码,但它们的像素级注释密度与FHIBE不相上下。具有密集像素级注释的数据集,如COCO40、VQA2.041和MIAP42,只包含有限的人口统计信息,其中没有一个是自我报告的。

只有四个数据集提到在获得数据主体同意后才收集数据。CCv226和芝加哥人脸数据库27是基于同意的数据集,但没有提供有关如何获得同意的进一步细节。虽然Dollar Street43提供了如何获得同意的详细信息,但其收集目的并未说明用于AI开发,也没有迹象表明主体同意处理其生物识别或其他个人信息。FHIBE是唯一一个在AI评估和偏见缓解方面获得稳健同意的数据集。

与其他人以同意为基础的数据集相比,FHIBE在诊断AI偏见方面也具有更高的实用性。CCv2和Dollar Street没有像素级注释。这使得它们不适合FHIBE所支持的各种计算机视觉任务评估。CCv2和芝加哥人脸数据库只包含面对相机的个体(主要是室内,只显示头部和肩部)的视频/图像。它们缺乏全身图像和多样的背景和姿势,限制了它们在许多计算机视觉任务(如姿态估计)中的效用,以及评估模型在个体可能不看摄像头时的部署环境中的表现。

此外,FHIBE在详细和自我报告的人口统计标签方面优于其他基于同意的数据集,这使得能够调查人口统计属性复杂交叉点上的模型性能(表1)。尽管CCv1的图像数量是FHIBE的4.4倍,CCv2的主体数量是FHIBE的2.8倍,但FHIBE的注释数量是其3.4倍,属性值数量是其16.9倍(表2)。FHIBE在许多计算机视觉数据集中代表性不足的地区,如非洲(44.7%)和中低收入经济体(71.5%)中也有更强的代表性(表3),使其非常适合偏见评估。

FHIBE设计的伦理考量

在开发FHIBE时,我们力求在文献中推荐的伦理数据收集最佳实践中进行实施2,3,44。我们特别关注同意、隐私保护、补偿、安全、多样性和实用性。下文讨论的设计决策也可为未来的负责任数据收集和策展工作提供起点,包括那些不侧重于公平性评估的工作。这些伦理考量的详细实施情况在方法中有详细描述。

同意

知情同意是涉及人类参与者的研究的核心,它能促进参与者的安全和保护,同时支持研究的完整性19,45。它要求参与者在决定参与之前,获得有关项目的潜在风险的充分信息。知情同意也是数据隐私保护的基础,如各种法律和法规中所编纂的7,18,19,46。

我们的同意流程旨在遵守像欧盟《通用数据保护条例》(GDPR)46这样全面的数据保护法律。这些流程包括制定包含清晰语言的同意书,说明收集数据的用途和披露、生物识别和敏感数据的处理,以及数据主体有关其数据的权利。融入数据隐私法的政策考量,如对人类尊严的尊重,也影响了我们数据收集的其他方面,包括我们收集的属性类型(例如,代词而非性别)、参与者招募指南(例如,无胁迫行为)以及对数据集下游使用的限制(例如,禁止用户尝试重新识别主体)。

为确保同意是自愿的46,数据主体保留对其个人信息的控制权,并可以随时从数据集中撤回其个人数据,而不会影响他们从项目中获得的补偿。在同意撤销的情况下,我们承诺通过替换被撤销的图像并在可能的情况下保持数据集的大小和多样性来维护数据集的完整性。这一承诺使FHIBE在计算机视觉领域中成为首创——一个旨在负责任地演变的“活数据集”。

隐私和IP

除了获得知情同意外,我们还采取了额外的措施从图像中删除偶然的个人信息。我们使用最先进的生成扩散模型47对未经同意的主体(例如,图像背景中的个体)和个人身份信息(例如,车牌、信用卡)进行in-painting(修复/填充)。然后,我们手动检查了每张图像,以验证个人信息已被删除,从而减轻了自动化方法中潜在的算法偏差48。这种方法避免了传统隐私措施的局限性,例如自动面部模糊49,因为传统措施仍可能通过独特的非面部特征(例如,纹身、胎记)实现重新识别50。我们进一步测试了我们的方法,以确保它不会损害数据用于模型评估的实用性。此外,我们对某些属性进行了简化处理,并仅以汇总形式发布其他属性。

为了确保图像许可的适当权利可授予下游用户,提交图像的参与者还必须审查并同意相关条款,确认他们拥有提供这些图像的权利,并了解其贡献的性质。此外,我们对数据供应商和参与者的指示包括要求最小化第三方IP(如商标和地标)的存在。我们还实施了自动化检查和人工验证,以检测并排除数据集中带有突出第三方IP(如徽标)的图像。

补偿

众包工人经常面临低工资和苛刻的工作条件21,22,而包含在网络抓取数据集中的个体则得不到任何补偿。为解决这些问题,我们要求数据供应商报告按地区划分的每项任务的最低付款率,并向众包工人参与者补偿...

评论区