📢 转载信息

原文作者:Iván Palomares Carrascosa

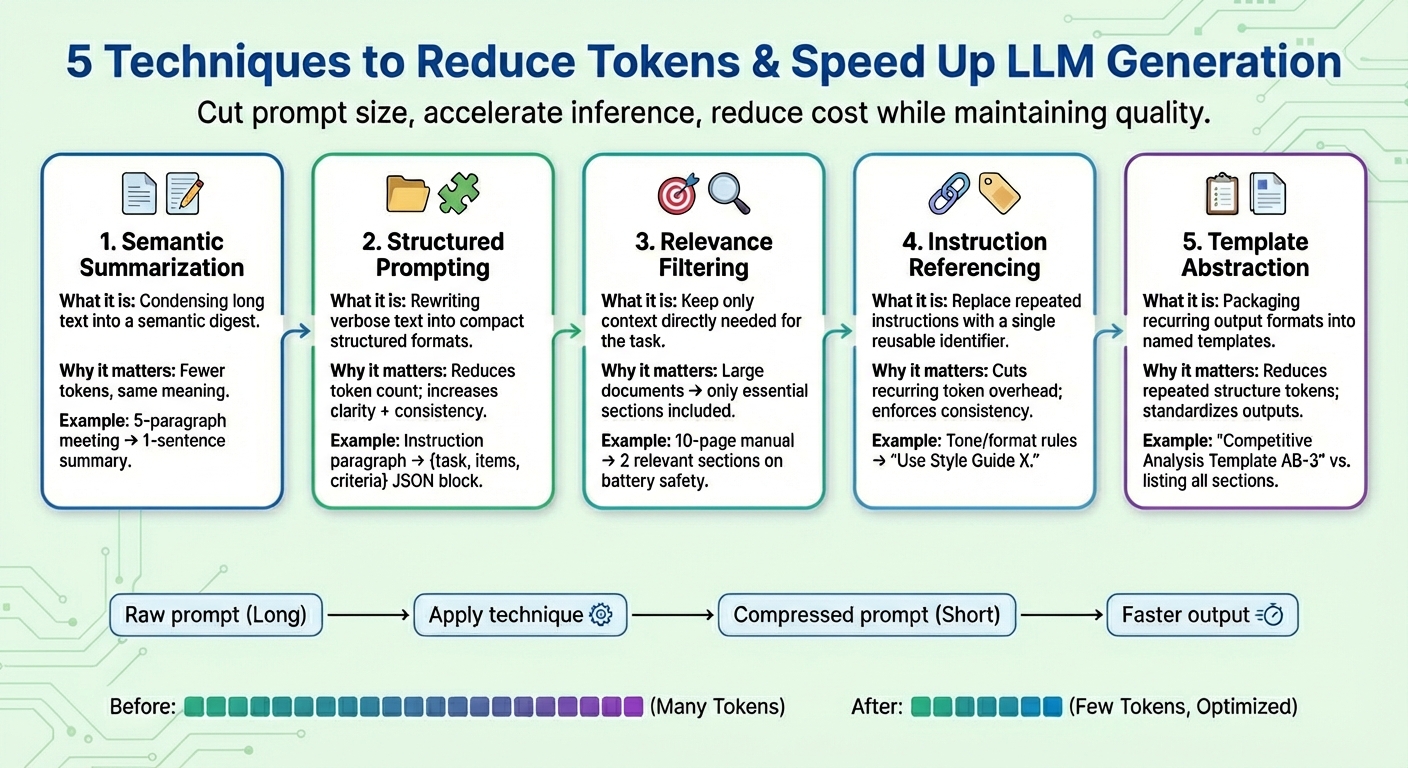

在本文中,您将学习五种实用的提示词压缩技术,这些技术可以在不牺牲任务质量的前提下,减少大型语言模型(LLM)生成的令牌数量并加速生成过程。

我们将涵盖的主题包括:

- 什么是语义摘要及其使用时机

- 结构化提示、相关性过滤和指令引用如何削减令牌数量

- 模板抽象的适用范围以及如何一致地应用它

让我们来探索这些技术。

提示词压缩助力LLM生成优化与成本削减

图片来源:编辑

引言

大型语言模型(LLM)主要被训练用于对用户的查询或提示词生成文本响应。其底层复杂的推理过程不仅涉及通过预测输出序列中的每个下一个令牌来进行语言生成,还涉及到对用户输入文本周围语言模式的深入理解。

由于用户提示词和上下文窗口的增大导致推理缓慢且耗时,提示词压缩技术最近在LLM领域受到了广泛关注。这些技术旨在帮助减少令牌使用量、加速令牌生成,并降低总体计算成本,同时尽可能保持任务结果的质量。

本文介绍并描述了五种常用的提示词压缩技术,用以在具有挑战性的场景中加速LLM的生成过程。

1. 语义摘要 (Semantic Summarization)

语义摘要是一种将冗长或重复的内容提炼成更简洁版本,同时保留其基本语义的技术。模型不再需要迭代地接收整个对话或文本文档,而是传递一个仅包含核心要点的摘要。其结果是,模型需要“阅读”的输入令牌数量减少了,从而加速了下一个令牌的生成过程,并在不丢失关键信息的情况下降低了成本。

假设一个很长的提示词上下文是会议纪要,例如“在昨天的会议中,Iván回顾了季度数据……”,共计五段。经过语义摘要后,缩短的上下文可能看起来像:“摘要:Iván回顾了季度数据,强调了第四季度销售额下降,并提出了成本节约措施。”

2. 结构化(JSON)提示 (Structured (JSON) Prompting)

此技术侧重于将冗长、流畅的文本信息以紧凑的半结构化格式(如JSON,即键值对)或项目列表的形式表达出来。结构化提示的目标格式通常会减少令牌数量。这有助于模型更可靠地解释用户指令,从而增强模型的一致性,减少歧义,同时也精简了提示词本身。

结构化提示算法可能会将包含指令的原始提示,例如“请详细比较X产品和Y产品,重点关注价格、产品特性和客户评分”,转换为结构化形式,例如:{task: “compare”, items: [“Product X”, “Product Y”], criteria: [“price”, “features”, “ratings”]}

3. 相关性过滤 (Relevance Filtering)

相关性过滤应用了“关注真正重要内容”的原则:它衡量文本各部分的相关性,并将仅与手头任务真正相关的上下文片段包含在最终提示词中。与其全部输入作为上下文的整个信息块(如文档),不如只保留与目标请求最相关的少量信息子集。这是大幅减少提示词大小、帮助模型在关注度和提高预测准确性方面表现更好的另一种方式(请记住,LLM的令牌生成本质上是重复多次的下一个词预测任务)。

举个例子,将一部关于手机的10页产品手册作为附件(提示词上下文)加入。应用相关性过滤后,只保留了关于“电池续航”和“充电过程”的几段简短相关内容,因为用户的提示是关于设备充电时的安全影响。

4. 指令引用 (Instruction Referencing)

许多提示词会反复出现相同的指令,例如“采用这种语调”、“以这种格式回复”或“使用简洁的句子”等等。指令引用为每条常见的指令(由一组令牌组成)创建一个引用,仅注册一次,并将其作为单个令牌标识符重复使用。未来任何提及该已注册的“常见请求”的提示词,都会使用该标识符。除了缩短提示词外,这种策略还有助于在一段时间内保持任务行为的一致性。

例如,一组组合指令“请使用友好的语调。避免使用行话。保持句子简短。提供示例。”可以简化为“使用风格指南X”,当再次指定等效指令时,即可重复使用。

5. 模板抽象 (Template Abstraction)

某些模式或指令经常出现在提示词中——例如报告结构、评估格式或分步程序。模板抽象应用了与指令引用类似的原则,但它侧重于生成的输出应该具有的形状和格式,将这些常见模式封装在一个模板名称下。然后使用模板引用,LLM负责填充其余信息。这不仅有助于保持提示词更清晰,还极大地减少了重复令牌的出现。

经过模板抽象后,提示词可能会被转换成类似“使用模板AB-3生成竞争性分析”的形式,其中AB-3是请求的分析内容部分的列表,每个部分都定义清晰。例如:

生成一份包含四个部分的竞争性分析:

- 市场概览(总结行业趋势的2-3段文字)

- 竞争对手细分(比较至少5个竞争对手的表格)

- 优缺点分析(项目符号列表)

- 战略建议(3个可操作的步骤)。

总结

本文介绍并描述了五种常用的方法,通过压缩用户提示词(通常侧重于上下文部分,这常常是导致LLM变慢的“提示词超载”的根本原因)来加速LLM在具有挑战性场景中的生成过程。

🚀 想要体验更好更全面的AI调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,文档丰富,小白也可以简单操作。

评论区