📢 转载信息

原文链接:https://www.kdnuggets.com/the-multimodal-ai-guide-vision-voice-text-and-beyond

原文作者:Vinod Chugani

图片来源:作者

# 引言

几十年来,人工智能(AI)主要意味着文本。你输入一个问题,得到一个文本回复。即使语言模型的能力越来越强,交互界面保持不变:一个等待你精心构建提示词的文本框。

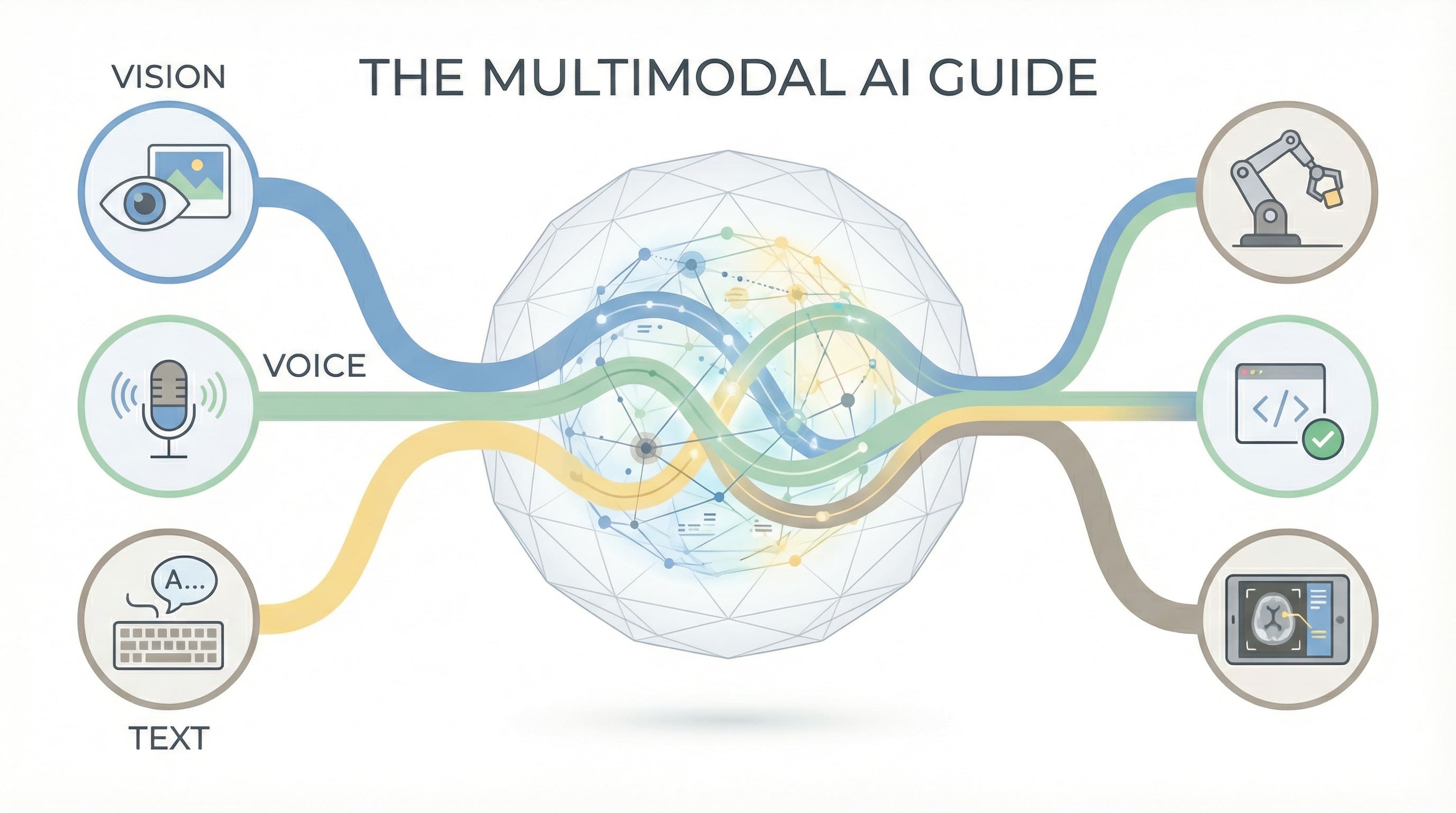

这种情况正在改变。如今,能力最强的AI系统不仅能阅读,它们还能看到图像、听到语音、处理视频,并理解结构化数据。这不仅仅是增量改进,而是我们与AI应用交互和构建方式的根本性转变。

欢迎来到多模态人工智能时代。

真正的意义不仅在于模型可以处理更多类型的数据。而在于整个工作流程正在融合。过去需要多个转换步骤的任务——图像到文本描述、语音到转录文本、图表到解释——现在可以直接完成。AI能够理解其原生形式的信息,从而消除了定义人机交互数十年的那种“翻译层”。

# 定义多模态人工智能:从单一感知到多重感知智能

多模态AI指的是能够同时处理和生成多种类型数据(模态)的系统。这不仅包括文本,还包括图像、音频、视频,以及日益增长的3D空间数据、结构化数据库和特定领域格式,如分子结构或音乐记谱法。

这次突破不仅仅是让模型变得更大。关键在于学会将不同类型的数据表示在一个共享的“理解空间”中,使它们能够相互作用。图像及其标题不再是碰巧相关的两个独立事物;它们是映射到共同表示的同一个底层概念的不同表达。

这创造了单模态系统无法实现的能力。纯文本AI可以在你用语言解释后描述一张照片。而多模态AI可以看到照片,并理解你从未提及的背景信息:光线、人脸上的表情、物体之间的空间关系。它不仅仅是处理多个输入;它跨它们综合理解。

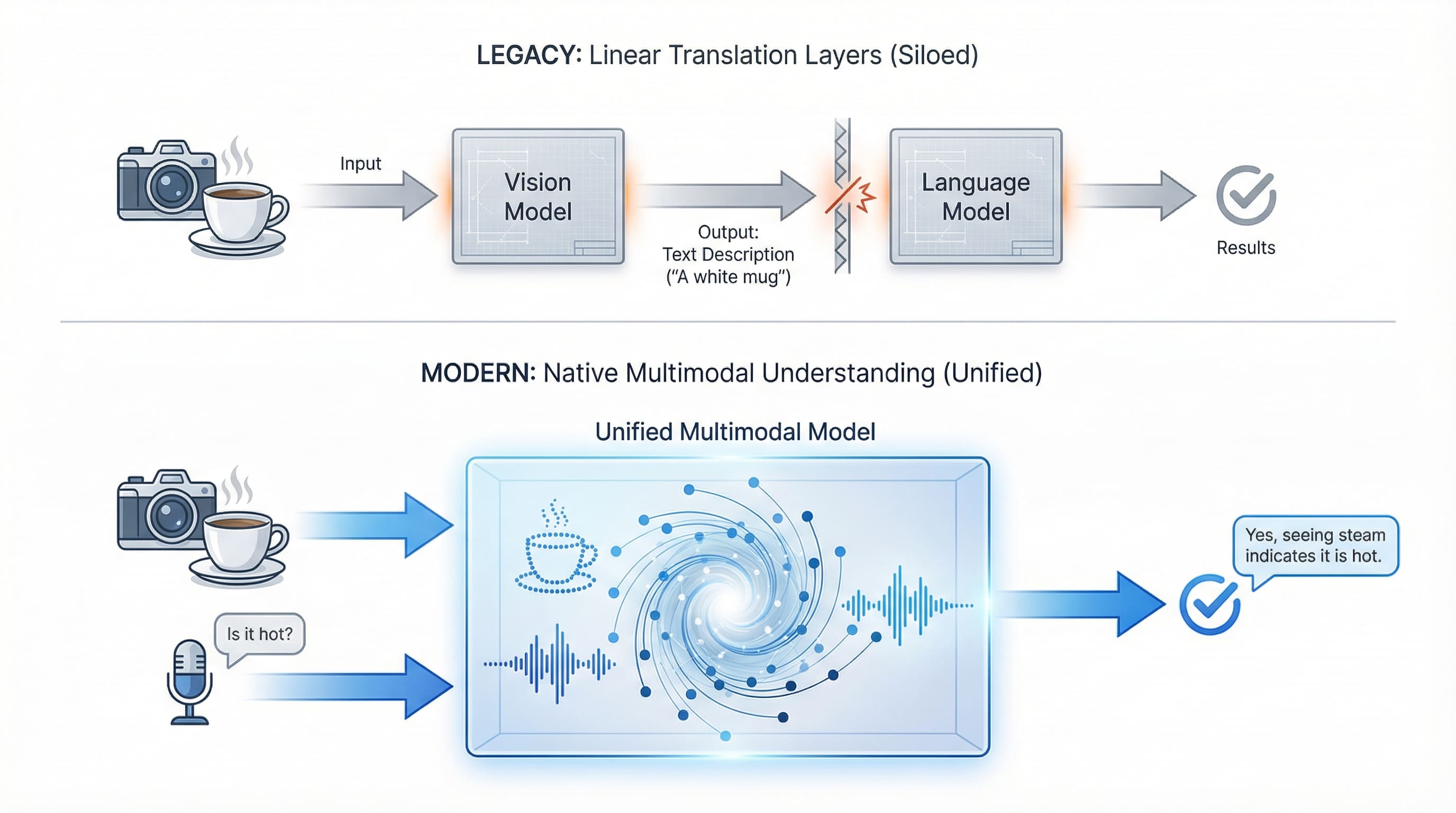

“真正多模态”模型与“多模态系统”之间的区别很重要。有些模型在一个统一的架构中处理所有内容。GPT-4 Vision (GPT-4V)能够同时“看”和“理解”。其他系统则连接专业化的模型:一个视觉模型分析图像,然后将结果传递给一个语言模型进行推理。这两种方法都有效。前者提供了更紧密的集成,而后者提供了更大的灵活性和专业化。

传统系统需要在专业模型之间进行转换,而现代多模态AI则在统一架构中同时处理视觉和语音。 | 图片来源:作者

# 理解基础三元组:视觉、语音和文本模型

有三种模态已经成熟到可以广泛投入生产使用,每种模态都为AI系统带来了独特的能力和独特的工程限制。

// 推进视觉理解

视觉AI已经从基本的图像分类发展到真正的视觉理解。GPT-4V和Claude能够分析图表、从截图中调试代码,并理解复杂的视觉上下文。Gemini在其整个界面中原生集成了视觉功能。开源替代品——LLaVA、Qwen-VL和CogVLM——在许多任务上现在可以与商业选项相媲美,同时在消费级硬件上运行。

在这里,工作流程的转变变得显而易见:不再需要用文字描述截图中的内容或手动转录图表数据,你只需展示即可。AI直接看到它。过去需要五分钟仔细描述的内容,现在只需五秒上传。

然而,工程实践带来了限制。通常你不能向大型语言模型 (LLM) 流式传输原始的 60fps 视频。这太慢也太昂贵了。生产系统使用帧采样,提取关键帧(可能每两秒一帧),或部署轻量级的“变化检测”模型,仅在视觉场景发生变化时才发送帧。

使视觉功能强大的不仅仅是识别物体。它还包括空间推理:理解杯子在桌子上,而不是漂浮着。它还包括读取隐含信息:识别杂乱的办公桌暗示着压力,或者图表的趋势与伴随的文本相矛盾。视觉AI在文档分析、视觉调试、图像生成以及任何“展示而非告知”适用的任务中表现出色。

// 演进的语音和音频交互

语音AI的意义超越了简单的转录。Whisper通过使高质量的语音识别免费和本地化而改变了该领域。它以惊人的可靠性处理口音、背景噪音和多语言音频。但现在的语音AI还包括通过ElevenLabs、Bark或Coqui实现的文本到语音 (TTS),以及情感检测和说话人识别。

语音消除了另一个转换瓶颈:你自然地说话,而不是打字说出你想表达的内容。AI会听到你的语气,捕捉你的犹豫,并回应你的意图,而不仅仅是你设法输入的文字。

前沿挑战不在于转录质量;而在于延迟和轮流应答。在实时对话中,等待三秒钟才能得到回应会让人感觉不自然。工程师通过语音活动检测 (VAD) 来解决这个问题,这是一种算法,它能精确检测到用户停止说话的毫秒,从而立即触发模型,并支持“打断”(barge-in)功能,允许用户在AI回复过程中插话。

转录和理解之间的区别很重要。Whisper能以令人印象深刻的准确性将语音转换为文本。然而,较新的语音模型能领会语气、检测讽刺意味、识别犹豫,并理解仅凭文本遗漏的上下文。一个带着沮丧说“还好”的顾客,与一个带着满意说“还好”的顾客是不同的。语音AI能捕捉到这种区别。

// 与文本集成进行综合

文本集成充当了粘合剂,将所有内容联系在一起。语言模型提供了其他模态所缺乏的推理、综合和生成能力。视觉模型可以识别图像中的物体;LLM则解释其意义。音频模型可以转录语音;LLM则可以从中提取见解。

能力来自于组合。向AI展示医疗扫描图像,同时描述症状,它就能跨模态综合理解。这超越了并行处理;这是一种真正的多重感知推理,其中每种模态都为其他模态的解释提供信息。

# 探索超越基础的新兴前沿

虽然视觉、语音和文本在当前应用中占据主导地位,但多模态格局正在迅速扩展。

3D和空间理解将AI从平面图像带入了物理空间。能够理解深度、三维关系和空间推理的模型,为机器人技术、增强现实 (AR)、虚拟现实 (VR) 应用和建筑工具奠定了基础。这些系统理解从不同角度看到的椅子是同一个物体。

作为一种模态的结构化数据,代表了一种微妙但重要的演变。新系统原生理解表格、数据库和图形,而不是将电子表格转换为文本供LLM使用。它们认识到某一列代表一个类别,表之间的关系带有含义,时间序列数据具有时间模式。这使得AI可以直接查询数据库、在不提示的情况下分析财务报表以及推理结构化信息而不会有损地转换为文本。

当AI理解原生格式时,全新的能力就会出现。金融分析师可以指向一个电子表格,询问“第三季度收入为何下降?”AI读取表格结构,发现异常,并给出解释。建筑师可以输入3D模型并获得空间反馈,而无需先将所有内容转换为2D图纸。

特定领域模态针对专业领域。AlphaFold理解蛋白质结构的能力为AI开启了药物发现之门。能够理解音乐记谱法的模型为作曲工具提供了支持。处理传感器数据和时间序列信息的系统,将AI带入了物联网 (IoT) 和工业监控领域。

# 实施实际应用

多模态AI已经从研究论文走向解决实际问题的生产系统。

- 内容分析:视频平台使用视觉来检测场景,使用音频来转录对话,使用文本模型来总结内容。医学影像系统将视觉分析与患者病史和症状描述结合起来辅助诊断。

- 辅助功能工具:实时手语翻译结合了视觉(观察手势)和语言模型(生成文本或语音)。图像描述服务帮助视障用户理解视觉内容。

- 创意工作流程:设计师勾勒出AI可以转换为代码并口头解释设计决策的界面。内容创作者在语音中描述概念,同时AI生成匹配的视觉效果。

- 开发者工具:调试助手可以查看你的屏幕、读取错误信息并口头解释解决方案。代码审查工具分析代码结构以及相关的图表或文档。

这种转变体现在人们的工作方式上:人们不再需要在工具之间切换上下文,只需“展示并提问”。摩擦消失了。多模态方法允许每种信息类型都保留其原生形式。

生产中的挑战往往不是能力问题,而是延迟问题。语音到语音系统必须在不到 500 毫秒内完成音频 → 文本 → 推理 → 文本 → 音频的处理过程,才能感觉自然,这需要处理数据块的流式架构。

# 驾驭新兴的多模态基础设施

围绕多模态开发形成了一个新的基础设施层:

- 模型提供商:OpenAI、Anthropic 和 Google 在商业产品中处于领先地位。像 LLaVA 系列和 Qwen-VL 这样的开源项目实现了访问的民主化。

- 框架支持:LangChain 增加了多模态链,用于处理混合媒体工作流程。LlamaIndex 将检索增强生成 (RAG) 模式扩展到了图像和音频。

- 专业提供商:ElevenLabs 在语音合成方面占据主导地位,而Midjourney 和Stability AI 在图像生成方面处于领先地位。

- 集成协议:Model Context Protocol (MCP) 正在标准化 AI 系统连接到多模态数据源的方式。

基础设施正在实现多模态AI的民主化。过去需要研究团队数年才能实现的功能,现在可以在框架代码中运行。过去需要数千美元API费用的功能,现在可以在消费级硬件上本地运行。

# 总结关键要点

多模态AI所代表的不仅仅是技术能力;它正在改变人类和计算机的交互方式。图形用户界面 (GUI) 正在被多模态界面所取代,在这些界面中,你可以自然地展示、讲述、绘制和说话。

这催生了新的交互模式,例如视觉接地(visual grounding)。用户不再输入“角落里那个红色的物体是什么?”,而是直接在屏幕上画一个圈并询问“这是什么?”AI同时接收图像坐标和文本,将语言锚定在视觉像素上。

AI的未来不是在视觉、语音或文本之间做出选择。而是构建像人类一样自然理解所有这些模态的系统。

Vinod Chugani 是一位AI和数据科学教育家,致力于弥合新兴AI技术与在职专业人员的实际应用之间的鸿沟。他的重点领域包括智能体AI、机器学习应用和自动化工作流程。通过作为技术导师和讲师的工作,Vinod 支持数据专业人员进行技能发展和职业转型。他将量化金融领域的分析专业知识带入他的实践教学方法中。他的内容强调专业人士可以立即应用的、可操作的策略和框架。

🚀 想要体验更好更全面的AI调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,文档丰富,小白也可以简单操作。

评论区