📢 转载信息

原文链接:https://www.ithome.com/0/888/467.htm

原文作者:故渊

AI“以小博大”新标杆:三星开源700万参数TRM模型,特定任务性能媲美万倍大模型

IT之家 10 月 10 日消息,科技媒体 venturebeat 于 10 月 8 日报道称,三星高级 AI 研究院发布了名为微型递归模型(TRM)的开源 AI 模型。这款模型参数量仅为 700 万,但在数独、迷宫等特定的结构化推理任务上,表现竟能媲美甚至超越参数量大其 10000 倍的谷歌 Gemini 2.5 Pro 等顶尖大模型。

该 AI 模型由三星高级 AI 研究院(SAIT)高级 AI 研究员 Alexia Jolicoeur-Martineau 发布,是 AI 领域“小模型”对抗“大模型”趋势中的一个重要里程碑案例。

“递归推理”:小模型实现深层计算

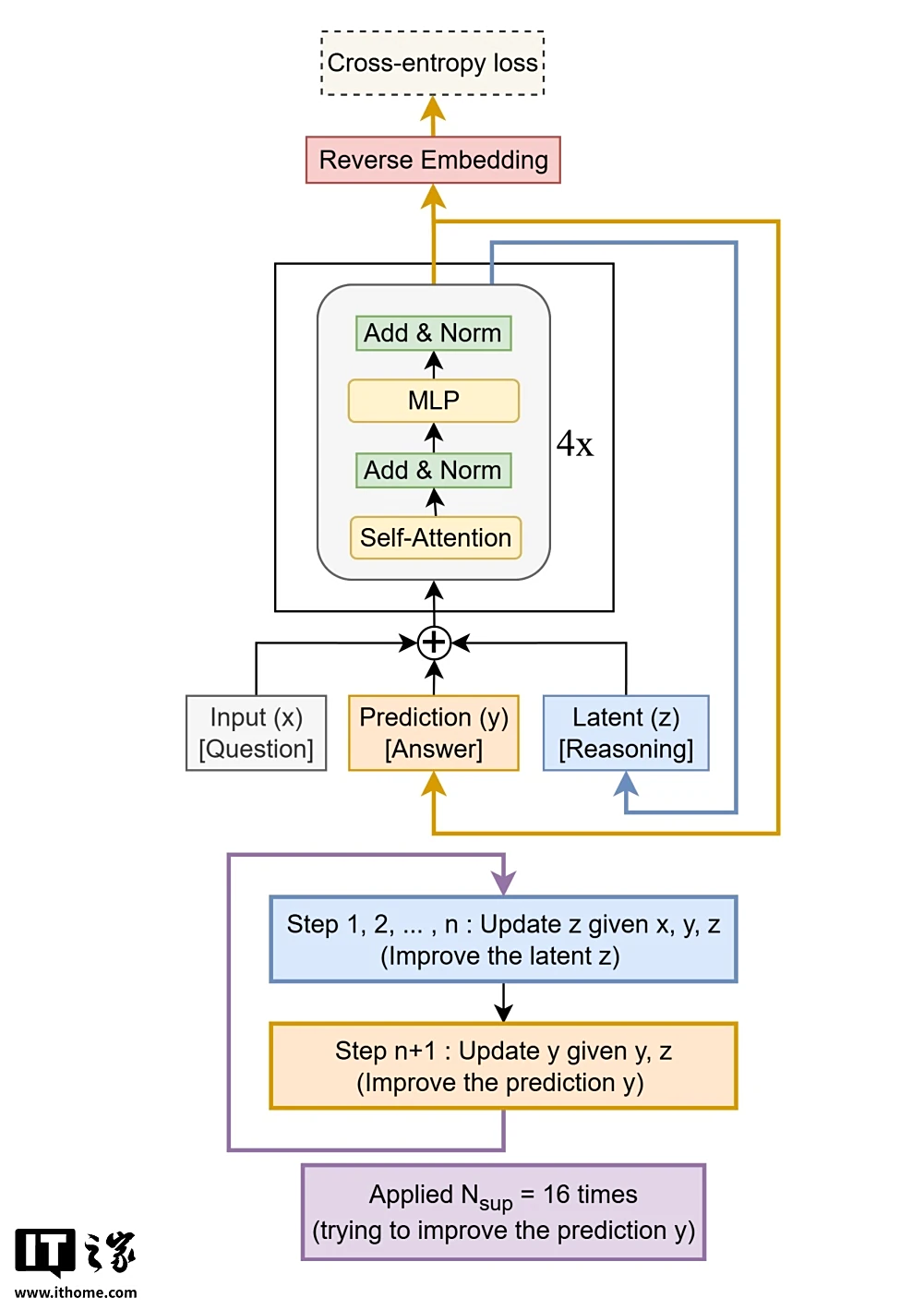

TRM 模型仅有 700 万参数,其设计理念是追求极致的简化。在模型架构上,它放弃了分层推理模型(HRM)依赖的双网络协作,转而采用一个仅有两层的单一模型。

其核心创新在于“递归推理”机制:模型对自身的输出预测进行反复迭代和修正,每一步都在纠正前一步的潜在错误,直到最终答案收敛稳定。

通过这种方式,TRM 用迭代计算的深度模拟了庞大网络的复杂推理过程,实现了“以递归替代规模”的目标,从而在不牺牲性能的前提下,大幅降低了计算和内存成本。

惊人的“以小博大”性能表现

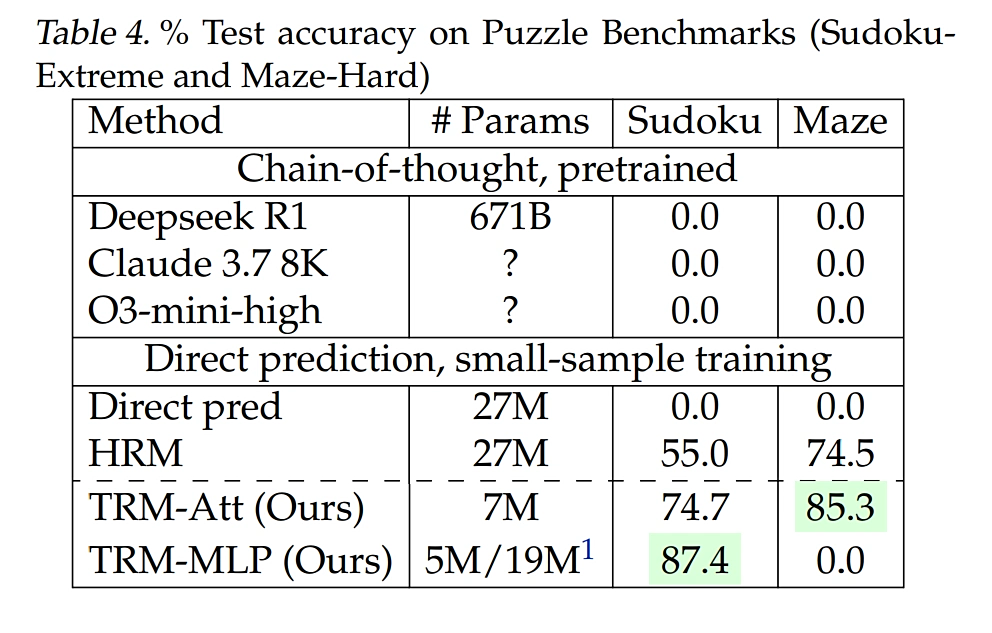

尽管模型极小,TRM 在多个基准测试中展现了“以小博大”的惊人实力:

- 在 Sudoku-Extreme(极限数独)测试中,其准确率达到 87.4%;

- 在 Maze-Hard(困难迷宫)中达到 85%;

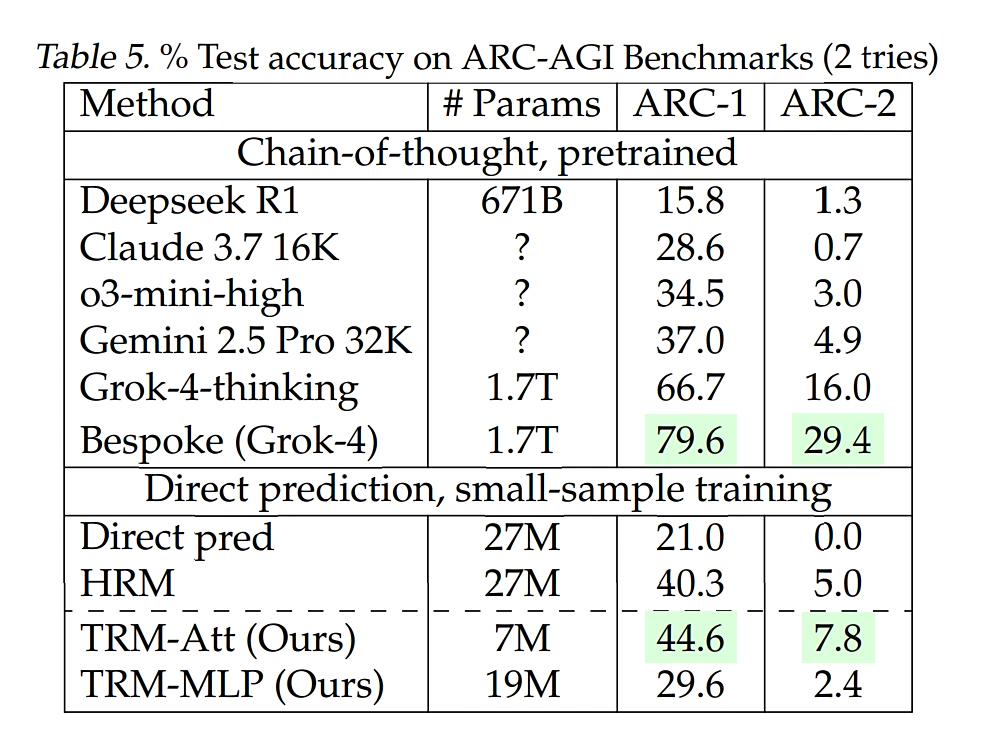

- 在衡量抽象推理能力的 ARC-AGI 测试中准确率为 45%;

- ARC-AGI-2 的准确率为 8%。

值得注意的是,尽管 TRM 使用的参数不到万分之一,但这些结果依然超过或接近 DeepSeek R1、Gemini 2.5 Pro 和 o3-mini 等几种高端大型语言模型的性能。

应用场景与开源情况

需要明确的是,TRM 是专门为解决结构化、可视化的网格类问题(如数独、迷宫和特定解谜任务)而设计的,它擅长在有明确规则的封闭环境中进行逻辑推理,并非通用的语言聊天模型,不擅长开放式的语言生成。

TRM 的成功源于其刻意追求的“少即是多”极简主义设计。研究发现,增加模型层数或大小反而会导致在小数据集上出现过拟合,性能下降。其精简的双层结构与递归深度相结合,实现了最佳效果。

TRM 的代码、训练脚本和数据集目前已在 GitHub 上根据 MIT 许可证完全开源,企业和研究人员均可免费使用、修改和部署,甚至用于商业应用。

IT之家附上参考地址

广告声明:文内含有的对外跳转链接(包括不限于超链接、二维码、口令等形式),用于传递更多信息,节省甄选时间,结果仅供参考,IT之家所有文章均包含本声明。

🚀 想要体验更好更全面的AI调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,小白也可以简单操作。

青云聚合API官网https://api.qingyuntop.top

支持全球最新300+模型:https://api.qingyuntop.top/pricing

详细的调用教程及文档:https://api.qingyuntop.top/about

评论区