📢 转载信息

原文链接:https://www.nature.com/articles/s41586-025-10072-4

原文作者:Akari Asai, Jacqueline He, Rulin Shao, Weijia Shi, Amanpreet Singh, Joseph Chee Chang, Kyle Lo, Luca Soldaini, Sergey Feldman, Mike D’Arcy, David Wadden, Matt Latzke, Jenna Sparks, Jena D. Hwang, Varsha Kishore, Minyang Tian, Pan Ji, Shengyan Liu, Hao Tong, Bohao Wu, Yanyu Xiong, Luke Zettlemoyer, Graham Neubig, Daniel S. Weld, Doug Downey, Wen-tau Yih, Pang Wei Koh & Hannaneh Hajishirzi

摘要

科学进步依赖于研究人员综合日益增长的文献的能力。大型语言模型(LLMs)能否协助科学家完成这项任务?在此,我们介绍 OpenScholar,一个专门化的检索增强型语言模型(LM)1,它通过从4500万篇开放获取论文中识别相关段落并综合带有引用的回答来回答科学查询。为评估OpenScholar,我们开发了ScholarQABench,这是首个大规模多领域文献检索基准,包含计算机科学、物理学、神经科学和生物医学中2,967个专家撰写的查询和208个长篇答案。尽管OpenScholar-8B是一个较小的开放模型,但在新的ScholarQABench上进行具有挑战性的多篇论文综合任务时,其正确率比GPT-4o高出6.1%,比PaperQA2高出5.5%。尽管GPT-4o有78%–90%的几率出现引文幻觉,但OpenScholar在引用准确性上达到了与人类专家相当的水平。OpenScholar的数据存储、检索器和自反馈推理循环改进了现成的LLM:例如,OpenScholar-GPT-4o将GPT-4o的正确率提高了12%。在人工评估中,专家更喜欢OpenScholar-8B和OpenScholar-GPT-4o的回答,其胜过专家撰写回答的比例分别为51%和70%,而GPT-4o的比例为32%。我们开源了所有工件,包括我们的代码、模型、数据存储、数据集以及一个公共演示。

正文

从科学文献中综合知识对于发现新方向、改进方法论和支持循证决策至关重要,然而,出版物的快速增长使得研究人员越来越难以保持信息同步。有效的综合需要精确的检索、准确的归因和对最新文献的访问。LLM可以提供帮助,但存在幻觉2,3、预训练数据过时4和归因受限等问题。在我们的实验中,当被要求引用计算机科学和生物医学等领域的最新文献时,GPT-4o在78%–90%的情况下编造了引用。

检索增强型LLM5,6,7通过在推理时整合外部知识来缓解其中一些问题,并催生了用于文献检索和综合的系统8,9,10。然而,大多数系统依赖于黑盒应用程序编程接口(API)或通用LLM,并且缺乏针对科学领域量身定制的开放、特定领域的检索数据存储(带有检索索引的处理后语料库)。对文献综合的评估也有限,通常侧重于狭窄的、单一学科的研究8,9或简化的任务,例如多项选择问答10。

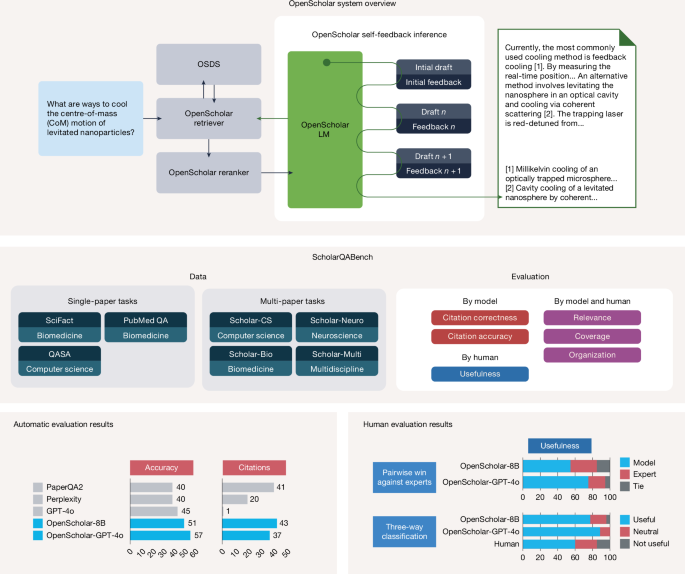

为应对准确、全面和透明的科学文献综合的挑战,我们推出了 OpenScholar(图1,顶部),据我们所知,它是第一个专门为科学研究任务设计的完全开放的检索增强型LM。OpenScholar集成了一个领域专业化的数据存储(OpenScholar DataStore, OSDS)、自适应的检索模块以及一种新的自反馈引导生成机制,该机制能够对长篇输出进行迭代改进。OSDS是一个完全开放、最新的4500万篇科学论文和2.36亿个段落嵌入的语料库,为训练和推理提供了可复现的基础。OpenScholar使用训练好的检索器和重排序器从OSDS中检索,生成带引用的回答,并通过自反馈循环对其进行迭代改进,以提高事实准确性、覆盖范围和引用准确性。同样的流程用于生成高质量的合成数据,从而无需依赖专有LLM即可训练一个紧凑的8B模型(OpenScholar-8B)和检索器。

顶部是OpenScholar的概览。OpenScholar由一个专业化的数据存储(OSDS)、检索器和LM组成,并通过带有检索的自反馈进行迭代改进回答。中间是ScholarQABench的概览。ScholarQABench包含跨多个科学学科的2,200个专家编写的问题,我们为ScholarQABench引入了自动和人工评估协议。底部是自动和人工评估结果:ScholarQABench计算机科学子集(Scholar-CS,100个问题)的实验结果显示,使用我们训练的8B模型或GPT-4o的OpenScholar大幅超越了其他系统,在人工评估中被专家的偏好率超过50%。我们的专家评估由16名拥有博士学位的专家在Scholar-Multi的108个问题上进行。

为评估OpenScholar,我们推出了ScholarQABench(图1,中间),据我们所知,这是首个用于开放式科学综合的多学科基准。与以往侧重于短格式输出、多项选择格式或领域推理任务的基准不同10,11,12,ScholarQABench要求基于来自众多论文的最新文献生成长篇回答。它包含跨计算机科学、物理学、生物医学和神经科学的3,000个研究问题和250个专家撰写的答案,由经验丰富的博士生和博士后撰写,以反映现实世界的文献回顾实践。为克服评估长篇、全面回答的困难13,14,15,16,ScholarQABench引入了一个严格的评估协议,结合了自动指标(例如,引用准确性)和基于人工评分标准的评估(覆盖范围、连贯性、写作质量和事实准确性),以便可靠地评估LLM的详细长篇回答。我们的专家分析表明,提出的多方面评估流程与专家判断高度一致,能够可靠地捕捉长篇科学回答中的覆盖范围、连贯性、写作质量和事实准确性。

我们对专有模型和开放模型(例如,GPT-4o、Llama 3.1 8B和70B)进行了评估,无论它们是否具有检索能力,以及像PaperQA2(参考文献10)这样的专业化系统,评估均在ScholarQABench上进行。尽管GPT-4o表现出强大的通用性能,但在引用准确性和覆盖范围方面仍存在不足,经常产生不准确或不存在的引用。OpenScholar在仅使用LM和检索增强流程方面均超越了其他模型,优于专有和开源系统。值得注意的是,使用完全开源的模型检查点,OpenScholar-8B的表现优于基于专有LM构建的PaperQA2和Perplexity Pro等生产系统,分别提高了6%和10%。此外,OpenScholar使用高效检索器的做法大大降低了成本。OpenScholar流程还可以增强现成的LLM。例如,当使用GPT-4o作为底层模型时,OpenScholar-GPT-4o相比单独使用GPT-4o,在正确率上提高了12%。此外,尽管专家人工性能超过了GPT-4o和其他有竞争力的基线,但OpenScholar系统在答案正确率和引用准确性方面都达到了或超过了人类专家。我们广泛的评估证明了OpenScholar核心组件(包括重排序、自反馈和验证)的重要性,以及结合多样化检索流程和训练领域专业化检索系统的价值。

除了在ScholarQABench上的自动评估外,我们还与16位来自计算机科学、物理学和生物医学等领域的科学家进行了详细的专家评估。这些专家对ScholarQABench中108个文献综合查询的模型生成回答和专家撰写回答进行了配对和细粒度的评估。OpenScholar,当与GPT-4o和我们训练的8B模型配对时,一致性地超越了专家撰写的回答,其胜率分别为70%和51%。相比之下,原生的GPT-4o(即没有检索能力)在信息覆盖范围方面表现不佳,被认为不如人类专家有用,对抗人类回答的胜率仅为31%。总体而言,这些发现表明OpenScholar可以产生高质量的输出,这些输出不仅与专家撰写的答案相当,在某些情况下甚至更优,特别是在覆盖范围和组织方面。我们还发布了第一个由OpenScholar-8B驱动的科学文献综合的公共演示。自发布以来,该演示已被超过30,000名用户使用,并收集了近90,000个跨不同科学领域的[用户查询]。

OpenScholar 在 ScholarQABench 上的性能

我们首先在全新创建的专家注释基准ScholarQABench上展示OpenScholar的关键结果。表1显示了主要基线的几个方面的得分。

基线模型

我们比较了三种设置。(1)参数化LM(无检索):Llama 3.1 8B/70B(参考文献17)和GPT-4o(gpt-4o-2024-05-13(参考文献18))生成答案和一篇论文标题列表。我们验证标题是否存在,如果存在,则获取其摘要作为引用。(2)检索增强生成(RAG)基线:使用我们的OSDS(RAGOSDS),我们检索前N个段落并将它们与输入连接起来,遵循标准的RAG流程2,18。(3)我们的方法(OpenScholar):一个带有训练好的8B模型的自定义推理流程(OpenScholar-8B),以及带有Llama 3.1 70B和GPT-4o后端(OpenScholar-70B, OpenScholar-GPT-4o)。对于多篇论文任务,我们还测试了Perplexity Pro。我们使用的是付费订阅版本;由于没有API,我们通过Selenium收集最终预测,无法提取引用,以及PaperQA2(参考文献10)。由于PaperQA2的数据存储不公开,我们使用OSDS作为其检索源。

主要结果

在单篇论文任务中,OpenScholar一致地优于其他模型。在最终准确性和引用准确性方面,OpenScholar-8B和OpenScholar-70B优于带有或不带有检索增强的Llama 3.1 8B和70B(表1)。OpenScholar-70B在PubMedQA和QASA上甚至能与GPT-4o相媲美或超越它。我们还发现,与标准RAG基线(RAGOSDS)相比,OpenScholar模型在引用准确性方面持续显示出实质性改进。

在多篇论文任务中,我们将Scholar-CS评分标准——模型响应满足的专家注释答案评分标准的数量(参见方法了解评分细节)——作为正确性的主要衡量标准。我们还使用LLM裁判(‘LLM’)评估Scholar-Multi的整体写作质量,并跟踪所有数据集的引用准确性。OpenScholar-8B、OpenScholar-70B和OpenScholar-GPT-4o(分别使用我们微调的基于Llama 3.1 8B的LM和现成的Llama 3.1 70B及GPT-4o作为生成LM的OpenScholar流程)展示了强劲的性能。具体来说,OpenScholar-GPT-4o在Scholar-CS评分标准上比单独的GPT-4o提高了12.7分,比标准RAG提高了5.3分。当与训练好的OpenScholar-8B结合时,OpenScholar大大优于使用现成Llama 3.1 8B的流程,展示了领域专业化训练的益处。此外,OpenScholar-8B在评分标准表现上比GPT-4o、Perplexity Pro或PaperQA2等专有系统有显著优势,这些系统使用GPT-4o模型进行段落重排序、摘要和答案生成。尽管我们发现PaperQA2在引用准确性上与OpenScholar相当甚至更优,但其回答通常仅依赖于一两篇论文,分别总结每个检索到的片段。这导致覆盖范围有限,并导致其在Scholar-CS评分标准和LLM裁判得分上表现较低。这些发现强调了在有效的文献综合中平衡精确性和召回率的重要性。值得注意的是,通过利用带有轻量级双编码器、交叉编码器和内部模型的[高效检索流程],OpenScholar-8B和OpenScholar-GPT-4o实现了低得多的成本——比PaperQA2便宜好几个数量级——同时保持了高性能。

参数化LM的局限性

在单篇论文和多篇论文任务中,我们观察到非检索增强基线表现不佳——检索几乎总是有助于获得更好的性能——而没有任何检索的模型通常难以生成正确的引用,并且在多篇论文任务中覆盖范围有限。表2展示了四种模型输出中引用的论文统计数据。我们报告了通过使用Semantic Scholar API验证引用的论文标题是否存在所产生的完全虚构的引用数量(‘幻觉引用数量’)。在所有模型中,实际存在的引用论文的比例非常低:尽管参考列表看起来合理,但78%–98%的标题是虚构的,生物医学领域的比例最差。这与以往的发现相呼应,即LLM会对长尾、未充分代表的知识产生幻觉2,19,我们认为在开放网络覆盖不足的科学领域中,这种影响被放大了。对2025年8月发布的GPT-5重复此分析,将标题层级的幻觉降低到39%,但虚假引用仍然普遍存在。模型回答的示例以及论文标题列表可在补充表19和20中找到。我们还注意到,即使引用指向真实论文,其中大部分也无法通过相应的摘要得到证实,导致引用准确率接近于零。

我们还观察到这些模型生成的回答覆盖范围有限。在Scholar-Multi上,非检索模型(Llama 3.1 8B、70B和GPT-4o)的平均得分明显低于检索增强模型。这种差异主要源于覆盖率得分的显著降低;例如,Llama 3.1 8B的覆盖率得分为3.45,而Llama 3.1 8B + OSDS(一种标准的RAG基线)将覆盖率得分提高到4.01。这些结果表明,仅依赖模型的参数化知识在科学领域尤其困难,特别是对于较小的LM。

人类在 ScholarQABench 上的表现

我们还分析了人类专家在此具有挑战性的文献综合任务上的表现。具体来说,我们评估了人类撰写答案在Scholar-CS和Scholar-Multi这两个具有长篇人工注释的ScholarQABench子集上的表现。对于两者,我们应用了与模型生成回答相同的评估流程来评估评分标准和引用准确性。对于Scholar-Multi,没有评分标准的评估,但我们对人类和模型的回答进行了专家评估,并在下一节中比较了结果。表3比较了人类性能与OpenScholar-GPT-4o、OpenScholar-8B、PaperQA2和GPT-4o(无检索)的性能。我们的分析表明,人类撰写的回答在质量和相关性方面仍然是强有力的基线。在基于评分标准的评估中,人类回答在无检索的情况下优于GPT-4o达9.6分,优于OpenScholar-8B达2.9分。PaperQA2表现出很高的引用准确性,但其在评分标准、组织、覆盖范围和相关性方面的得分较低。相比之下,OpenScholar-GPT-4o在评分标准得分上甚至超过了人类专家,而OpenScholar-8B的引用准确性达到了专家水平。我们发现OpenScholar倾向于产生比人类或其他基线系统更全面的回答,引用了更多的论文,这反映在回答长度和引用数量上。在补充信息第6节中,我们对模型撰写和人类撰写的回答进行了详细的人工分析,并进一步研究了改进科学文献综合的关键因素。

消融实验与分析

推理组件的消融

我们通过移除以下组件来对推理组件进行消融:(1)重排序(仅使用前N个OSDS结果);(2)反馈(仅生成一次然后归因);以及(3)引用验证(省略最终检查)。对于OpenScholar-8B,我们还通过用现成的Llama 3.1 8B替换训练好的模型来消融训练(如OpenScholar-GPT-4o所示)。扩展数据表2显示,所有移除操作都会导致正确率和引用准确率显著下降,其中移除重排序造成的损失最大。移除反馈对GPT-4o的影响比对我们训练的8B模型更大(可能是因为后者在训练中学到了反馈模式),而跳过事后归因会降低引用准确性和最终正确性。训练好的OpenScholar-8B与原版OpenScholar-8B之间的差距突显了领域专业化训练的价值。

检索的消融

我们还比较了仅使用OSDS(密集检索)、仅使用S2(Semantic Scholar API)、仅使用Web(You.com)以及它们的组合。为隔离检索效果,我们使用我们的8B LM,不使用自反馈或引用验证,并使用OpenScholar重排序器重排序至前15名。在Scholar-CS上(扩展数据表2),仅Web性能最差(正确率45.9,引用F1 12.6),仅S2在引用方面有所改善(47.9/39.1),组合流程最佳(49.6/47.6)。以文献为中心的定制检索(密集+API+重排序)产生了最强的[事实性]和归因能力。

我们分析了检索到的段落数量(前N个)如何影响性能。我们使用我们的8B训练模型和Llama 3.1 8B,在Scholar-CS上评估生成和引用准确性,比较标准RAG和OpenScholar。扩展数据图3和4总结了结果。尽管Llama 3.1经过训练可以接受多达128,000个token,但其性能在超过特定上下文大小时会下降:将前N从5增加到10可以提高正确性,但更大的N会损害正确性和引用准确性。这表明,尽管具有长上下文能力,但在没有专门训练的情况下,较小的LM可能难以有效利用许多段落。相比之下,我们训练的8B模型在N=20时仍然保持强劲,而更大的模型(例如,Llama 3.1 70B)对较长的上下文更具鲁棒性。

专家对OpenScholar有效性的评估

为补充自动指标并检验OpenScholar的优势和局限性,我们进行了专家评估,将人类撰写的答案与LLM系统生成的答案进行了比较。这项研究涉及100多个文献综述问题和超过15名参与者,包括博士生、研究科学家和具有相关领域专业知识的大学教授。总而言之,我们对专家和模型的回答进行了400多次细粒度的专家评估。

评估设计

我们使用了来自Scholar-Multi的108个问答(QA)对,由专家(专家作者)撰写。我们对三个设置(设置)对这些问题进行了评估:GPT-4o(无外部检索)、使用GPT-4o作为生成器的OpenScholar(OpenScholar-GPT-4o)和使用我们训练的8B模型的OpenScholar(OpenScholar-8B),每个都生成带有引用的答案。然后,我们招募了一组独立的博士级领域专家来根据专家撰写的答案对模型生成的答案进行评分。

具体来说,每次评估都涉及展示一个问题、一个模型生成的答案和一个人类撰写的答案。专家评分员然后对每个答案进行细粒度的评估,并提供两者之间的配对偏好判断。对于细粒度评估,我们使用方法中描述的五级评估标准(覆盖范围、相关性和组织性),注释者使用相同的评分标准对模型和人类答案进行评分。详细的提示呈现在补充信息第6节中。对于有用性,注释者在1到5的等级上评分,我们将其转换为三个类别:无用(1, 2)、中性(3)和有用(4, 5)。然后我们计算属于有用类别的答案百分比。对于配对偏好,注释者选择其中一个答案或标记为‘平局’,如果他们认为两个答案的质量相等。注释者还可以选择提供解释,说明为什么一个答案比另一个更好。

专家作者详情

我们用于问题和答案撰写的专家作者是来自美国各地研究机构的12名博士生和博士后研究员,他们都在各自领域拥有至少三年的研究经验,并在期刊或会议上发表了多篇论文。我们专家作者涵盖的专业领域包括计算机科学(自然语言处理、计算机视觉、人机交互)、物理学(天体物理学、光子学/光学)和生物医学(神经科学、生物成像)领域,我们将专家注释员分配到他们专业领域内的问题上。平均而言,我们向每人支付了35至40美元的报酬。

专家评分员详情

来自这三个领域的16名专家评分员为我们的评估做出了贡献,其中12名也参与了答案生成。所有专家评分员都具备与答案撰写者相同的资历。为最大限度地减少潜在偏见,我们确保评分员不会评估他们自己撰写的问题的回答,通过将评估任务分配给不同的专家组来实现。每次实例的评估由一到三名专家评分员进行,具体取决于可用性。使用配对比较并允许平局,注释者间一致性为0.68;使用宽松方法(合并平局)时为0.70。平均而言,每位专家评分员花费五分钟评估每个实例,并获得25至35美元的报酬。

专家评估结果

总体结果

表4展示了每个评估方面的平均得分,以及相对于人类回答的相对胜率。扩展数据图5说明了人类、GPT-4o以及使用Llama 3.1 8B和GPT-4o的OpenScholar的得分分布。值得注意的是,OpenScholar-GPT-4o和我们的OpenScholar-8B版本在超过50%的情况下优于人类回答,其优势主要归因于它们提供更广泛、更深入信息(覆盖范围)的能力。相比之下,缺乏检索能力的GPT-4o,其覆盖范围大大受限,在人类回答面前的胜率较低…… [内容被截断]

🚀 想要体验更好更全面的AI调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,文档丰富,小白也可以简单操作。

评论区