📢 转载信息

原文链接:http://bair.berkeley.edu/blog/2024/07/20/visual-haystacks/

原文作者:Berkeley AI Research (BAIR) Blog

人类擅长处理海量的视觉信息,这是实现通用人工智能(AGI)的关键技能。几十年来,人工智能研究人员开发了视觉问答(VQA)系统,用于解释单个图像中的场景并回答相关问题。虽然基础模型的最新进展显著缩小了人类和机器视觉处理之间的差距,但传统的 VQA 仅限于一次推理单个图像,而不是整个视觉数据集合。

这种限制在更复杂的场景中带来了挑战。例如,辨别医学图像集合中的模式、通过卫星图像监测森林砍伐、利用自主导航数据绘制城市变化地图、分析大型艺术收藏品中的主题元素,或根据零售监控录像了解消费者行为。每个场景不仅需要在数百或数千张图像上进行视觉处理,还需要对这些发现进行跨图像处理。为了解决这一差距,本项目专注于“多图像问答”(MIQA)任务,这超出了传统 VQA 系统的能力范围。

Visual Haystacks:第一个“以视觉为中心”的“大海捞针”(NIAH)基准测试,旨在严格评估大型多模态模型(LMM)处理长上下文视觉信息的能力。

如何对 MIQA 中的 VQA 模型进行基准测试?

“大海捞针”(NIAH)挑战最近成为基准测试 LLM 处理包含“长上下文”输入的能力的最流行范式之一,即大量输入数据(如长文档、视频或数百张图像)。在此任务中,包含特定问题答案的关键信息(“针”)被嵌入到大量数据(“干草堆”)中。系统必须检索相关信息并正确回答问题。

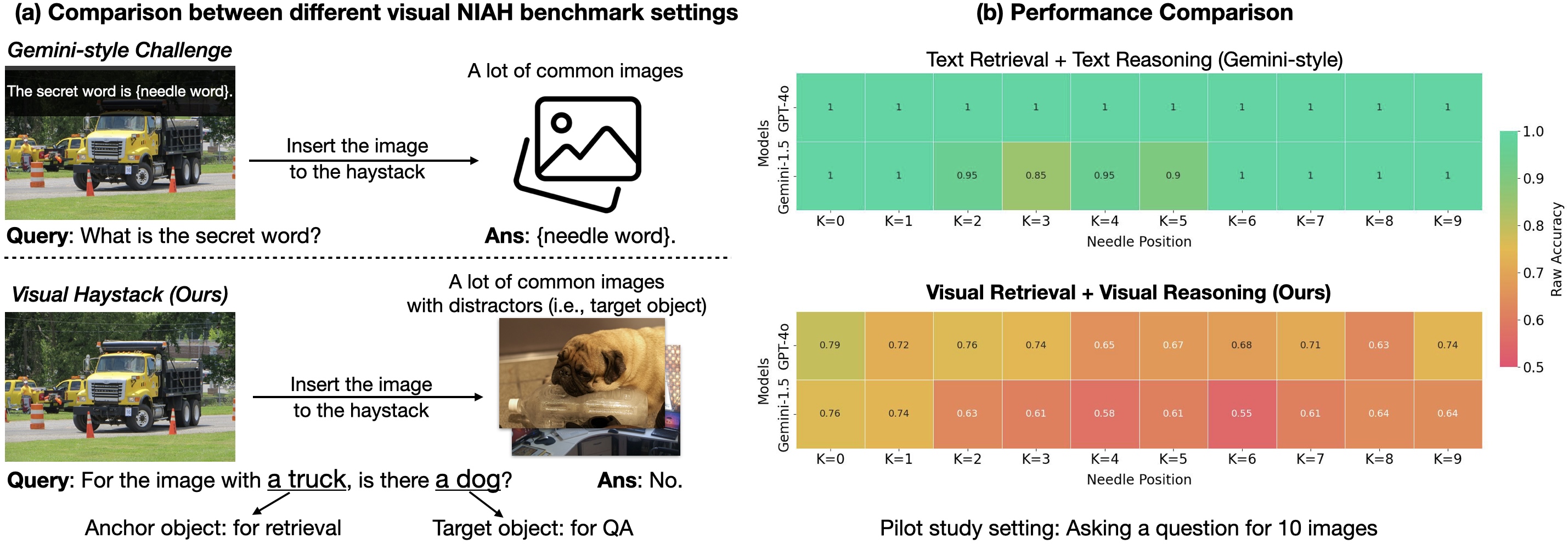

第一个用于视觉推理的 NIAH 基准测试由谷歌在其 Gemini-v1.5 技术报告中引入。在该报告中,他们要求模型从大型视频的单个帧中检索覆盖的文本。事实证明,现有模型在此任务上表现良好——主要是因为它们强大的 OCR 检索能力。但如果我们提出更多视觉问题呢?模型仍然能表现得一样好吗?

什么是 Visual Haystacks (VHs) 基准测试?

为了评估“以视觉为中心”的长上下文推理能力,我们引入了“Visual Haystacks (VHs)”基准测试。这个新基准旨在评估大型多模态模型(LMM)在大型不相关图像集上的视觉检索和推理能力。VHs 包含大约 1K 个二元问答对,每个集合包含 1 到 10K 张图像。与以往专注于文本检索和推理的基准测试不同,VHs 的问题集中于识别特定视觉内容(如物体)的存在,利用 COCO 数据集的图像和注释。

VHs 基准测试分为两个主要挑战,每个挑战旨在测试模型在响应查询之前准确定位和分析相关图像的能力。我们精心设计了数据集,以确保仅凭猜测或依赖常识推理而无需查看图像不会带来优势(即在二元 QA 任务中达到 50% 的准确率)。

-

单针挑战 (Single-Needle Challenge):在图像干草堆中只有一个“针”图像存在。问题形式为:“对于带有锚定对象的图像,是否存在目标对象?”

-

多针挑战 (Multi-Needle Challenge):在图像干草堆中存在两到五个“针”图像。问题形式为:“对于所有带有锚定对象的图像,它们是否都包含目标对象?”或“对于所有带有锚定对象的图像,它们中是否有任何一个包含目标对象?”

来自 VHs 的三个重要发现

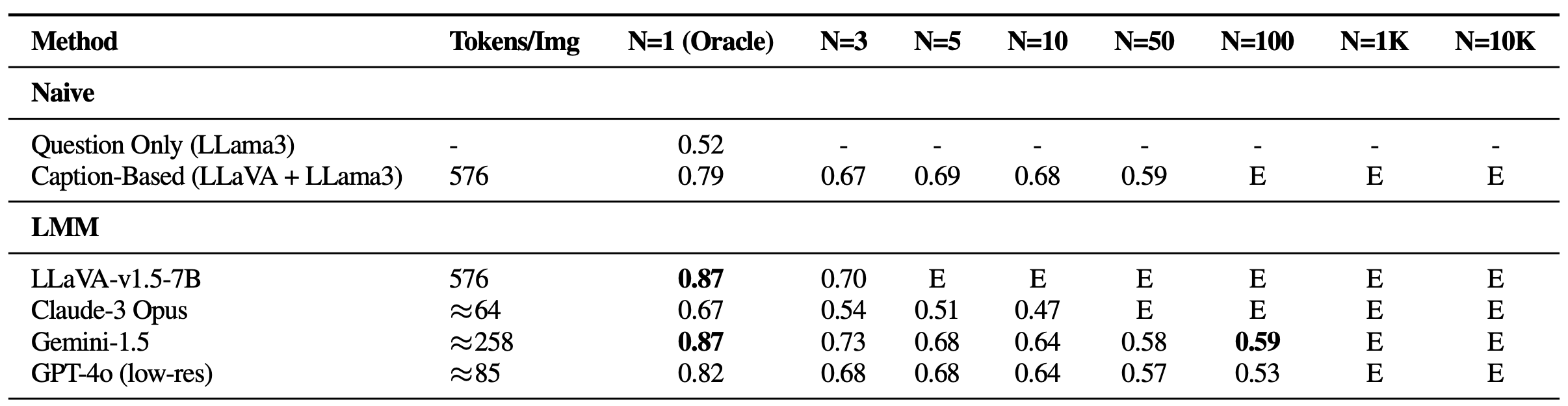

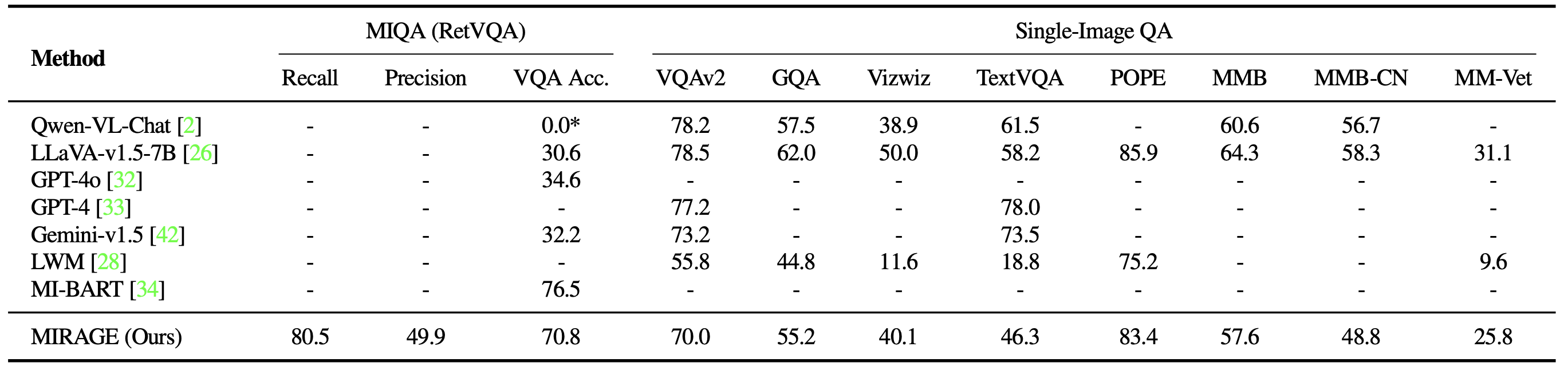

Visual Haystacks (VHs) 基准测试揭示了当前大型多模态模型(LMM)在处理大量视觉输入时面临的重大挑战。在我们的实验中1,对于单针和多针模式,我们评估了几种开源和专有方法,包括 LLaVA-v1.5、GPT-4o、Claude-3 Opus 和 Gemini-v1.5-pro。此外,我们还加入了一个“字幕”(Captioning)基线,它采用两阶段方法:首先使用 LLaVA 为图像生成字幕,然后使用 Llama3 根据字幕文本回答问题。以下是三个关键见解:

-

在视觉干扰物面前的挣扎

在单针设置中,尽管保持了很高的神谕准确率,但随着图像数量的增加,性能出现了明显的下降——这在先前的基于文本的 Gemini 式基准测试中没有出现。这表明现有模型主要在视觉检索方面遇到困难,尤其是在存在视觉干扰物时。此外,必须强调开源 LMM(如 LLaVA)的限制,由于 2K 的上下文长度限制,它们最多只能处理三张图像。另一方面,专有模型如 Gemini-v1.5 和 GPT-4o,尽管声称具有扩展的上下文能力,但在使用 API 调用时,由于有效载荷大小限制,当图像数量超过 1K 时,往往无法处理请求。

单针问题在 VHs 上的性能。随着干草堆大小 (N) 的增加,所有模型的性能都显著下降,表明没有一个模型能抵抗视觉干扰物。E:超出上下文长度。 -

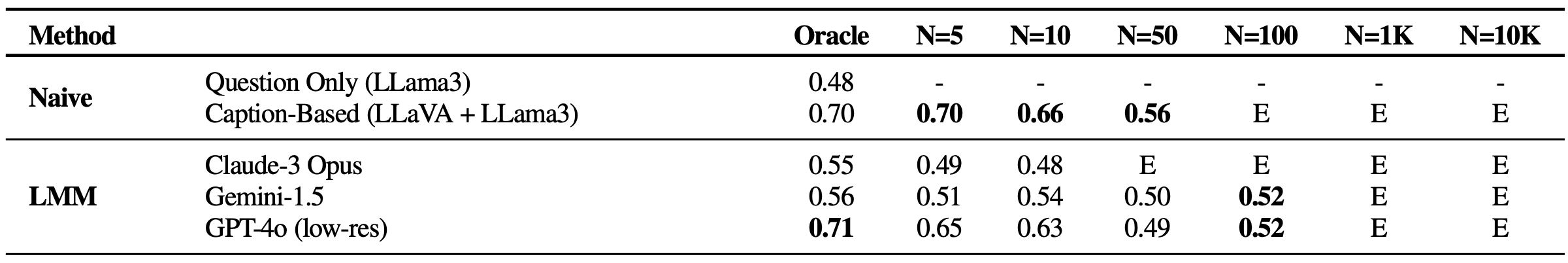

跨多图像推理的困难

有趣的是,与使用 LLaVA(字幕模型)和 Llama3(LLM 聚合器)进行链接的基本方法相比,所有基于 LMM 的方法在单图像 QA 中包含 5 张以上的图像以及在所有多针设置中的表现都很弱。这种差异表明,虽然 LLM 能够有效地整合长上下文字幕,但现有的基于 LMM 的解决方案不足以跨多张图像处理和整合信息。值得注意的是,多图像场景下的性能急剧恶化,Claude-3 Opus 仅在神谕图像上表现较弱,而 Gemini-1.5/GPT-4o 在较大的图像集(50 张图像)上准确率下降到 50%(如同随机猜测)。

多针问题在 VHs 上的结果。所有具有视觉意识的模型表现都很差,表明模型发现隐式整合视觉信息很具有挑战性。 -

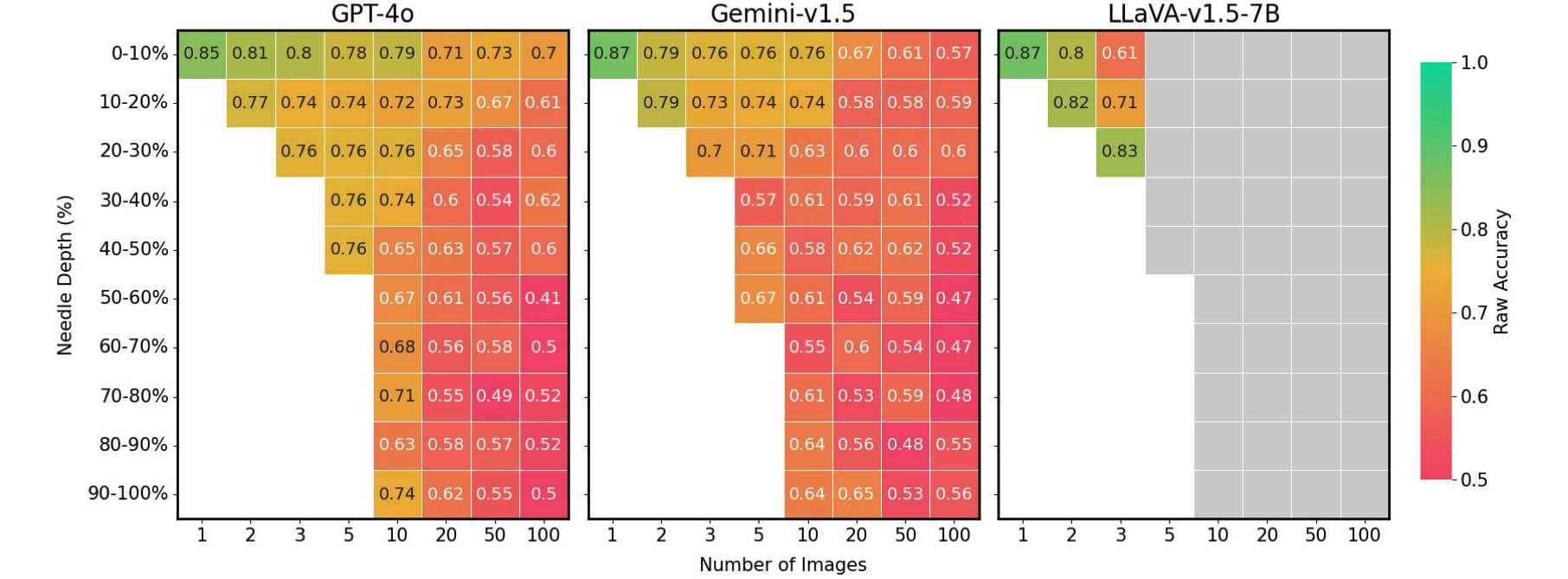

视觉领域的现象

最后,我们发现 LMM 的准确性在很大程度上受到“针”图像在输入序列中位置的影响。例如,当“针”图像紧接在问题之前放置时,LLaVA 的性能更好,而在其他情况下会下降高达 26.5%。相比之下,专有模型在图像位于开头时通常表现更好,而在不位于开头时性能会下降多达 28.5%。这种模式与自然语言处理(NLP)领域中看到的 “失中”(lost-in-the-middle)现象相呼应,即位于上下文开头或结尾的关键信息会影响模型性能。这一问题在先前的 Gemini 式 NIAH 评估中并不明显,因为那仅需要文本检索和推理,凸显了我们的 VHs 基准测试带来的独特挑战。

不同图像设置下,“针”位置与 VHs 性能的对比。当“针”位置不理想时,现有的 LMM 会出现高达 41% 的性能下降。灰色框:超出上下文长度。

MIRAGE:一种基于 RAG 的改进 VHs 性能的解决方案

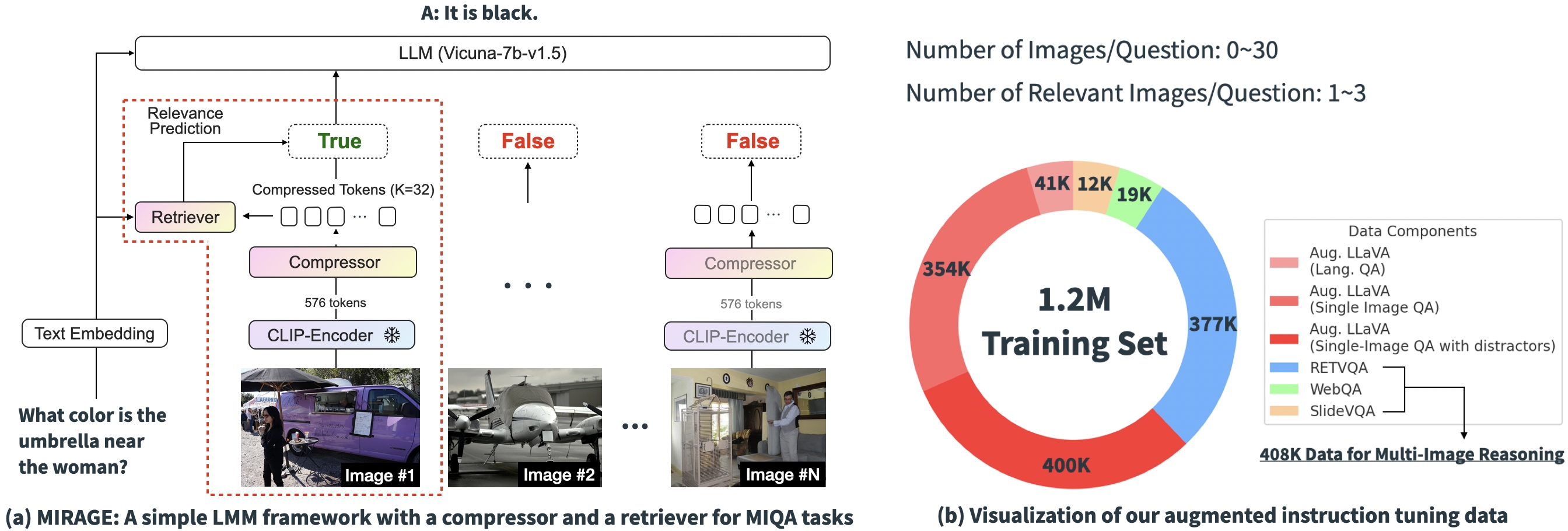

基于上述实验结果,很明显,现有 MIQA 解决方案的核心挑战在于:(1)在没有位置偏差的情况下,能够从大量可能不相关的图像中准确地检索相关图像;以及(2)从这些图像中整合相关的视觉信息以正确回答问题。为解决这些问题,我们引入了一种开源的、简单的单阶段训练范式——“MIRAGE”(多图像检索增强生成),它扩展了 LLaVA 模型以处理 MIQA 任务。下图显示了我们的模型架构。

我们提出的范式由几个组件组成,每个组件都旨在缓解 MIQA 任务中的关键问题:

-

压缩现有编码:MIRAGE 范式利用一个查询感知压缩模型将视觉编码器 token 减少到更小的子集(小 10 倍),从而在相同的上下文长度内容纳更多图像。

-

采用检索器过滤掉不相关信息:MIRAGE 使用与 LLM 微调在线训练的检索器,预测图像是否相关,并动态删除不相关的图像。

-

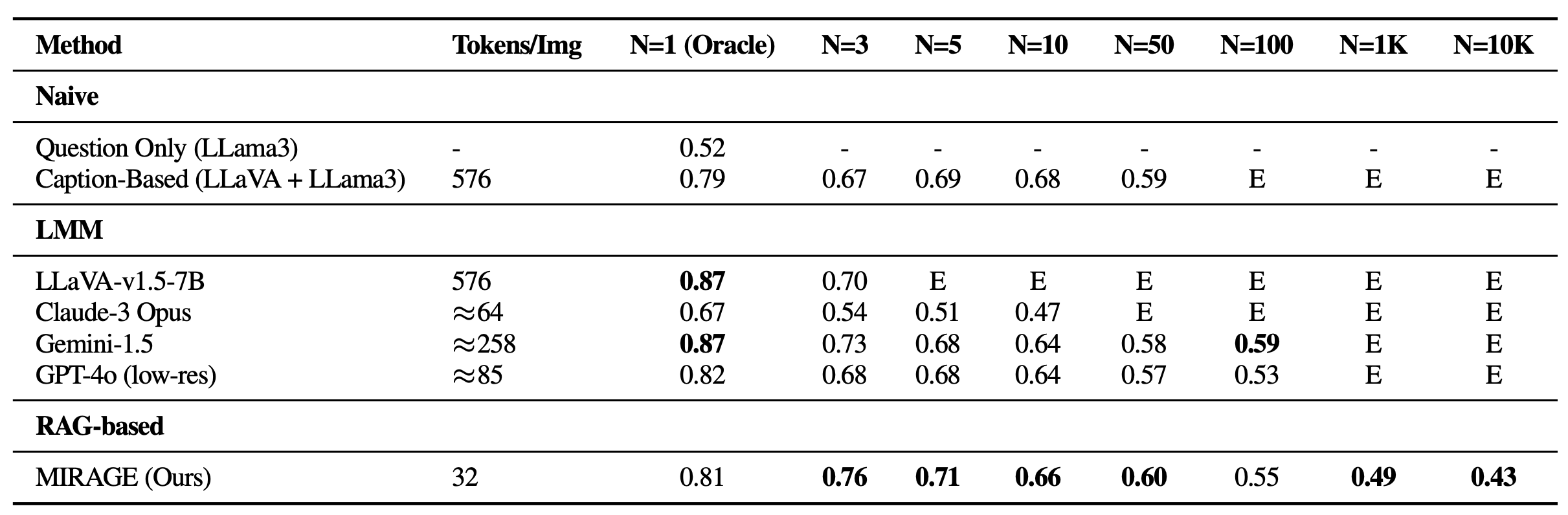

多图像训练数据:MIRAGE 使用多图像推理数据和合成多图像推理数据来增强现有的单图像指令微调数据。

结果

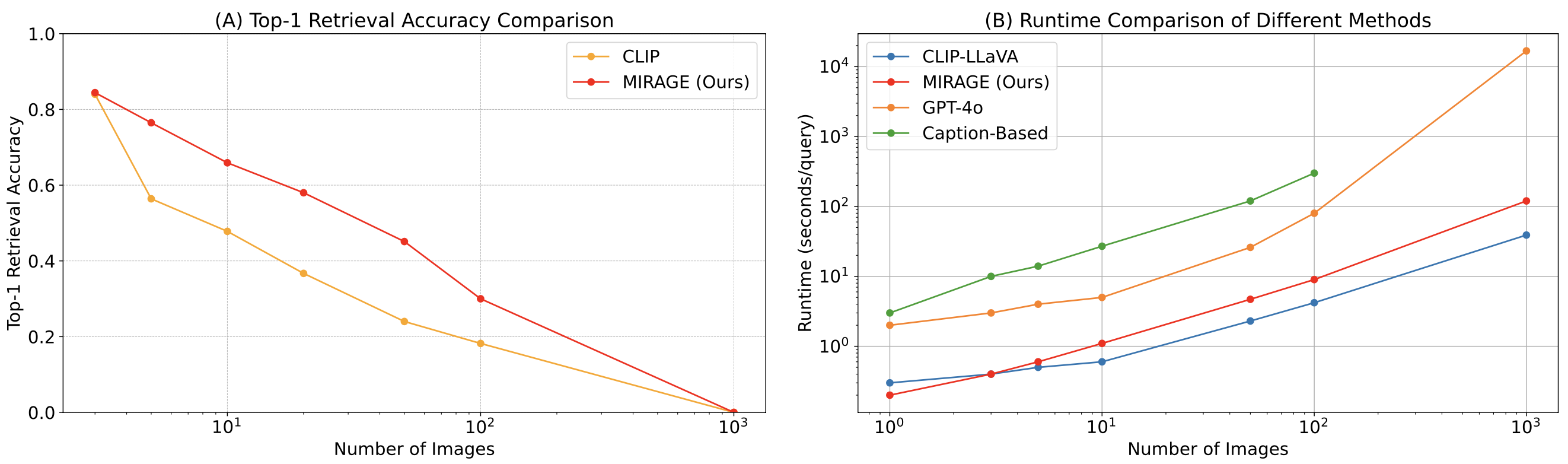

我们使用 MIRAGE 重新审视 VHs 基准测试。除了能够处理 1K 或 10K 图像外,尽管其单图像 QA 主干较弱(每张图像只有 32 个 token),MIRAGE 在大多数单针任务上都取得了最先进的性能!

我们还在各种 VQA 任务上对 MIRAGE 和其他基于 LMM 的模型进行了基准测试。在多图像任务上,MIRAGE 展现出强大的召回率和精确率,显著优于 GPT-4、Gemini-v1.5 和 Large World Model (LWM) 等强大的竞争对手。此外,它在单图像 QA 性能上也表现出竞争力。

最后,我们将 MIRAGE 的共同训练的检索器与 CLIP 进行了比较。我们的检索器在没有损失效率的情况下,性能明显优于 CLIP。这表明,虽然 CLIP 模型可以作为开放词汇图像检索的良好检索器,但在处理类似问题的文本时,它们可能效果不佳。

最后说明

在这项工作中,我们开发了 Visual Haystacks (VHs) 基准测试,并确定了现有大型多模态模型 (LMM) 中存在的三个普遍缺陷:

-

在视觉干扰物面前的挣扎:在单针任务中,随着图像数量的增加,LMM 的性能急剧下降,表明在过滤掉不相关的视觉信息方面存在重大挑战。

-

跨多图像推理的困难:在多针设置中,像字幕后接基于语言的 QA 这样的简化方法优于所有现有的 LMM,凸显了 LMM 在跨多图像处理信息方面的能力不足。

-

视觉领域的现象:专有和开源模型都对“针”信息在图像序列中的位置敏感,在视觉领域表现出“失中”现象。

作为回应,我们提出了 MIRAGE,这是一个开创性的视觉检索增强生成器(视觉-RAG)框架。MIRAGE 通过创新的视觉 token 压缩器、共同训练的检索器以及增强的多图像指令调优数据来解决这些挑战。

在探索完这篇博客文章后,我们鼓励所有未来的 LMM 项目使用 Visual Haystacks 框架对模型进行基准测试,以便在部署之前识别并纠正潜在的缺陷。我们还敦促社区探索多图像问答,作为推动真正通用人工智能(AGI)前沿发展的一种手段。

最后,请查看我们的 项目页面、arxiv 论文,并点击我们的 github 仓库上的星标按钮!

@article{wu2024visual, title={Visual Haystacks: Answering Harder Questions About Sets of Images}, author={Wu, Tsung-Han and Biamby, Giscard and and Quenum, Jerome and Gupta, Ritwik and Gonzalez, Joseph E and Darrell, Trevor and Chan, David M}, journal={arXiv preprint arXiv:2407.13766}, year={2024} } 🚀 想要体验更好更全面的AI调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,文档丰富,小白也可以简单操作。

评论区