📢 转载信息

原文链接:https://www.ifanr.com/1641130?utm_source=rss&utm_medium=rss&utm_campaign=

原文作者:ifanr

告别选择困难症:火山引擎发布豆包大模型1.6,实现成本与效果的完美平衡

在当今的AI应用场景中,用户体验常常面临两难:简单问题AI秒回但敷衍了事;复杂问题深度思考虽效果好,却带来高延迟和Token的剧烈消耗,直接推高企业成本。

对于企业而言,Token消耗量与成本直接挂钩。随着AI应用需求的爆发式增长,日均Token调用量持续攀升,企业陷入了“要效果还是要成本”的痛苦抉择。

在近日武汉举办的FORCE LINK AI创新巡展上,火山引擎通过四款重磅新品给出了答案:小孩子才做选择,专业人士全都要。

新发布的包括豆包大模型1.6、豆包1.6 lite、豆包语音合成模型2.0以及声音复刻模型2.0,旨在全方位提升AI应用的效率与经济性。据IDC报告,火山引擎已占据中国公有云大模型服务市场近半壁江山,稳居第一。

【重磅升级】豆包大模型1.6:原生支持四档思考长度调节

深度思考模式虽然能将效果提升31%,但因延迟和Token消耗过高,实际使用率并不理想。为了解决这一行业痛点,豆包大模型1.6首次在国内原生支持Minimal、Low、Medium、High四档思考长度调节,相当于给AI装上了“变速器”。

- 灵活切换:简单查询使用Minimal档节省Token,复杂推理则切换至High档保证效果。

- 效率飞跃:以低思考档为例,相比升级前,总输出Tokens直接减少了77.5%,思考时间骤降84.6%,而效果保持不变。

这种对Token成本的精确控制,极大地提升了资源的利用效率。

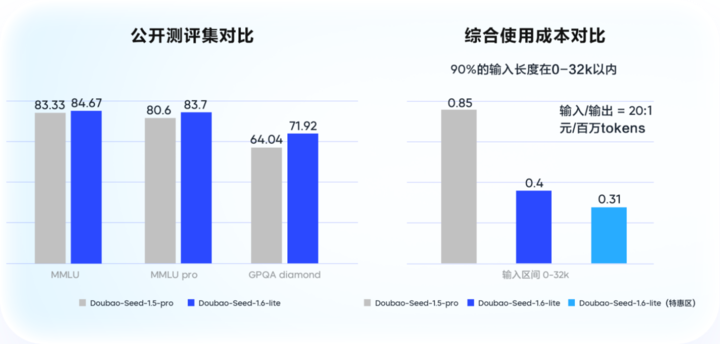

豆包1.6 lite:效果提升,成本腰斩

火山引擎同时推出了更轻量级的豆包大模型1.6 lite。在效果上,该模型超越了前代旗舰豆包1.5 Pro,在企业级场景测评中提升了14%。成本方面,在特定输入区间内,综合使用成本较1.5 Pro狂降53.3%。这种“单位Token价值密度”的提升,确保每一分投入都用在刀刃上。

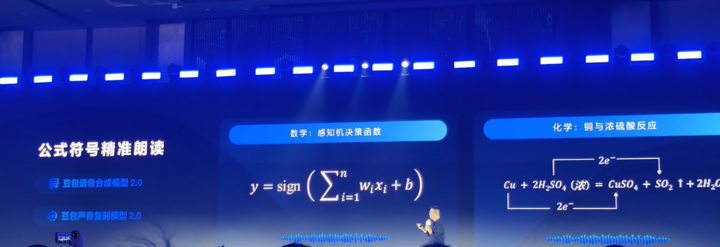

语音模型进化:复杂公式朗读准确率飙升至90%

在语音交互日益重要的今天,豆包语音合成模型2.0和声音复刻模型2.0带来了突破性进展,尤其解决了业界长期难以攻克的复杂公式朗读难题。

目前市场上同类模型的朗读准确率普遍低于50%,而新模型经过针对性优化后,在中小学全学科的复杂公式朗读准确率直接飙升至90%。

这得益于基于豆包大语言模型的新架构,使声音模型具备了深度语义理解能力和上下文推理功能。用户可以通过自然语言指令精确控制语速、情绪、声线等,例如:“来点温柔的感觉”或“读得激动点”,实现极高的语音可控性。

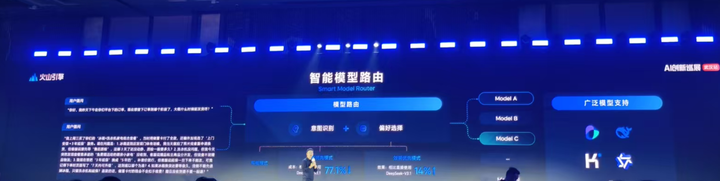

智能模型路由:AI自主选择最优模型

面对百花齐放的模型生态,如何选择性价比最高的模型成为企业的“灵魂拷问”。火山引擎发布了国内首个针对模型智能选择的解决方案——智能模型路由(Smart Model Router),现已在火山方舟上线。

该功能支持“平衡模式”、“效果优先模式”和“成本优先模式”,能自动匹配任务请求所需的最合适模型。AI能够判断“这个任务值得烧多少Token”。

实测数据显示,在成本优先模式下,实现与DeepSeek-V3.1相似的效果时,综合成本最高可下降超过70%。

Token:AI时代的“千瓦时”

谭待在发布会上指出,深度思考模型正与多模态能力融合,企业级Agent日益成熟。智能模型路由的出现,形成了一个正反馈循环:更强能力解锁新场景,消耗量推高促使路由优化,成本下降释放更多需求弹性。

Token正在成为AI时代的“千瓦时”。技术的迭代,最终目标是让用户用得起、更要用得好。分档思考和智能路由的结合,意味着用户不再需要纠结于“快”与“好”,AI将自动提供最恰当的解决方案。

🚀 想要体验更好更全面的AI调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,文档丰富,小白也可以简单操作。

评论区