📢 转载信息

原文链接:https://www.ithome.com/0/908/118.htm

原文作者:故渊

IT之家 12 月 26 日消息,小红书携手复旦大学,联合推出布局控制生成(Layout-to-Image)领域的突破性方案 InstanceAssemble,通过创新“实例组装注意力”机制,实现了从简单到复杂、稀疏到密集布局的精准图像生成,相关成果已被 NeurIPS 2025 收录。

AI 绘画技术近年来快速发展,从最初的“文字生成图像”(Text-to-Image)逐步迈向“布局控制生成”(Layout-to-Image),后者会根据用户给定的空间布局约束(如边界框 Bounding Boxes、分割掩码 Masks 或骨架图)生成与之对应的图像。

“布局控制生成”技术的难点之一,就是如何让 AI 精确按照用户指定的位置和内容生成图像,面临布局对齐不准、语义脱节或计算成本过高的问题。

而复旦大学与小红书联合发布的 InstanceAssemble 新技术,成功实现了对图像中每个物体的精准布局控制,标志着 AI 绘画进入“可精准构图”的新阶段。

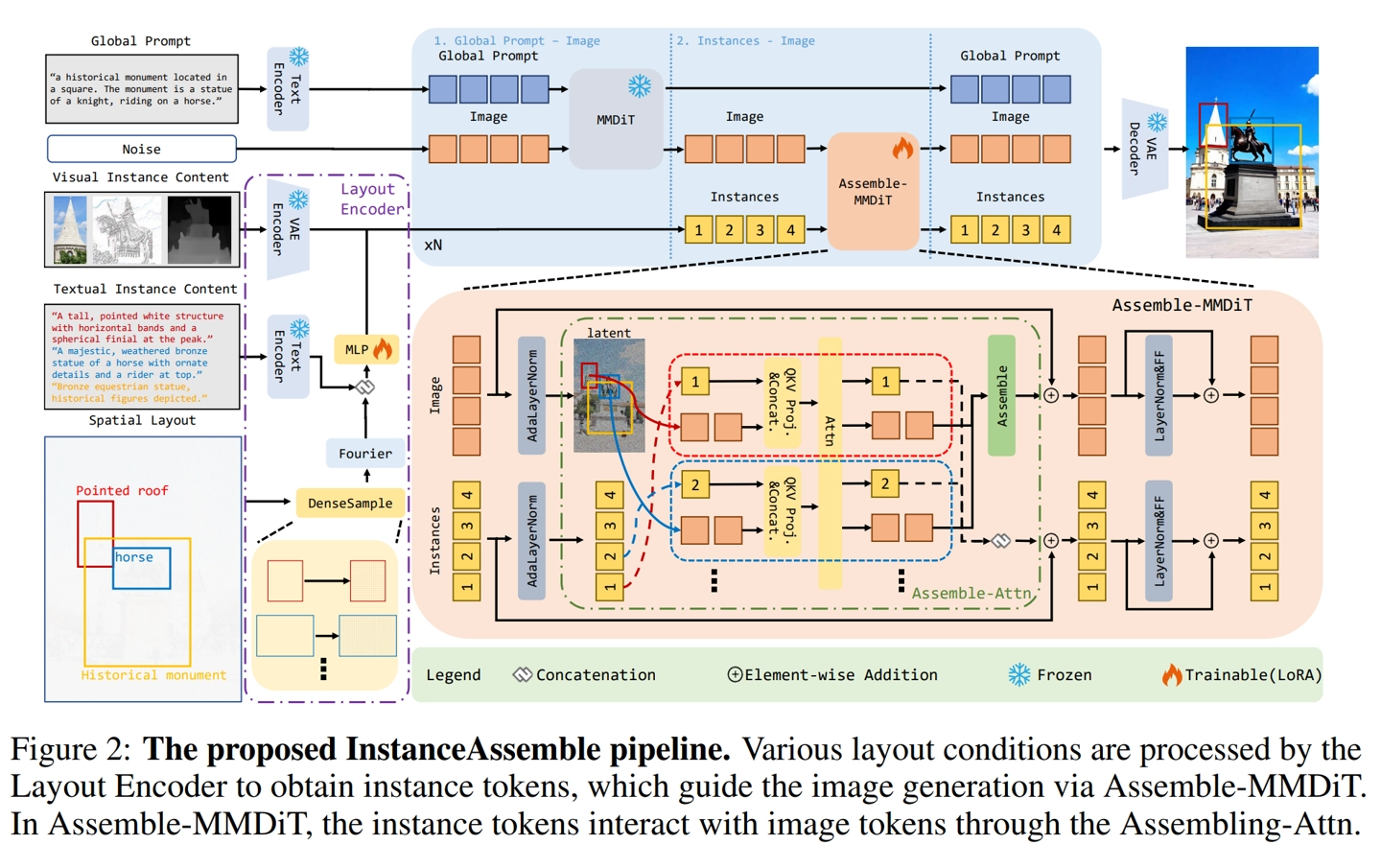

该技术基于当前主流的扩散变换器架构,创新性地提出了“实例拼装注意力”机制。用户只需提供每个物体的边界框位置和内容描述,AI 就能在对应位置生成符合语义的图像内容。无论是简单的几个物体,还是密集复杂的场景,InstanceAssemble 都能保持高精度的布局对齐和语义一致性。

值得一提的是,该技术还采用轻量级适配方式降低使用门槛,无需重新训练整个模型,仅通过约 7100 万个参数(约 3.46% 额外参数),就能适配 Stable Diffusion3-Medium 模型,而适配 Flux.1 模型更是低至 0.84%。

实验中,InstanceAssemble 在包含 90 万个实例的密集布局数据集上表现优异,大幅超越了现有方法。

研究团队为能更准确地衡量布局与图像的匹配程度,还创建了包含 5000 张图像和 90000 个实例的“Denselayout”基准测试集,以及全新的“Layout Grounding Score”(LGS)评估指标。

实验表明,InstanceAssemble 在各种布局条件下均表现优异,即使在训练时仅使用稀疏布局(≤10 个实例)的情况下,也能在密集布局(≥10 个实例)上保持稳健性能。

这项技术已开源,代码和预训练模型可在 GitHub 获取,为设计、广告和内容创作等领域的应用提供了强大支持。

IT之家附上参考地址

广告声明:文内含有的对外跳转链接(包括不限于超链接、二维码、口令等形式),用于传递更多信息,节省甄选时间,结果仅供参考,IT之家所有文章均包含本声明。

🚀 想要体验更好更全面的AI调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,文档丰富,小白也可以简单操作。

评论区