📢 转载信息

原文链接:https://blogs.nvidia.com/blog/data-blackwell-ultra-performance-lower-cost-agentic-ai/

原文作者:Ashraf Eassa

包括微软(Microsoft)、CoreWeave和甲骨文云基础设施(Oracle Cloud Infrastructure)在内的云提供商,正在大规模部署NVIDIA GB300 NVL72系统,以满足智能体编码和编码助手等低延迟、长上下文使用场景的需求。

NVIDIA Blackwell平台已被Baseten、DeepInfra、Fireworks AI和Together AI等领先的推理提供商广泛采用,以将每Token成本降低高达10倍。现在,NVIDIA Blackwell Ultra平台正将这一势头推向智能体AI(Agentic AI)的新高度。

AI智能体和编码助手正推动与软件编程相关的AI查询呈爆炸式增长:根据OpenRouter的《推理状态报告》,这一比例从去年的11%增至约50%。这些应用要求低延迟以保持多步骤工作流程中的实时响应能力,并要求长上下文以跨整个代码库进行推理。

SemiAnalysis的最新InferenceX性能数据表明,NVIDIA的软件优化与下一代NVIDIA Blackwell Ultra平台的结合,在这两个方面都实现了突破性进展。NVIDIA GB300 NVL72系统现在与NVIDIA Hopper平台相比,每兆瓦吞吐量提高了高达50倍,从而实现了35倍的更低Token成本。

通过在芯片、系统架构和软件方面进行创新,NVIDIA的极端代码设计加速了从智能体编码到交互式编码助手的AI工作负载性能——同时在规模化部署中推动成本下降。

GB300 NVL72为低延迟工作负载提供高达50倍的性能提升

Signal65最近的分析表明,NVIDIA GB200 NVL72凭借极端的硬件和软件代码设计,每瓦特可提供超过10倍的Token数,与NVIDIA Hopper平台相比,Token成本降低了十分之一。随着底层堆栈的不断改进,这些巨大的性能提升仍在持续扩大。

NVIDIA TensorRT-LLM、NVIDIA Dynamo、Mooncake和SGLang团队的持续优化,继续显著提高了Blackwell NVL72在所有延迟目标下对混合专家模型(MoE)推理的吞吐量。例如,与四个月前相比,仅TensorRT-LLM库的改进就使GB200在低延迟工作负载上的性能提升了高达5倍。

- 更高性能的GPU内核:针对效率和低延迟进行了优化,有助于充分利用Blackwell巨大的计算能力并提高吞吐量。

- NVIDIA NVLink对称内存:支持直接的GPU到GPU内存访问,实现更高效的通信。

- 程序化依赖启动:在先前内核完成之前启动下一个内核的设置阶段,最大限度地减少空闲时间。

在这些软件进步的基础上,采用Blackwell Ultra GPU的GB300 NVL72将吞吐量/兆瓦的前沿推至与Hopper平台相比50倍的水平。

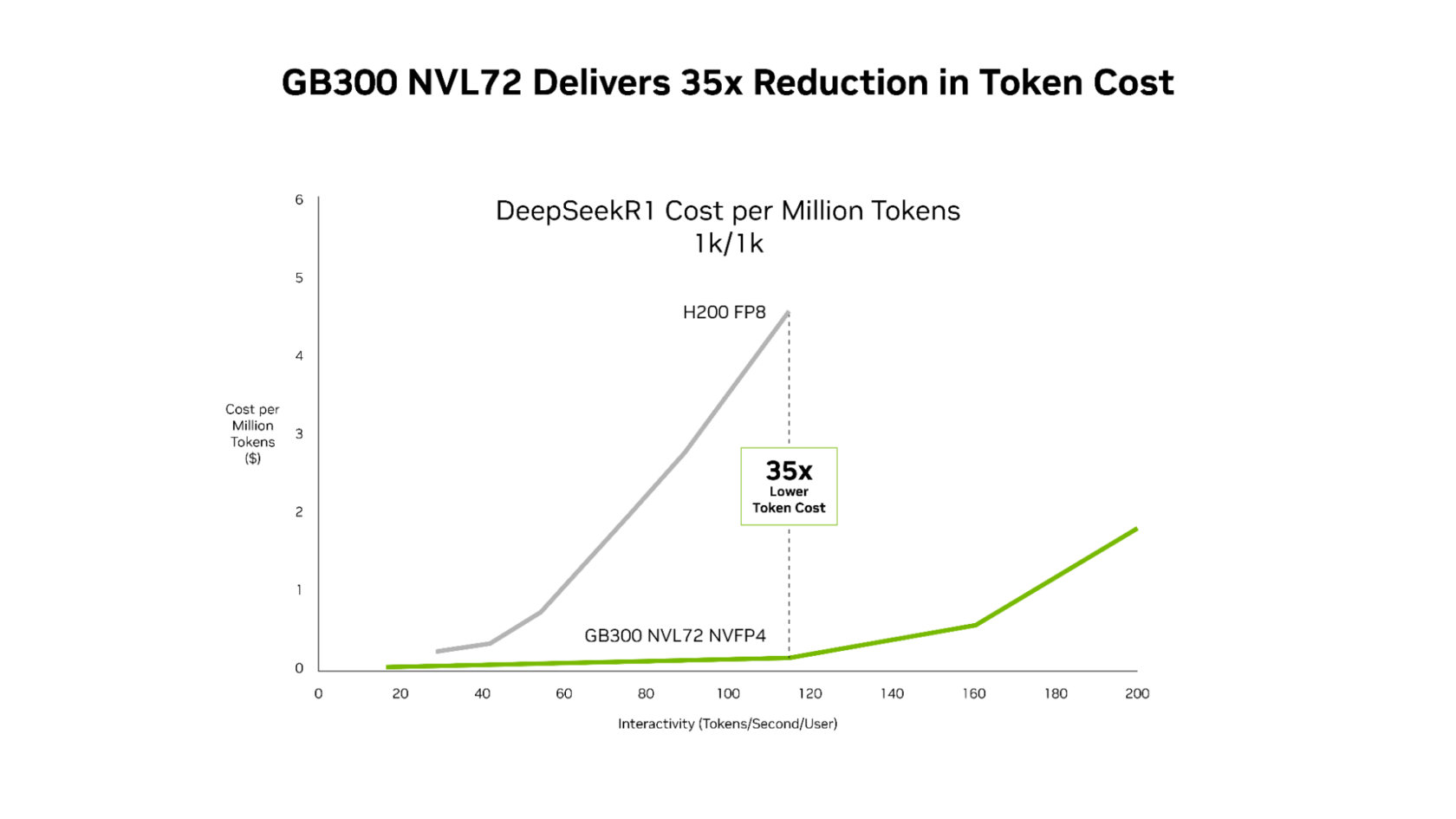

这种性能增益转化为更优越的经济效益,NVIDIA GB300 在整个延迟范围内都比Hopper平台更具成本优势。成本削减最为显著的发生在智能体应用运行的低延迟场景:与Hopper平台相比,每百万Token的成本降低高达35倍。

对于在多步骤工作流程中每一毫秒都很关键的智能体编码和交互式助手工作负载而言,这种不懈的软件优化与下一代硬件的结合,使AI平台能够将实时交互体验扩展到更多用户。

GB300 NVL72为长上下文工作负载提供卓越的经济效益

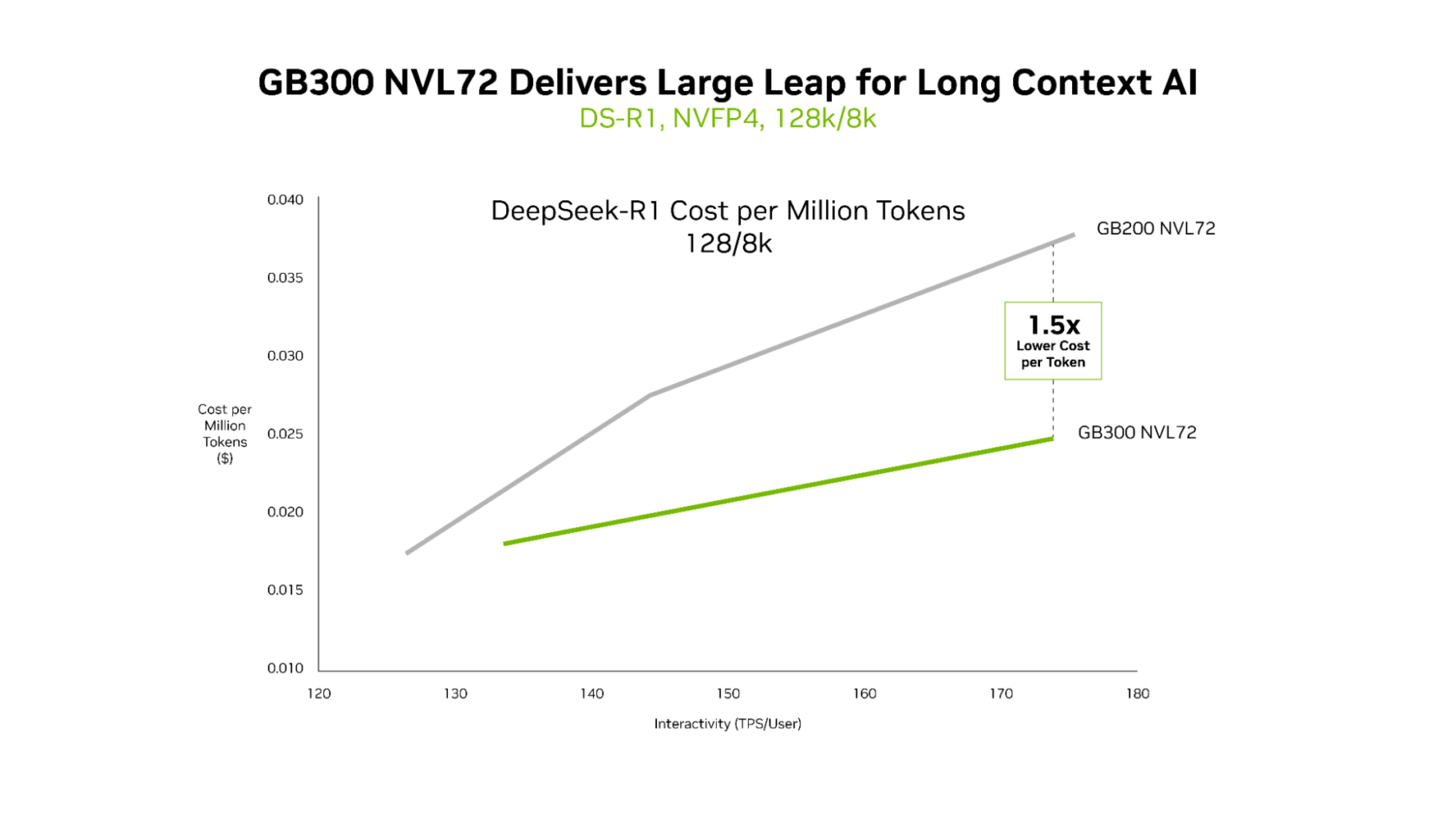

虽然GB200 NVL72和GB300 NVL72都能高效地提供超低延迟,但GB300 NVL72的独特优势在长上下文场景中最为明显。对于输入128,000个Token、输出8,000个Token的工作负载(例如跨代码库进行推理的AI编码助手),与GB200 NVL72相比,GB300 NVL72可将每Token成本降低高达1.5倍。

随着智能体读取更多代码,上下文会增长。这使其能够更好地理解代码库,但也需要更多的计算资源。Blackwell Ultra拥有1.5倍的NVFP4计算性能和2倍的更快注意力处理能力,使智能体能够有效地理解整个代码库。

智能体AI的基础设施

领先的云提供商和AI创新者已经大规模部署了NVIDIA GB200 NVL72,并且也正在生产环境中部署GB300 NVL72。微软、CoreWeave和OCI正在为智能体编码和编码助手等低延迟和长上下文用例部署GB300 NVL72。通过降低Token成本,GB300 NVL72促成了一类新型应用,这些应用能够实时推理海量代码库。

CoreWeave工程高级副总裁Chen Goldberg表示:“随着推理成为AI生产的中心,长上下文性能和Token效率变得至关重要。”“Grace Blackwell NVL72直接解决了这一挑战,CoreWeave的AI云(包括CKS和SUNK)旨在将GB300系统的优势转化为可预测的性能和成本效率,这建立在GB200的成功之上。结果是更好的Token经济效益和为大规模运行工作负载的客户提供更实用的推理能力。”

NVIDIA Vera Rubin NVL72将带来下一代性能

随着NVIDIA Blackwell系统的规模化部署,持续的软件优化将继续为现有设备释放额外的性能和成本改进。

展望未来,NVIDIA Rubin平台——它将六个新芯片组合成一台AI超级计算机——有望带来新一轮的巨大性能飞跃。对于MoE推理,它相比Blackwell可提供高达10倍的每兆瓦吞吐量,即每百万Token成本降低十分之一。对于下一波前沿AI模型,Rubin使用比Blackwell少四分之一的GPU数量即可训练大型MoE模型。

了解有关NVIDIA Rubin平台和Vera Rubin NVL72系统的更多信息。

🚀 想要体验更好更全面的AI调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,文档丰富,小白也可以简单操作。

评论区