📢 转载信息

原文链接:https://blogs.nvidia.com/blog/h100-coreweave-graph500/

原文作者:Prachi Goel

在全球顶级的图处理扩展性系统中,一个基于商用集群构建的系统刷新了纪录。

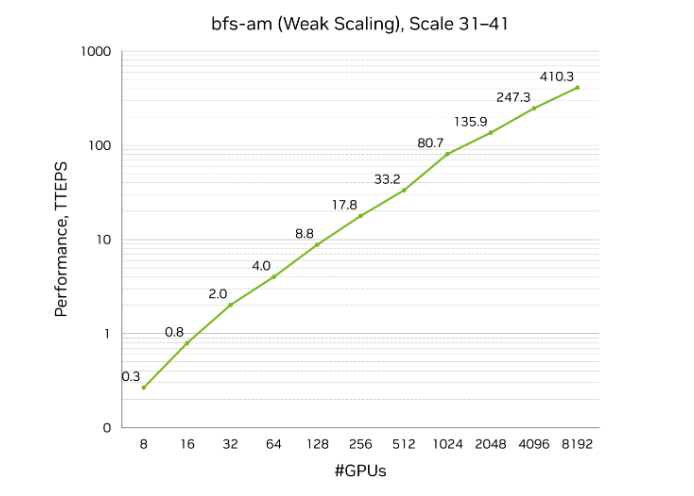

上个月,NVIDIA 宣布在第 31 届 Graph500 广度优先搜索(BFS)榜单上取得了创纪录的成绩:每秒 410 万亿次遍历边数(TEPS),排名第一。

这次运行是在 CoreWeave 位于达拉斯的数据中心托管的加速计算集群上进行的,使用了 8,192 个 NVIDIA H100 GPU 来处理一个包含 2.2 万亿个顶点和 35 万亿条边的图。该结果比包括国家实验室托管的方案在内的同类解决方案的性能高出一倍以上。

为了形象说明这一性能,假设地球上的每个人都有 150 个好友。这将在社交关系图中代表 1.2 万亿条边。NVIDIA 和 CoreWeave 最近实现的性能水平,使得在短短大约三毫秒内就能搜索完地球上所有人的好友关系。

在这个规模下,速度只是故事的一半——真正的突破在于效率。Graph500 榜单前十名中一个可比较的条目使用了大约 9,000 个节点,而 NVIDIA 的获胜运行仅使用了略多于 1,000 个节点,实现了 3 倍的每美元性能提升。

NVIDIA 充分利用了其全栈计算、网络和软件技术的组合能力——包括 NVIDIA CUDA 平台、Spectrum-X 网络、H100 GPU 和一种新的活动消息库——在最小化硬件占地面积的同时,将性能推向了极限。

通过在商用系统中以这种规模节省大量时间和成本,此次胜利证明了 NVIDIA 计算平台已准备好让全球最大的稀疏、不规则工作负载(涉及大小各异且不可预测的数据和工作项)的加速普及化,而不仅仅是像 AI 训练这样的密集型工作负载。

大规模图是如何工作的

图是现代信息技术的底层信息结构。人们每天都在社交网络和银行应用等多种场景中与之交互。图捕获了海量信息网络中信息片段之间的关系。

例如,以领英(LinkedIn)为例。一个用户的个人资料就是一个顶点。与其他用户的连接或关系就是边——其他用户则表示为顶点。有些用户有五个连接,而另一些用户有五万个。这在图结构中产生了可变的密度,使其变得稀疏且不规则。与结构化和密集的图像或语言模型不同,图是不可预测的。

Graph500 BFS 作为行业标准的基准测试有着悠久的历史,因为它衡量了系统在规模上驾驭这种不规则性的能力。

BFS 衡量了遍历图中每个顶点和边的速度。BFS 的高 TEPS 分数(衡量系统处理这些边的速度)证明了系统具有卓越的互连性,例如计算节点之间的电缆或交换机,以及更多的内存带宽和能够利用系统能力的软件。它验证了整个系统的工程设计,而不仅仅是 CPU 或 GPU 的速度。

有效地,它是衡量一个系统能多快地“思考”并将不相关的信息片段关联起来的指标。

当前处理图的技术

GPU 以加速 AI 训练等密集型工作负载而闻名。直到最近,最大的稀疏线性代数和图工作负载仍然是传统 CPU 架构的领域。

为了处理图,CPU 会在计算节点之间移动图数据。随着图扩展到数万亿条边,这种持续的数据移动会产生瓶颈并阻塞通信。

开发人员使用各种软件技术来规避这个问题。一种常见的方法是在数据所在的位置进行处理,使用活动消息(active messages),开发人员发送消息可以在原地处理图数据。这些消息更小,可以分组以最大限度地提高网络效率。

虽然这种软件技术显著加速了处理过程,但活动消息是为在 CPU 上运行而设计的,其性能受到 CPU 系统吞吐率和计算能力的固有限制。

为 GPU 重塑图处理

为了加速 BFS 运行,NVIDIA 设计了一个完全基于 GPU 的全栈解决方案,重新构想了数据在网络上传输的方式。

使用 InfiniBand GPUDirect Async (IBGDA) 和 NVSHMEM 并行编程接口开发的定制软件框架,实现了 GPU 到 GPU 的活动消息传递。

通过 IBGDA,GPU 可以直接与 InfiniBand 网络接口卡通信。消息聚合功能是从头开始设计的,以支持数十万个 GPU 线程同时发送活动消息,相比之下,CPU 只能支持数百个线程。

因此,在这个重新设计的系统中,活动消息完全在 GPU 上运行,绕过了 CPU。

这使得可以充分利用 NVIDIA H100 GPU 巨大的并行处理能力和内存带宽来发送消息、通过网络传输它们并在接收端进行处理。

在 NVIDIA 合作伙伴 CoreWeave 稳定、高性能的基础设施上运行,这种编排使得在只使用一小部分硬件的情况下,实现了可比较运行性能的两倍提升——而且成本也大大降低。

加速新的工作负载

这一突破对高性能计算具有巨大的影响。像流体动力学和天气预报这样的 HPC 领域依赖于与驱动社交网络和网络安全的图相似的稀疏数据结构和通信模式。

几十年来,即使数据规模从数十亿条边扩展到数万亿条边,这些领域在最大规模上一直受制于 CPU。NVIDIA 在 Graph500 上的获胜结果,以及另外两个进入前十名的成绩,验证了一种针对大规模高性能计算的新方法。

借助 NVIDIA 计算、网络和软件的全栈编排能力,开发人员现在可以使用 NVSHMEM 和 IBGDA 等技术来高效扩展他们最大的 HPC 应用,将超级计算性能带到商用基础设施上。

随时了解最新的 Graph500 基准测试,并了解更多关于 NVIDIA 网络技术的信息。

🚀 想要体验更好更全面的AI调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,文档丰富,小白也可以简单操作。

评论区