📢 转载信息

原文链接:https://www.ifanr.com/1641130?utm_source=rss&utm_medium=rss&utm_campaign=

原文作者:ifanr

在人工智能日益普及的今天,用户对AI的体验反馈却常常呈现出两极分化:简单问题瞬时回复但价值有限,而复杂问题的深度思考则伴随着高延迟和高昂的Token消耗。对于企业而言,Token的消耗量直接关系到运营成本,如何在追求高质量效果与控制成本之间找到平衡点,一直是整个行业面临的难题。

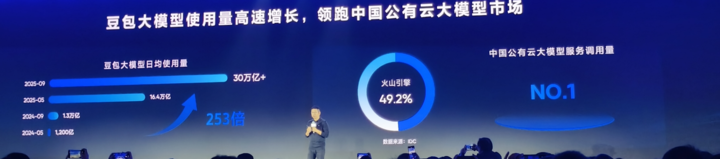

AI需求的爆发式增长使得这一矛盾更加突出。例如,豆包大模型日均Token调用量已突破30万亿,比5月暴涨超80%。面对这种趋势,企业要么牺牲效果选择轻量模型,要么咬牙烧钱使用顶级模型。这提出了一个核心拷问:是要效果,还是要成本?

火山引擎的创新:解决“鱼与熊掌不可兼得”的难题

10月16日,在武汉FORCE LINK AI创新巡展上,火山引擎用四款新品给出了明确的答案:选择不必二选一。

1. 豆包大模型1.6:原生支持“分档调节思考长度”

豆包大模型1.6是国内首个原生支持四档思考长度调节(Minimal、Low、Medium、High)的模型。这相当于为AI装上了一个“智能变速器”:

- **简单查询**:使用Minimal档位,可显著节省Token和时间。相比升级前,低思考档位能直接削减77.5%的总输出Tokens和84.6%的思考时间,而效果保持不变。

- **复杂推理**:切换至High档位,确保深度思考效果。

企业可以根据具体场景灵活平衡效果、时延和成本,大幅提升了思考效率。

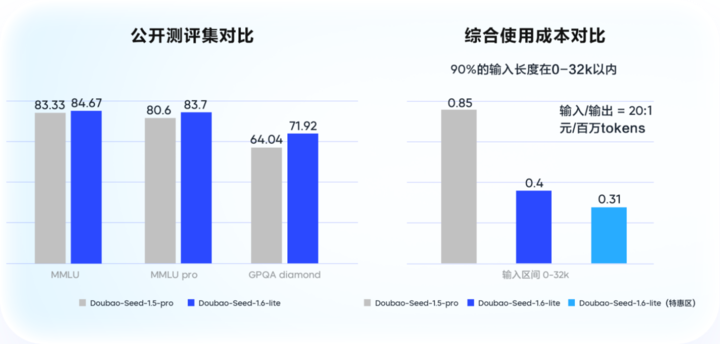

2. 豆包大模型1.6 lite:成本腰斩,效果提升

火山引擎同步推出了更轻量、推理更快的豆包大模型1.6 lite。在效果上,该模型超越了豆包1.5 Pro,在企业级场景测评中提升了14%。更引人注目的是,在0-32k输入区间内,其综合使用成本较豆包1.5 Pro狂降53.3%。这种“单位Token价值密度”的提升,意味着每一分钱都花在了刀刃上。

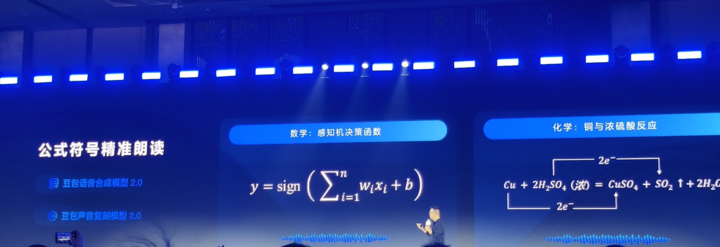

语音交互的重大突破:复杂公式朗读准确率飙升至90%

随着语音成为AI核心交互方式,火山引擎发布了豆包语音合成模型2.0和声音复刻模型2.0。此次升级的亮点在于,它们终于能准确朗读复杂公式。

此前,市面上同类模型在朗读复杂公式和符号时的准确率普遍低于50%。新模型经过针对性优化后,在小学到高中全学科的复杂公式朗读准确率直接飙升至90%。

这得益于基于豆包大语言模型研发的全新语音合成架构,使得声音具备深度语义理解能力,并支持上下文推理。用户可以通过自然语言精准控制语速、情绪、声线等,例如:“来点温柔的感觉”或“读得激动点”,实现前所未有的语音可控性。

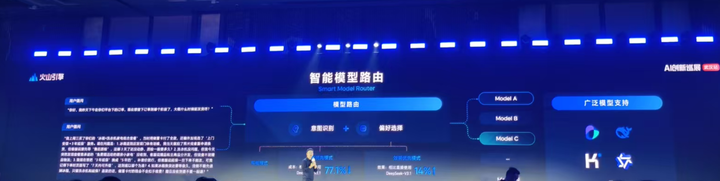

智能模型路由:为AI选择“千瓦时”

面对市场上琳琅满目的模型,如何选择最性价比的方案成为企业的新难题。火山引擎发布了国内首个针对模型智能选择的解决方案——智能模型路由(Smart Model Router)。

该功能支持“平衡模式”、“效果优先模式”和“成本优先模式”三种方案,能根据任务请求自动选择最合适的模型,本质上是让AI判断“这个任务值得烧多少Token”。

实测数据显示,在成本优先模式下,智能路由能实现在保持DeepSeek-V3.1相似效果的条件下,综合成本最高下降超70%。

火山引擎指出,Token正成为AI时代的“千瓦时”。智能模型路由的出现,将形成一个正向循环:更强能力解锁新场景 → 消耗量增长倒逼智能路由优化 → 成本降低释放更多需求弹性。最终目标是让用户不仅“用得起”,更要“用得好”。

🚀 想要体验更好更全面的AI调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,文档丰富,小白也可以简单操作。

评论区