📢 转载信息

原文链接:https://www.kdnuggets.com/the-complete-hugging-face-primer-for-2026

原文作者:Shittu Olumide

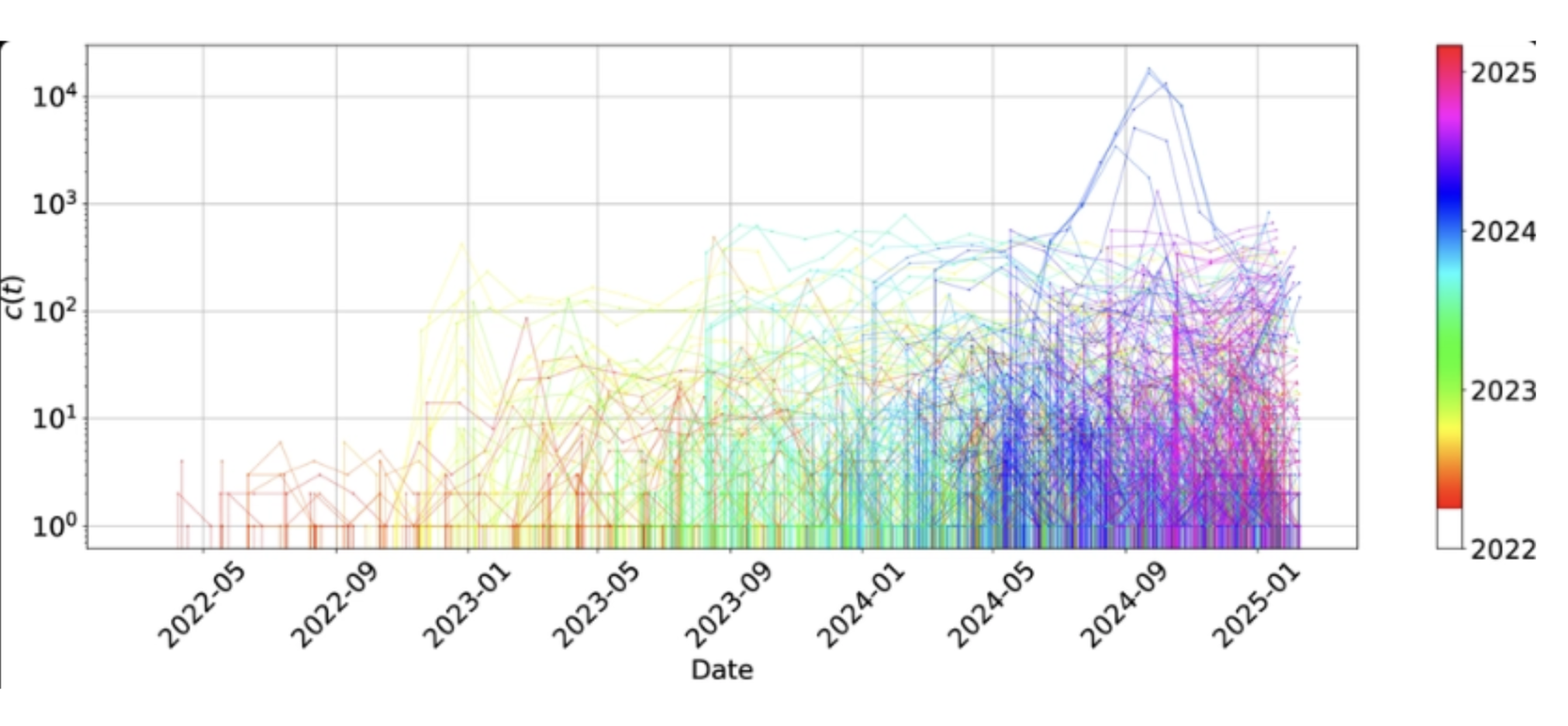

Image by Author

Hugging Face 重新介绍

在本教程结束时,您将了解并理解 Hugging Face 在现代机器学习中的重要性,探索其生态系统,并设置本地开发环境,开始您的机器学习实践之旅。您还将了解 Hugging Face 对所有人都是免费的,并发现它为初学者和专家提供的工具。但首先,让我们了解一下 Hugging Face 的核心理念。

Hugging Face 是一个 AI 在线社区,它已成为从事人工智能和机器学习的任何人的基石,使研究人员、开发人员和组织能够以以前无法企及的方式利用机器学习。

将 Hugging Face 视为一个装满世界各地最佳作者所写书籍的图书馆。您无需自己编写书籍,可以借阅一本,理解它,并用它来解决问题——无论是总结文章、翻译文本还是对电子邮件进行分类。

以类似的方式,Hugging Face 充满了来自世界各地的研究人员和开发人员编写的机器学习和 AI 模型,您可以下载并在本地机器上运行它们。您也可以直接使用 Hugging Face API 来使用这些模型,而无需昂贵的硬件。

如今,Hugging Face Hub 托管着数百万个预训练模型、数十万个数据集以及大量的演示应用程序,所有这些都由全球社区贡献。

追溯 Hugging Face 的起源

Hugging Face 由法国企业家 Clement Delangue、Julien Chaumond 和 Thomas Wolf 创立。他们最初的目标是构建一个支持聊天的机器人,但后来发现开发人员和研究人员在访问预训练模型和实现尖端算法时遇到了困难。随后,Hugging Face 转向创建用于机器学习工作流程的工具和开源机器学习平台。

Image by Author

参与 Hugging Face 开源 AI 社区

Hugging Face 位于提供 AI 工作流程所需一切工具和资源的中心。Hugging Face 为 AI 提供了所有这些工具和资源。Hugging Face 不仅仅是一家公司,更是推动 AI 时代发展的全球社区。

Hugging Face 提供了一套工具,例如:

- Transformers 库: 用于访问跨任务(如文本分类和摘要等)的预训练模型。

- Dataset 库: 提供对精选自然语言处理 (NLP)、视觉和音频数据集的轻松访问。这可以节省您的时间,让您不必从头开始。

- 模型中心 (Model Hub): 这是研究人员和开发人员共享并为您提供测试和下载任何项目所需的预训练模型的地方。

- Spaces: 您可以在这里使用 Gradio 和 Streamlit 构建和托管您的演示。

真正将 Hugging Face 与其他 AI 和机器学习平台区分开来的是其开源方法,它允许来自世界各地的研究人员和开发人员为 AI 社区做出贡献、开发和改进。

解决关键的机器学习挑战

机器学习具有变革性,但多年来也面临着一些挑战。这包括从头开始训练大规模模型需要巨大的计算资源,这些资源成本高昂且大多数个人无法获得。准备数据集、调整模型架构并将模型部署到生产环境非常复杂。

Hugging Face 通过以下方式解决这些挑战:

- 通过预训练模型降低计算成本。

- 通过直观的 API 简化机器学习。

- 通过中央存储库促进协作。

Hugging Face 通过多种方式减少了这些挑战。通过提供预训练模型,开发人员可以跳过昂贵的训练阶段,并立即开始使用最先进的模型。

Transformers 库提供了易于使用的 API,允许您仅用几行代码即可实现复杂的机器学习任务。此外,Hugging Face 作为一个中央存储库,促进了模型和数据集的无缝共享、协作和发现。

最终,我们实现了 AI 的民主化,无论种族或资源如何,任何人都可以构建和部署机器学习解决方案。这就是为什么 Hugging Face 被包括 Microsoft、Google、Meta 等在内的各行各业所接受,并在其工作流程中集成它。

探索 Hugging Face 生态系统

Hugging Face 的生态系统非常广泛,包含了许多集成的组件,支持 AI 工作流程的完整生命周期:

导航 Hugging Face Hub

- AI 制品的中央存储库:模型、数据集和应用程序 (Spaces)。

- 支持公共和私有托管,具备版本控制、元数据和文档。

- 用户可以上传、下载、搜索和基准测试 AI 资源。

首先,请在浏览器中访问 Hugging Face 网站。主页展示了一个简洁的界面,并提供了探索模型、数据集和 Spaces 的选项。

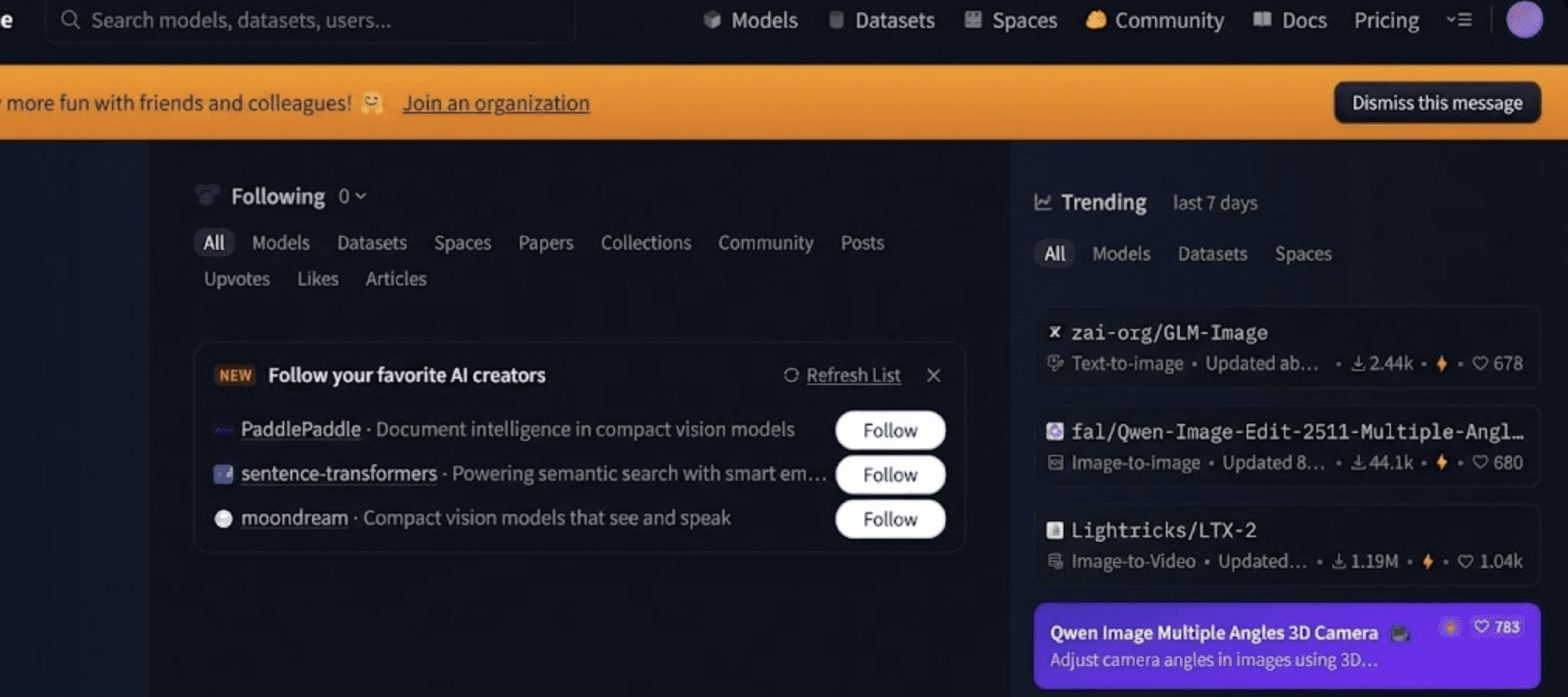

Image by Author

处理模型

模型部分是 Hugging Face Hub 的中心。它提供了跨多种机器学习任务的数千个预训练模型,使您无需从头开始构建所有内容,即可利用预训练模型来完成文本分类、摘要和图像识别等任务。

Image by Author

- 数据集:用于训练和评估模型的即用型数据集。

- Spaces:使用 Gradio 和 Streamlit 等工具创建的交互式演示和应用。

利用 Transformers 库

Transformers 库是旗舰级的开源 SDK,它标准化了 Transformer 模型在 NLP、计算机视觉、音频和多模态学习等任务中的推理和训练方式。它:

- 支持超过数千种模型架构(例如 BERT、GPT、T5、ViT)。

- 为常见任务提供 Pipelines(管道),包括文本生成、分类、问答和视觉。

- 与 PyTorch、TensorFlow 和 JAX 集成,实现灵活的训练和推理。

访问 Datasets 库

Datasets 库提供了用于发现、加载和预处理 Hub 上数据集的工具:

- 发现、加载和预处理来自 Hub 的数据集。

- 通过流式传输、过滤和转换功能处理大型数据集。

- 高效管理训练、评估和测试分割。

该库使跨语言和任务使用真实世界数据进行实验变得更加容易,而无需复杂的数据工程。

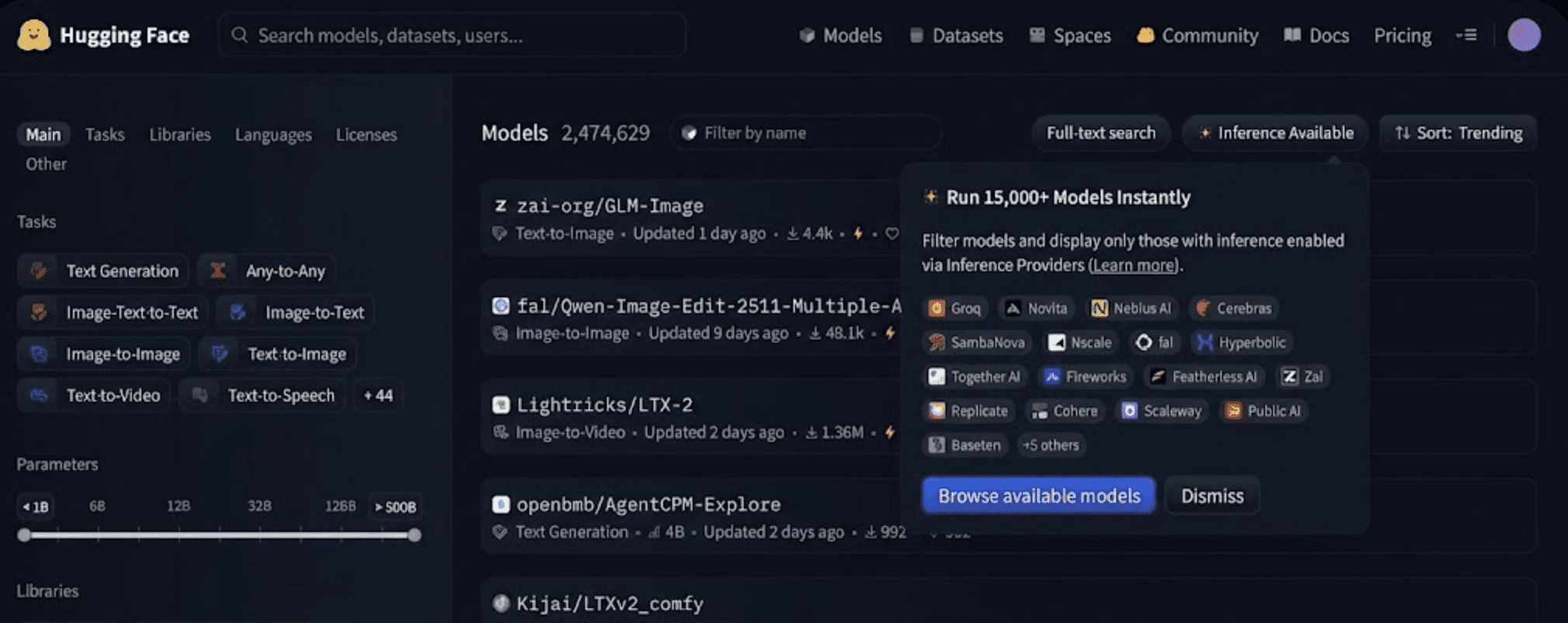

Image by Author

Hugging Face 还维护了几个补充模型训练和部署的辅助库:

- Diffusers:用于使用扩散技术的生成式图像/视频模型。

- Tokenizers:用 Rust 编写的超快分词实现。

- PEFT:参数高效微调方法(LoRA, QLoRA)。

- Accelerate:简化分布式和高性能训练。

- Transformers.js:支持直接在浏览器或 Node.js 中进行模型推理。

- TRL (Transformers Reinforcement Learning):用于使用强化学习方法训练语言模型的工具。

使用 Spaces 构建应用

Spaces 是轻量级的交互式应用程序,用于展示模型和演示,通常使用 Gradio 或 Streamlit 等框架构建。它们允许开发人员:

- 以最少的基础设施部署机器学习演示。

- 共享用于文本生成、图像编辑、语义搜索等的交互式可视化工具。

- 在不编写后端服务的情况下进行视觉实验。

Image by Author

利用部署和生产工具

除了开源库之外,Hugging Face 还提供生产级服务,例如:

- Inference API:这些 API 支持通过 REST API 进行托管的模型推理,无需预配服务器,并且还支持扩展模型(包括大型语言模型)以用于实时应用程序。

- Inference Endpoints:用于管理 GPU/TPU 端点,使团队能够在具备监控和日志记录的情况下大规模服务模型。

- 云集成:Hugging Face 与 AWS、Azure 和 Google Cloud 等主流云提供商集成,使企业团队能够在现有云基础设施内部署模型。

遵循简化的技术工作流程

以下是 Hugging Face 上典型的开发人员工作流程:

- 在 Hub 上搜索并选择一个预训练模型。

- 使用

Transformers在本地或云笔记本中加载和微调。 - 将微调后的模型和数据集版本化后上传回 Hub。

- 使用 Inference API 或 Inference Endpoints 进行部署。

- 通过 Spaces 分享演示。

此工作流程极大地加速了原型设计、实验和生产开发。

使用 Gradio 创建交互式演示

import gradio as gr from transformers import pipeline classifier = pipeline("sentiment-analysis") def predict(text): result = classifier(text)[0] # extract first item return {result["label"]: result["score"]} demo = gr.Interface( fn=predict, inputs=gr.Textbox(label="Enter text"), outputs=gr.Label(label="Sentiment"), title="Sentiment Analysis Demo" ) demo.launch()

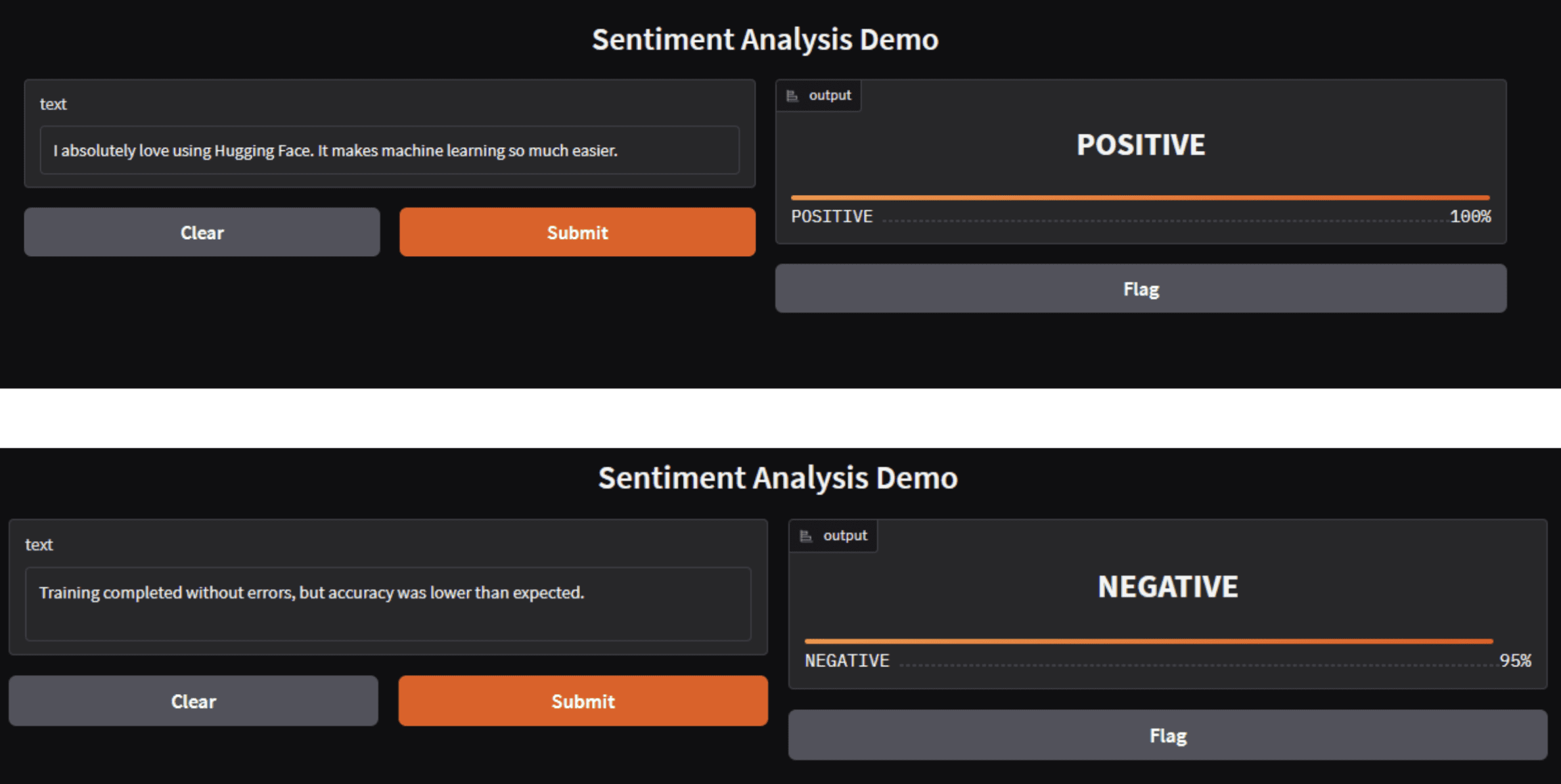

您可以通过运行 python 加上文件名来运行此代码。在我的例子中是 python demo.py,它允许下载,您将看到如下内容。

Image by Author

同一个应用可以直接作为 Hugging Face Space 部署。

请注意,Hugging Face

pipelines返回的预测结果是列表,即使输入是单个样本。当与 Gradio 的 Label 组件集成时,您必须提取第一个结果并返回字符串标签或将标签映射到置信度分数的字典。未实现此操作将导致输出类型不匹配而引发 ValueError。

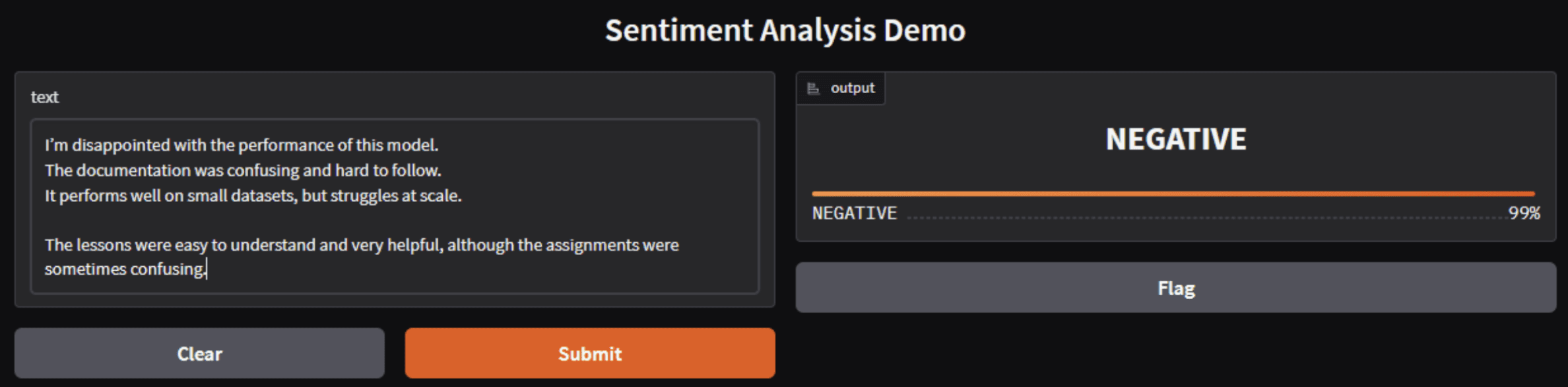

Image by Author

Hugging Face 的情感模型对整体情绪基调进行分类,而不是对个人观点进行分类。当负面信号强于或多于正面信号时,即使存在一些正面反馈,模型也会自信地预测负面情绪。

您可能想知道开发人员和组织为何使用 Hugging Face;以下是一些原因:

- 标准化:Hugging Face 提供了一致的 API 和接口,规范了模型在不同语言和任务中的共享和消费方式。

- 社区协作:平台的开放治理鼓励研究人员、教育工作者和行业开发人员的贡献,加速创新并实现社区驱动的模型和数据集改进。

- 民主化:通过提供易于使用的工具和现成的模型,AI 开发对没有大量计算资源的学习者和组织来说变得更加容易。

- 企业级解决方案:Hugging Face 提供企业功能,例如私有模型中心、基于角色的访问控制以及对受监管行业重要的平台支持。

考虑挑战和局限性

虽然 Hugging Face 简化了机器学习生命周期的许多部分,但开发人员应注意:

- 文档复杂性:随着工具的增长,文档深度各不相同;一些高级功能可能需要深入研究才能正确理解。(社区反馈指出生态系统部分文档质量参差不齐)。

- 模型发现:由于 Hub 上有数百万个模型,找到合适的模型通常需要仔细的筛选和语义搜索方法。

- 道德和许可:开放存储库可能会引发内容使用和许可挑战,特别是对于可能包含专有或受版权保护内容的用户上传的数据集。有效治理以及对许可证和预期用途进行明确标记至关重要。

结论

在 2026 年,Hugging Face 是开放 AI 开发的基石,提供了一个涵盖研究和生产的丰富生态系统。它将社区贡献、开源工具、托管服务和协作工作流程相结合,重塑了开发人员和组织处理机器学习的方式。无论您是训练尖端模型、部署 AI 应用程序,还是参与全球研究工作,Hugging Face 都提供了加速创新的基础设施和社区支持。

Shittu Olumide 是一位软件工程师和技术作家,热衷于利用尖端技术来构建引人入胜的叙事,对细节有敏锐的洞察力,并擅长简化复杂概念。您也可以在 Twitter 上找到 Shittu。

🚀 想要体验更好更全面的AI调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,文档丰富,小白也可以简单操作。

评论区