📢 转载信息

原文作者:Microsoft Research

在今天的技术领域,大规模视觉和听觉数据的普及对人工智能系统提出了前所未有的挑战。这些系统不仅需要处理海量的单模态信息,还需要在这些异构数据源之间建立复杂的联系以进行有效的推理。我们很高兴地宣布推出 MMCTAgent,这是一个新颖的框架,旨在实现对大规模视频和图像集合的模态推理(Multimodal Reasoning)。

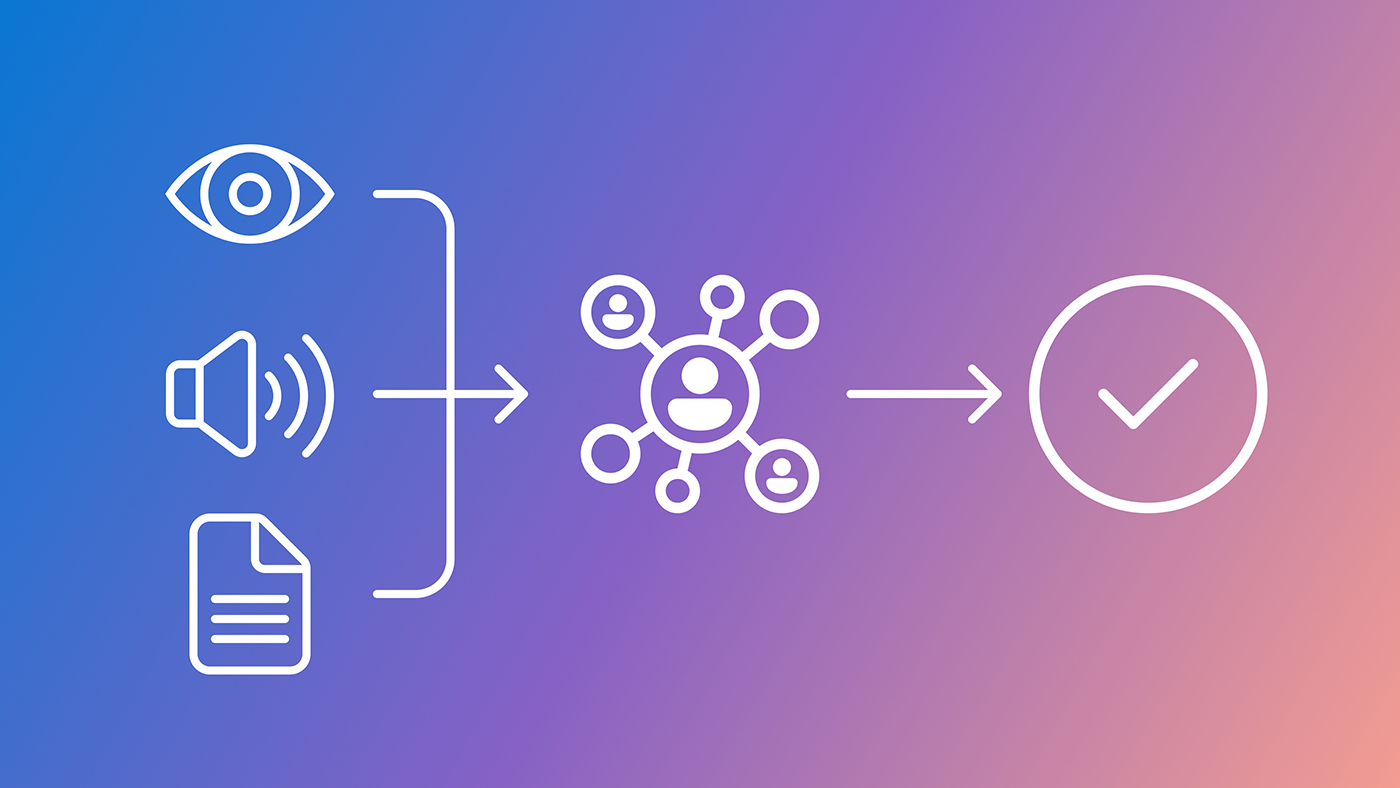

MMCTAgent 的核心目标是弥合视觉、听觉和文本(文档)信息之间的语义鸿沟,从而使AI代理能够执行需要跨多种感官输入进行综合理解和决策的任务。

关键创新:多模态信息聚合

传统的多模态模型通常侧重于成对模态的融合(例如,视觉-文本)。然而,现实世界中的复杂场景往往涉及视觉内容、环境声音和相关的文档描述或元数据。MMCTAgent 通过引入一个统一的表示空间来解决这个问题。

该框架设计用于高效地处理和整合来自不同来源的数据流:

- 视觉输入:处理来自视频帧和静态图像的高级特征。

- 听觉输入:从音频流中提取上下文相关的信息(如语音、环境音效)。

- 文档输入:整合相关的文字描述、字幕或背景文档。

通过这种聚合方式,MMCTAgent 能够构建一个更丰富、更完整的场景理解模型,这对于需要精确上下文判断的应用至关重要。

实现跨模态推理

MMCTAgent 的真正价值在于其强大的推理能力。一旦信息被统一表示,代理就可以执行复杂的查询和决策制定,例如:

- 情景问答 (Contextual QA):回答关于视频中“某人说了什么”以及“当时周围有什么声音”的问题,并参考相关的操作手册(文档)。

- 事件溯源:根据观察到的视觉变化和声音提示,快速定位相关的文件记录。

- 复杂任务规划:在机器人学或自动化流程中,结合环境的实时视觉和听觉反馈来指导行动。

我们通过在多个基准测试集上进行评估,证明了 MMCTAgent 在需要深层模态交叉推理的任务上,显著优于现有的SOTA(State-of-the-Art)模型。

未来展望

MMCTAgent 标志着AI代理能力向更接近人类多感官处理方向迈进的重要一步。我们相信,这种对大规模、异构数据集合进行统一推理的能力,将为未来的多模态AI应用打开新的大门,尤其是在需要高可靠性和细致理解的领域,如安全监控、复杂系统诊断和沉浸式教育体验。

🚀 想要体验更好更全面的AI调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,文档丰富,小白也可以简单操作。

评论区