📢 转载信息

原文作者:Daniel Duplessis, Dan MacKay, Sharadha Kandasubramanian, Melanie Li, Serge Malikov, and Saurabh Trikande

生成式AI为加拿大组织转型运营和客户体验创造了前所未有的机会。我们很高兴地宣布,加拿大客户现在可以通过跨区域推理(CRIS),在Amazon Bedrock上访问包括Anthropic的Claude 3.5 Sonnet和Claude 3.5 Haiku在内的先进基础模型。

本文将探讨加拿大组织如何利用加拿大(中部)区域的跨区域推理配置文件来获取最新的基础模型,以加速AI计划。我们将演示如何开始使用这些新功能,提供从旧模型迁移的指导,并分享配额管理的推荐实践。

加拿大跨区域推理:您通往全球AI创新的门户

为了帮助客户实现生成式AI应用的规模化,Amazon Bedrock提供了 跨区域推理(CRIS)配置文件,这是一项强大的功能,使组织能够跨多个AWS区域无缝分配推理处理工作。这项能力有助于您在构建规模化应用时获得更高的吞吐量,确保即使在重负载下,您的生成式AI应用也能保持响应性和可靠性。

Amazon Bedrock提供两种类型的跨区域推理配置文件:

- 地理CRIS: Amazon Bedrock会自动选择该地理区域内最优的商业区域来处理您的推理请求。

- 全球CRIS: 全球CRIS通过允许将推理请求路由到全球支持的商业区域,进一步增强了跨区域推理能力,优化了可用资源,并实现了更高的模型吞吐量。

跨区域推理通过安全的AWS网络运行,对传输中和静态存储中的数据进行端到端加密。当客户从加拿大(中部)区域提交推理请求时,CRIS会智能地将请求路由到为推理配置文件配置的目的地区域之一(美国或全球配置文件)。

关键区别在于:虽然推理处理(瞬态计算)可能发生在另一个区域,但所有静态数据——包括日志、知识库和任何存储的配置——都将完全保留在加拿大(中部)区域内。推理请求通过AWS全球网络传输,绝不经过公共互联网,响应会加密返回到您在加拿大的应用程序。

加拿大的跨区域推理配置

借助CRIS,加拿大组织可以更早地使用基础模型,包括具有增强推理能力的尖端模型,如Claude 3.5 Sonnet,从而更快地实现创新。CRIS还通过提供对多个区域容量的访问来提高容量和性能。这使得在税务季、黑色星期五和假日购物等高峰期能够实现更高的吞吐量,自动处理突发流量而无需人工干预,并通过更大的资源池来提供更高的弹性。

加拿大客户可以根据其需求在以下两种推理配置文件类型之间进行选择:

| CRIS 配置文件 | 源区域 | 目标区域 | 描述 |

| 美国跨区域推理 | ca-central-1 |

多个美国区域 | 来自加拿大的请求可以路由到具有可用容量的受支持的美国区域。 |

| 全球推理 | ca-central-1 |

全球AWS区域 | 来自加拿大的请求可以路由到AWS全球CRIS配置文件中的某个区域。 |

从加拿大开始使用CRIS

要开始从加拿大使用跨区域推理,请遵循以下步骤:

配置AWS身份和访问管理(IAM)权限

首先,验证您的IAM角色或用户是否具有使用跨区域推理配置文件调用Amazon Bedrock模型的必要权限。

以下是美国跨区域推理策略的示例:

{ "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "bedrock:InvokeModel*" ], "Resource": [ "arn:aws:bedrock:ca-central-1::inference-profile/us.anthropic.claude-sonnet-4-5-20250929-v1:0" ] }, { "Effect": "Allow", "Action": [ "bedrock:InvokeModel*" ], "Resource": [ "arn:aws:bedrock:*::foundation-model/anthropic.claude-sonnet-4-5-20250929-v1:0" ], "Condition": { "StringLike": { "bedrock:InferenceProfileArn": "arn:aws:bedrock:ca-central-1::inference-profile/us.anthropic.claude-sonnet-4-5-20250929-v1:0" } } } ]

有关全球CRIS的更多信息,请参阅博文,使用Amazon Bedrock上Anthropic Claude 3.5 Sonnet的新全球跨区域推理,解锁全球AI推理可伸缩性。

使用跨区域推理配置文件

配置您的应用程序以使用相关的推理配置文件ID。这些配置文件使用前缀来指示其路由范围:

| 模型 | 路由范围 | 推理配置文件ID |

| Claude Sonnet 4.5 | 美国区域 | us.anthropic.claude-sonnet-4-5-20250929-v1:0 |

| Claude Sonnet 4.5 | 全球 | global.anthropic.claude-sonnet-4-5-20250929-v1:0 |

| Claude Haiku 4.5 | 美国区域 | us.anthropic.claude-haiku-4-5-20251001-v1:0 |

| Claude Haiku 4.5 | 全球 | global.anthropic.claude-haiku-4-5-20251001-v1:0 |

示例代码

以下是如何从加拿大使用支持美国CRIS推理配置文件的Amazon Bedrock Converse API的示例:

import boto3 # 初始化Bedrock运行时客户端

bedrock_runtime = boto3.client( service_name="bedrock-runtime", region_name="ca-central-1" # 加拿大(中部)区域 )

# 定义推理配置文件ID

inference_profile_id = "us.anthropic.claude-sonnet-4-5-20250929-v1:0" # 准备对话

response = bedrock_runtime.converse( modelId=inference_profile_id, messages=[ { "role": "user", "content": [ { "text": "What are the benefits of using Amazon Bedrock for Canadian organizations?" } ] } ], inferenceConfig={ "maxTokens": 512, "temperature": 0.7 }

) # 打印响应

print(f"Response: {response['output']['message']['content'][0]['text']}")加拿大工作负载的配额管理

当从加拿大使用CRIS时,配额管理在源区域级别(ca-central-1)进行。这意味着为加拿大(中部)区域请求的配额增加适用于所有源自加拿大的推理请求,无论它们在哪里处理。

理解配额计算

重要提示: 在计算所需的配额增加时,您需要考虑燃尽率(burndown rate),即输入和输出令牌转换为限制系统令牌配额使用率的比率。以下模型对输出令牌具有 5 倍的燃尽率(1 个输出令牌消耗您配额中的 5 个令牌):

- Anthropic Claude Opus 4

- Anthropic Claude Sonnet 4.5

- Anthropic Claude Sonnet 4

- Anthropic Claude 3.7 Sonnet

对于其他模型,燃尽率为 1:1(1 个输出令牌消耗您配额中的 1 个令牌)。对于输入令牌,令牌与配额的比率为 1:1。每个请求的总令牌数计算如下:

输入令牌数 + 缓存写入输入令牌 + (输出令牌数 x 燃尽率)

请求配额增加

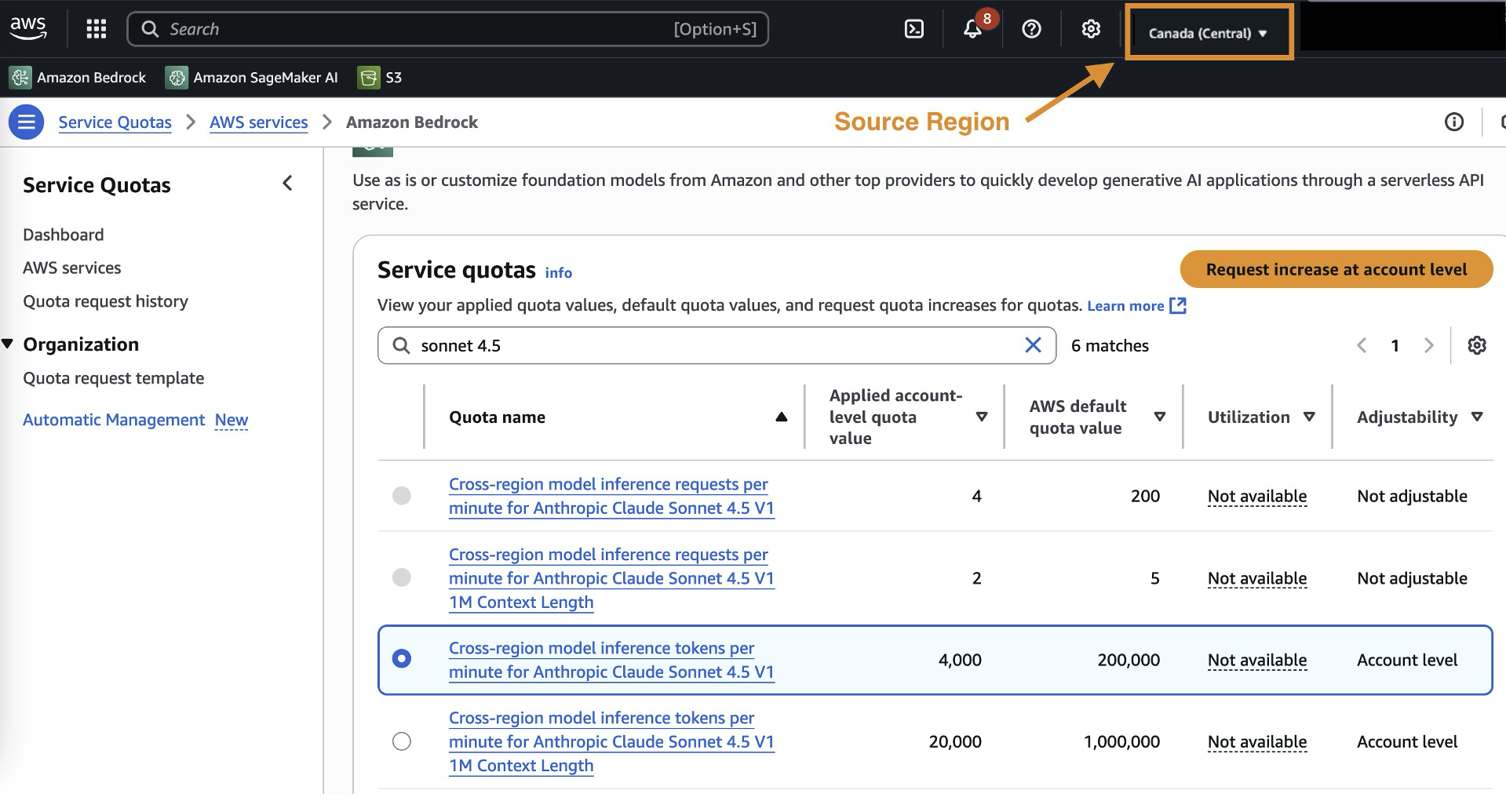

要请求加拿大CRIS的配额增加:

- 导航到加拿大(中部)区域的AWS 服务配额控制台

- 搜索特定的模型配额(例如,“Claude Sonnet 4.5 tokens per minute”)

- 根据您的预计使用情况提交增加请求

从旧版Claude模型迁移到Claude 4.5

目前使用旧版Claude模型的组织应规划迁移到Claude 4.5,以利用最新的模型能力。

要规划您的迁移策略,请纳入以下要素:

- 基准当前性能:建立现有模型的基准指标。

- 使用代表性工作负载进行测试并优化提示词:使用您的特定用例验证Claude 4.5的性能,并调整提示词以利用Claude 4.5的增强功能,并使用Bedrock提示词优化器工具。

- 实施分阶段推出:逐步转换流量。

- 监控和调整:跟踪性能指标并根据需要调整配额。

在美国和全球推理配置文件之间进行选择

在从加拿大实施CRIS时,组织可以根据其具体要求在美国和全球推理配置文件之间进行选择。

对于有现有美国数据处理协议、高吞吐量和弹性要求以及开发和测试环境的组织,建议使用美国跨区域推理。

结论

Amazon Bedrock的跨区域推理为希望在利用AI的同时保持数据治理的加拿大组织提供了机会。通过区分瞬态推理处理和持久数据存储,CRIS可以更快地访问最新的基础模型,而不会影响合规性要求。

通过CRIS,加拿大组织可以在几天而不是几个月内访问新模型。该系统在业务高峰期自动扩展,同时在加拿大境内保持完整的审计跟踪。这有助于您满足合规性要求,并使用与全球组织相同的先进AI功能。要开始使用,请审查您的数据治理要求并配置IAM权限。然后使用符合您需求的推理配置文件进行测试——美国配置文件可实现到美国区域的低延迟,而全球配置文件则可实现最大的容量。

关于作者

Daniel Duplessis 是亚马逊网络服务(AWS)的首席生成式AI专家解决方案架构师,他指导企业制定全面的AI实施策略,并建立跨企业扩展AI所需的基础能力。

Daniel Duplessis 是亚马逊网络服务(AWS)的首席生成式AI专家解决方案架构师,他指导企业制定全面的AI实施策略,并建立跨企业扩展AI所需的基础能力。

Dan MacKay 是AWS加拿大的金融服务合规专家。他就云相关的治理、风险和合规的最佳实践和实用解决方案向客户提供建议。Dan专注于帮助AWS客户应对适用于加拿大云技术使用的金融服务和隐私法规,重点关注第三方风险管理和运营弹性。

Dan MacKay 是AWS加拿大的金融服务合规专家。他就云相关的治理、风险和合规的最佳实践和实用解决方案向客户提供建议。Dan专注于帮助AWS客户应对适用于加拿大云技术使用的金融服务和隐私法规,重点关注第三方风险管理和运营弹性。

Melanie Li 博士是位于澳大利亚悉尼的AWS高级生成式AI专家解决方案架构师,她的重点是与客户合作,利用最先进的AI/ML工具构建解决方案。她积极参与亚太及日本地区的多个生成式AI项目,利用大型语言模型(LLM)的强大功能。在加入AWS之前,李博士曾在金融和零售行业担任数据科学职位。

Melanie Li 博士是位于澳大利亚悉尼的AWS高级生成式AI专家解决方案架构师,她的重点是与客户合作,利用最先进的AI/ML工具构建解决方案。她积极参与亚太及日本地区的多个生成式AI项目,利用大型语言模型(LLM)的强大功能。在加入AWS之前,李博士曾在金融和零售行业担任数据科学职位。

Serge Malikov 是一名驻扎在加拿大的高级解决方案架构师经理。他的重点是金融服务行业。

Serge Malikov 是一名驻扎在加拿大的高级解决方案架构师经理。他的重点是金融服务行业。

Saurabh Trikande 是Amazon Bedrock和Amazon SageMaker推理的高级产品经理。他对与客户和合作伙伴合作充满热情,目标是实现AI的民主化。他专注于部署复杂AI应用的相关的核心挑战、多租户模型的推理、成本优化,以及使生成式AI模型的部署更加便捷。在业余时间,Saurabh喜欢徒步旅行、学习创新技术、关注TechCrunch,并与家人共度时光。

Saurabh Trikande 是Amazon Bedrock和Amazon SageMaker推理的高级产品经理。他对与客户和合作伙伴合作充满热情,目标是实现AI的民主化。他专注于部署复杂AI应用的相关的核心挑战、多租户模型的推理、成本优化,以及使生成式AI模型的部署更加便捷。在业余时间,Saurabh喜欢徒步旅行、学习创新技术、关注TechCrunch,并与家人共度时光。

Sharadha Kandasubramanian 是Amazon Bedrock的高级技术项目经理。她为Amazon Bedrock推动跨职能的GenAI项目,使客户能够发展和扩展他们的GenAI工作负载。工作之余,她是一位狂热的跑步者和骑自行车者,喜欢在阳光下享受户外时光。

Sharadha Kandasubramanian 是Amazon Bedrock的高级技术项目经理。她为Amazon Bedrock推动跨职能的GenAI项目,使客户能够发展和扩展他们的GenAI工作负载。工作之余,她是一位狂热的跑步者和骑自行车者,喜欢在阳光下享受户外时光。

🚀 想要体验更好更全面的AI调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,文档丰富,小白也可以简单操作。

评论区