📢 转载信息

原文链接:https://blogs.nvidia.com/blog/rtx-ai-garage-nexa-hyperlink-local-agent/

原文作者:Gerardo Delgado

基于大型语言模型(LLM)的人工智能助手是强大的生产力工具,但如果没有正确的上下文和信息,它们可能难以提供细致且相关的答案。虽然大多数基于LLM的聊天应用程序允许用户提供一些文件作为上下文,但它们通常无法访问用户PC中幻灯片、笔记、PDF和图像中隐藏的所有信息。

Nexa.ai的Hyperlink是一个本地AI代理,旨在解决这一挑战。它能够快速索引数千个文件,理解用户问题的意图,并提供情境化、定制化的见解。

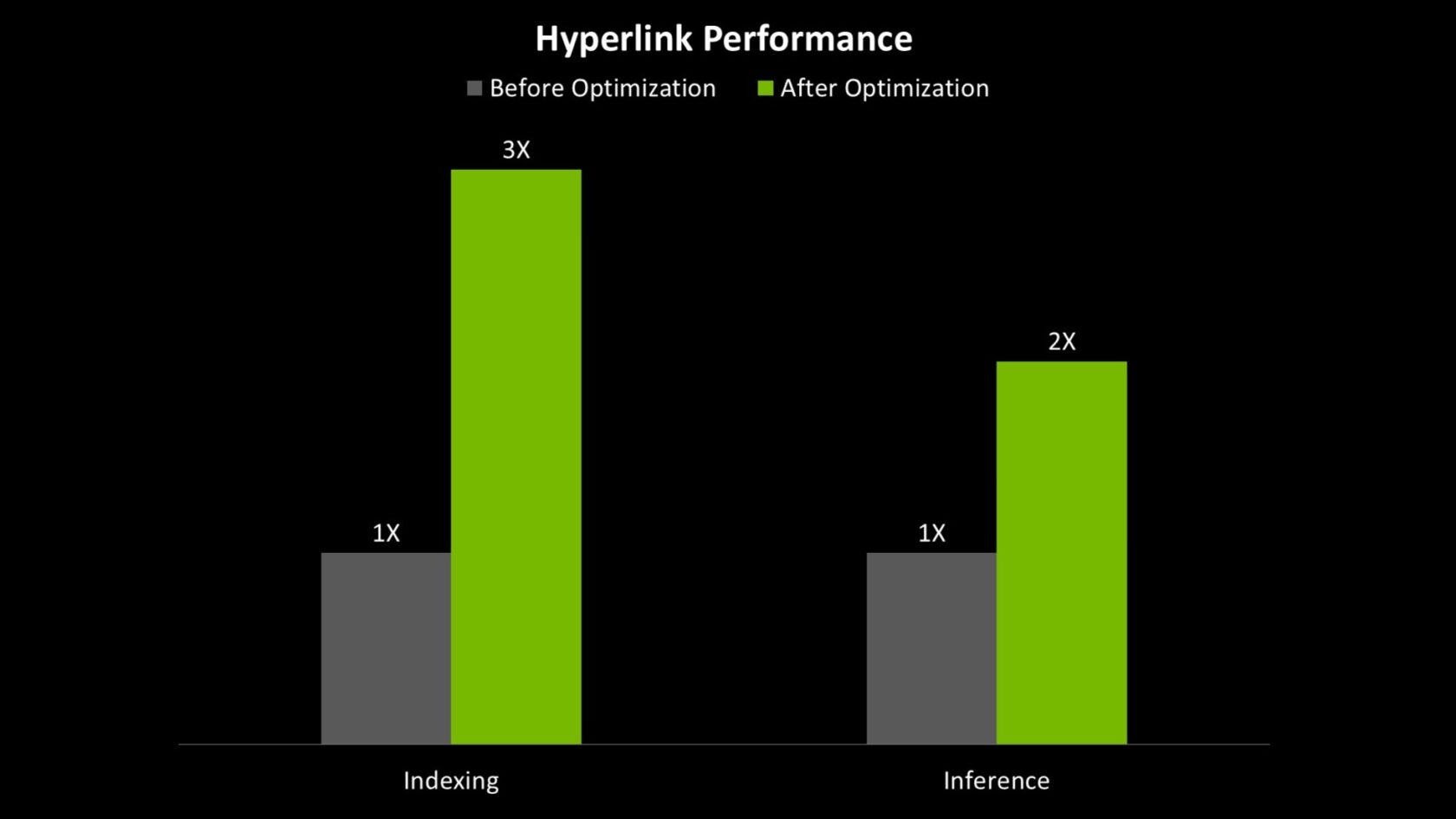

今天发布的新版本应用程序中包含了针对NVIDIA RTX AI PC的加速功能,使检索增强生成(RAG)的索引速度提高了三倍。例如,一个以前需要近15分钟才能完成索引的1GB密集文件夹,现在只需四到五分钟即可准备好进行搜索。此外,LLM推理速度也提高了2倍,从而加快了对用户查询的响应速度。

将本地数据转化为即时智能

Hyperlink使用生成式AI来搜索数千个文件以获取正确信息,它能理解用户查询的意图和上下文,而不仅仅是进行关键词匹配。

为此,它会为用户指定的所有本地文件创建一个可搜索的索引——无论是很小的文件夹还是计算机上的每一个文件。用户可以用自然语言描述他们要查找的内容,并从文档、幻灯片、PDF和图像中找到相关内容。

例如,如果用户请求“一份比较两本小说主题的科幻书籍报告”的帮助,Hyperlink可以找到相关信息——即使它保存在一个名为“Lit_Homework_Final.docx”的文件中。

通过结合搜索和RTX加速的LLM的推理能力,Hyperlink能根据用户文件中的见解来回答问题。它连接不同来源的想法,识别文档间的关系,并生成有清晰引用的、推理充分的答案。

所有用户数据都保留在设备上并保持私密。这意味着个人文件永远不会离开计算机,因此用户无需担心敏感信息被发送到云端。他们可以在不牺牲控制权或安心感的情况下,享受到强大AI带来的益处。

专业人士、学生和创作者已经在采用Hyperlink来完成以下工作:

- 准备会议:总结笔记和转录文本中的关键讨论点。

- 分析报告:获取研究充分的答案,并引用行业报告中的关键数据点。

- 内容创作:整理多年来保存的笔记和草稿中的写作或视频创意。

- 更智能地学习:在备考时复习关键概念,同时搜索讲义、幻灯片和教程——所有内容同步进行。

- 整理收据:对扫描文档进行分类并自动完成费用报告。

- 更快调试:搜索代码中的文档和注释,以解决错误或版本冲突。

请下载Hyperlink应用程序,开始在RTX PC上体验AI搜索。

在Facebook、Instagram、TikTok和X上关注NVIDIA AI PC——并通过订阅RTX AI PC新闻通讯随时了解最新信息。在LinkedIn和X上关注NVIDIA Workstation。

请参阅有关软件产品信息的声明。

评论区